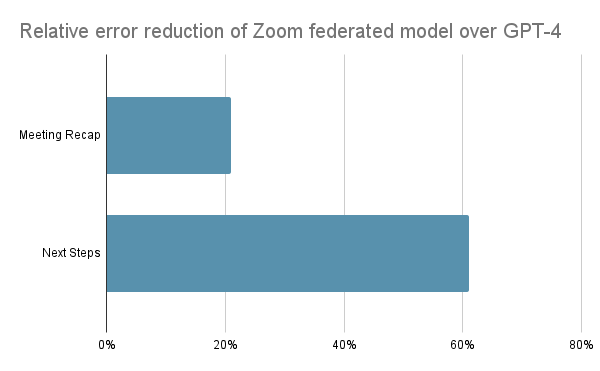

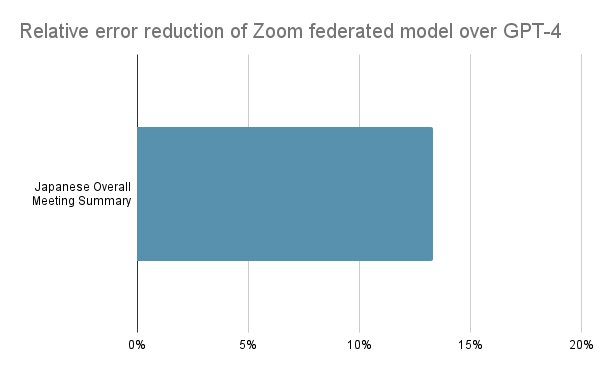

En novembre 2023, j’expliquais comment l’approche fédérée de Zoom en matière d’IA avait permis d’atteindre une qualité quasi égale à celle d’OpenAI GPT-4, pour seulement 6 % du coût d’inférence. Nous sommes aujourd’hui parvenus à améliorer ces résultats déjà impressionnants et à surpasser GPT-4 avec nos fonctionnalités de réunion les plus populaires. Lors des tests comparatifs à l’aveugle avec validation humaine que nous avons menés en interne, Zoom AI Companion a permis de diminuer le nombre d’erreurs relatives de plus de 20 % (pour les résumés de réunion dans Zoom) et de 60 % (pour les prochaines étapes) par rapport à l’IA d’OpenAI.

Afin d’améliorer la qualité d’exécution des tâches et d’offrir des résultats encore plus pertinents, nous avons combiné plusieurs grands modèles de langage (LLM) avancés Open Source et à source fermée pour notre approche fédérée exclusive de l’IA. D’autres fournisseurs, au contraire, sont liés à des LLM spécifiques, comme GPT-4 pour Microsoft Copilot ou Gemini pour Google.

Zoom AI Companion se démarque avec une approche de l’IA offrant une expérience de qualité supérieure aux utilisateurs de nos fonctionnalités les plus appréciées. Comme je l’évoquais dernièrement, nous utilisons un outil propriétaire, Z-scorer, pour évaluer la qualité des résultats générés par notre IA. Un LLM pertinent et abordable est d’abord déployé pour chaque tâche. Ensuite, le Z-scorer analyse la qualité du résultat initial. Et si besoin, nous appliquons un LLM supplémentaire pour affiner la tâche. Ce processus permet d’obtenir un résultat de meilleure qualité, de la même manière qu’un groupe d’individus peut accomplir plus qu'une personne seule.

Depuis, nous avons amélioré le Z-scorer en incorporant d’autres signaux de qualité issus de différents LLM, et optimisé l’apprentissage fédéré par renforcement afin de mieux refléter les préférences humaines. Grâce à l’association de notre propre LLM avec plusieurs LLM complémentaires, la très appréciée fonctionnalité de synthèse de réunion de Zoom renvoie des résultats de grande qualité. Nos derniers tests comparatifs ont d’ailleurs révélé que celle-ci dépasse désormais les performances de GPT-4, l’IA qui alimente Copilot dans Microsoft Teams.

Concernant la sécurité de l’IA, nous avons également réduit les biais inhérents à la plupart des LLM en regroupant plusieurs grands modèles de langage tels que Claude-3, Gemini et GPT-4 afin de limiter le nombre d’hallucinations et d’améliorer notre propre LLM. Parce qu’il y a peu de chances que des LLM différents génèrent la même hallucination, ce mécanisme produit des réponses plus cohérentes et diminue l’impact des anomalies.