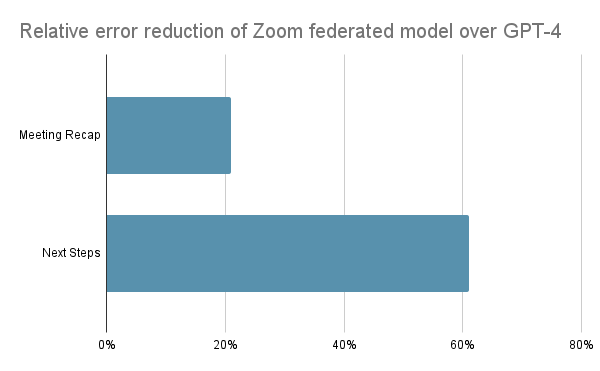

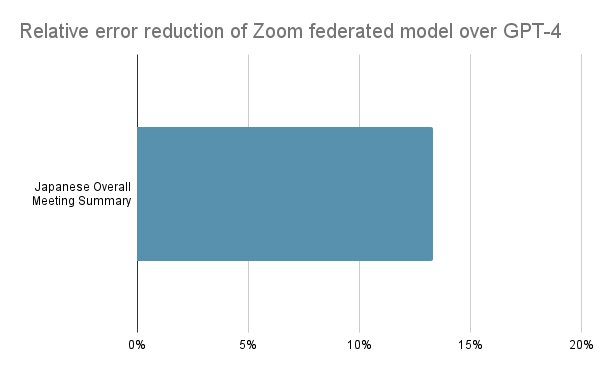

I november 2023 berättade jag hur Zooms federerade AI-metod uppnådde nästan samma kvalitet som OpenAI GPT-4 med bara 6 % av inferenskostnaden. Även om dessa resultat var imponerande kan vi nu leverera ännu bättre AI-kvalitet jämfört med OpenAI:s GPT-4 för våra mest populära mötesfunktioner. Zoom AI Companion minskade de relativa felen med över 20 % (för ”referat” i Zoom-mötessammanfattningen) och 60 % (för ”nästa steg”) jämfört med GPT-4 i vårt interna jämförande blindtest som validerats av människor.

Som stöd för våra utbildningsinsatser för att förbättra kvaliteten på slutförandet av uppgifter utnyttjar vår unika federerade strategi för AI många avancerade stora språkmodeller (LLM:er) med sluten och öppen källkod som arbetar tillsammans för bättre resultat. Detta till skillnad från andra leverantörer som är knutna till specifika LLM:er. Till exempel har Microsoft Copilot förlitat sig på GPT-4 och Google har förlitat sig på Gemini.

Detta synsätt på AI särskiljer Zoom AI Companion och ger våra kunder en högkvalitativ upplevelse med våra mest populära funktioner. Som jag berättade i min senaste uppdatering använder vi vår egenutvecklade Z-poängräknare för att bedöma kvaliteten på våra AI-genererade resultat. Först använder vi en LLM med lägre kostnad som är bäst lämpad för varje uppgift. Därefter utvärderar vår Z-poängräknare kvaliteten på det initiala slutförandet av uppgiften. Vid behov kan vi använda en annan kompletterande LLM för att finjustera uppgiften. Denna process resulterar i en högre kvalitet på samma sätt som ett team av människor kan åstadkomma mer tillsammans än en enskild individ.

Vi har sedan dess förbättrat vår Z-poängräknare genom att införliva ytterligare kvalitetssignaler från en rad olika LLM:er. För att bättre anpassa oss till människors preferenser förbättrade vi också federerad förstärkningsinlärning. Genom att federera Zooms LLM i kombination med en uppsättning kompletterande LLM:er kan Zooms populära mötessammanfattning leverera högkvalitativa resultat och, enligt vår senaste jämförelse, kan den nu överträffa GPT-4, som används för att driva Copilot i Microsoft Teams.

När det gäller AI-säkerhet minskade vi också den inneboende partiskheten i de flesta LLM:er genom att bilda en kommitté bestående av flera LLM:er som Claude-3, Gemini och GPT-4 för att minska hallucinationer och förbättra vår Zoom-LLM. Till exempel är det osannolikt att olika LLM:er gör samma hallucinationsmisstag, så vi kan generera mer konsekventa svar och minska effekten av avvikande värden.