Poznaj Zoom AI Companion, Twojego nowego asystenta AI!

Zwiększ produktywność i usprawnij współpracę zespołową dzięki Zoom AI Companion, asystentowi AI dostępnemu bez dodatkowych kosztów w ramach kwalifikujących się płatnych planów Zoom.

CTO Zoom, Xuedong Huang, wyjaśnia, jak małe modele językowe (SLM, ang. Small Language Model) napędzają naszą wizję współpracy agentów AI w ramach podejścia federacyjnego, aby usprawnić codzienne zadania.

Aktualizacja: February 25, 2025

Opublikowano February 19, 2025

Xuedong Huang jest dyrektorem ds. technologii (CTO). Przed dołączeniem do Zoom pracował w firmie Microsoft, gdzie pełnił funkcję dyrektora ds. technologii i pracownika technicznego ds. sztucznej inteligencji dla platformy Azure. Jego kariera w przestrzeni sztucznej inteligencji jest wybitna: w 1993 r. założył grupę ds. technologii mowy w firmie Microsoft, kierował zespołami ds. sztucznej inteligencji w firmie Microsoft, które osiągnęły kilka pierwszych w branży kamieni milowych w zakresie rozpoznawania mowy na poziomie ludzkim, tłumaczenia maszynowego, rozumienia języka naturalnego i widzenia komputerowego, jest członkiem IEEE i ACM oraz wybranym członkiem Narodowej Akademii Inżynierii i Amerykańskiej Akademii Sztuki i Nauki.

Xuedong uzyskał tytuł doktora nauk ekonomicznych na Uniwersytecie w Edynburgu w 1989 r. (sponsorowany przez brytyjski ORS i stypendium Uniwersytetu w Edynburgu), tytuł magistra informatyki na Uniwersytecie Tsinghua w 1984 r. oraz licencjat z informatyki na Uniwersytecie Hunan w 1982 r.

W Zoom koncentrujemy się na innowacjach, co napędza naszą ciągłą eksplorację opartej na sztucznej inteligencji transformacji realizowanej z wykorzystaniem AI Companion Zoom. W zeszłym roku podzieliłem się tym, jak nasze podejście federacyjne zapewnia wysokiej jakości wyniki oraz jak nasze skupienie na jakości rozpoznawania mowy tworzy lepszą podstawę dla naszych innych funkcji AI. W miarę jak sztuczna inteligencja się rozwija, przyspieszamy wdrażanie Agentowej AI.

Dotychczas sztuczna inteligencja polegała na dużych modelach językowych (LLM, ang. Large Language Model), aby odpowiadać na zapytania użytkowników i dostarczać generowane odpowiedzi. Jednak istnieje znacznie więcej możliwości, gdy rozważamy, jak SLM mogą umożliwiać korzystanie z dostosowanych agentów AI. Tworzymy AI Companion, aby wspierać Agentową AI w zarządzaniu serią wieloetapowych działań w Twoim imieniu.

Gdy postrzegamy sztuczną inteligencję jako agenty, a nie jako samodzielne umiejętności i odpowiedzi, oznacza to, że wykraczają one poza wprowadzanie promptów celem dostarczania prostych wyników i powinny być rozszerzeniem nas samych oraz naszych celów. Aby to zrobić, nasze agenty AI mają następujące cechy charakterystyczne:

Aby pomóc w urzeczywistnieniu takich agentów AI, z radością ogłaszamy znaczący kamień milowy w tej podróży: nasz nowo opracowany mały model językowy (SLM) osiągnął wydajność zgodną z najnowszym stanem wiedzy w kategorii 2 miliardów parametrów w publicznym rankingu wyników testów porównawczych. Dzięki dostosowywaniu za pomocą nadchodzącego AI Studio Zoom, projektujemy modele SLM Zoom, aby osiągnąć jakość wiodącego w branży LLM w specjalistycznych zastosowaniach. To utoruje drogę dla AI Companion do wykonywania złożonych zadań Agentowej AI z wieloma agentami AI, a ich współpraca przyniesie niezrównaną opłacalność.

W federacyjnym podejściu Zoom do sztucznej inteligencji, zamiast polegać na jednym, kompleksowym dużym modelu, opowiadamy się za orkiestracją wielu dostosowanych modeli. Modele SLM Zoom zostały zaprojektowane, aby ulepszyć to podejście poprzez optymalizację dla konkretnych zadań. Rozdzielając obciążenia między dostosowane SLM z odpowiednimi agentami, a jednocześnie wykorzystując wiodące LLM, dążymy do osiągnięcia kilku istotnych korzyści:

Przyjrzyjmy się temu, co oznacza ten przełom i jak dokładnie wypada na tle wiodących modeli.

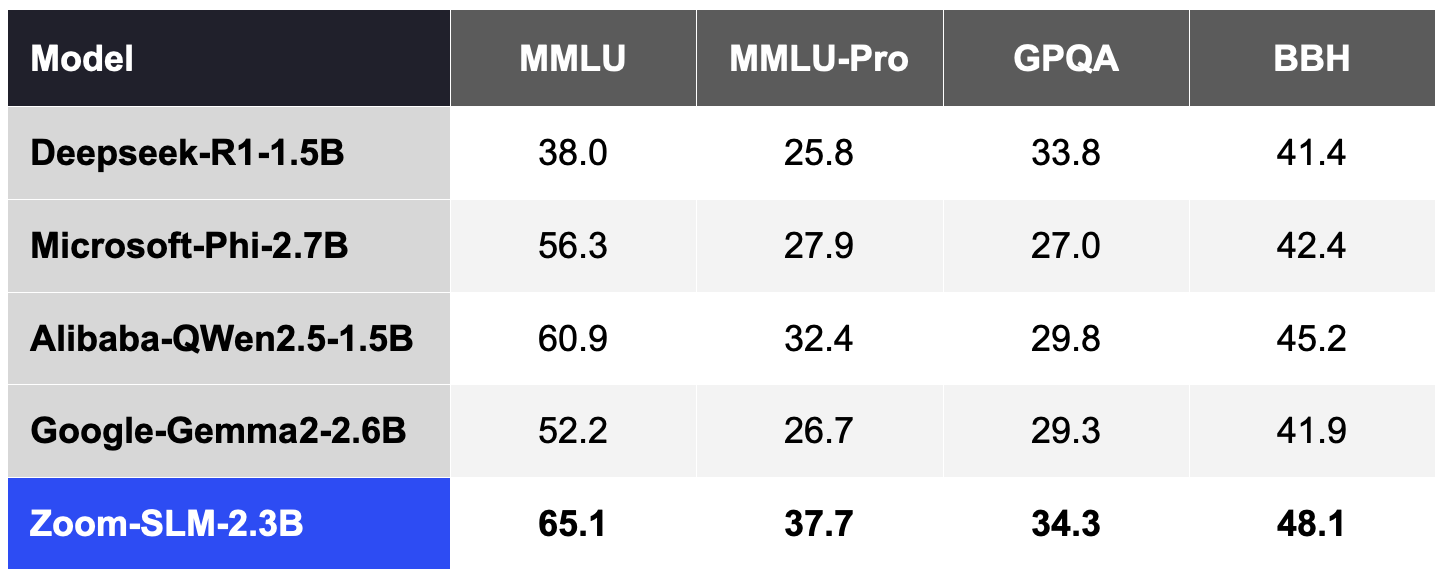

Aby opracować SLM Zoom, użyliśmy 6 bilionów tokenów danych wielojęzycznych i 256 procesorów graficznych Nvidia H100. Od początku do końca cały cykl szkolenia trwał około 30 dni. Poniższe tabele opisują, jak zdolności SLM Zoom wypadają na tle innych modeli w kilku publicznych testach porównawczych opartych na naszych wewnętrznych testach.

Zgodnie z powszechną praktyką społeczności oceniliśmy dokładność tych testów porównawczych za pomocą narzędzia Lighteval, które dostarczyło 5 zestawów przykładów dla MMLU i MMLU-Pro, 2 zestawy przykładów dla GPQA i 3 zestawy przykładów dla BBH.

Tabela 1. Zoom SLM w porównaniu z innymi modelami SLM w kategorii 2B (im wyższe wyniki, tym lepiej).

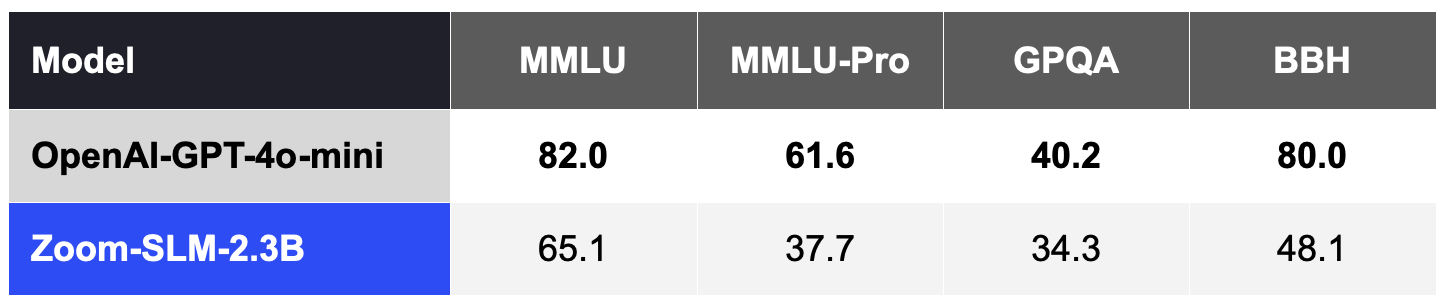

Ogólnie rzecz biorąc, SLM-y — bez dostosowania do konkretnej dziedziny lub zadania — pozostają mniej konkurencyjne w tych miarach jakości niż wiodące LLM-y, takie jak GPT-4o-mini OpenAI, co pokazano w tabeli 2.

Tabela 2. SLM Zoom, bez dostosowywania, jest mniej konkurencyjny w porównaniu do LLM-ów poza kategorią 2B, takich jak OpenAI GPT 4o-mini.

Jednak najciekawszym wynikiem jest to, że te SLM-y mogą oferować wyjątkowe możliwości, gdy są dostosowane do specjalistycznego zadania. Dzięki dostosowaniu za pomocą AI Studio Zoom spodziewamy się skutecznie zmniejszyć lukę jakościową w porównaniu z droższymi LLM. Dostosowane SLM mogą działać jako wyspecjalizowane agenty do wykonywania kluczowych zadań we współpracy z LLM, priorytetowo traktując poprawę dokładności, szybkości i opłacalności dla każdego agenta AI.

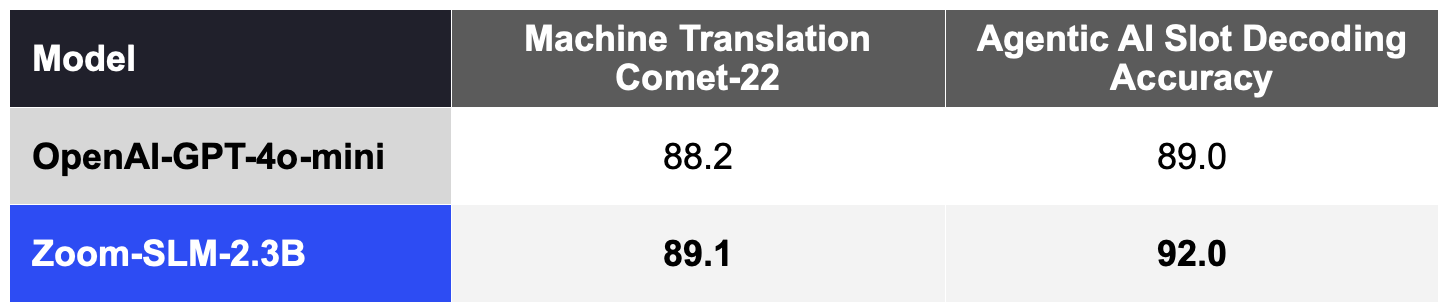

Dostosowane SLM mogą wyróżniać się w zadaniach, takich jak tłumaczenie maszynowe. Dzięki dostosowaniu SLM z użyciem 11,5 miliarda tokenów (w tym danych syntetycznych) zaprojektowanych do tłumaczenia maszynowego, znacznie poprawiliśmy szeroko przyjęte wskaźniki jakości COMET-22 w 14 parach językowych, obejmujących główne języki, takie jak chiński, angielski, francuski, japoński, portugalski i hiszpański , jak pokazano w tabeli 3.

Nasze SLM-y można również dostosować do obsługi testu porównawczego AI Companion dla Agentowej AI do dekodowania slotów, który mierzy, jak dobrze model interpretuje polecenia użytkownika podczas wykonywania akcji. Dzięki 2 miliardom syntetycznych tokenów danych domeny Agentowej AI, dostosowany SLM również przewyższa GPT-4o-mini, jak pokazano w tabeli 3.

To połączenie wydajności i zdolności adaptacyjnych ma na celu umożliwienie Zoom dostarczenia znacznie ulepszonego tłumaczenia maszynowego naszym klientom na całym świecie, a także wsparcie dostosowywania Zoom AI Studio do określonych obciążeń Agentowej AI.

Tabela 3. Dostosowany SLM Zoom w porównaniu do OpenAI GPT-4o-mini w specjalistycznych obciążeniach, wyższe wyniki są lepsze.

Te dostosowane SLM będą stanowić trzon naszych agentów AI, działając bardziej efektywnie i osiągając wyniki porównywalne do droższych LLM, z których obecnie korzystają ludzie. Dzięki naszej federacyjnej sztucznej inteligencji te agenty i umiejętności AI pomogą osiągnąć niezrównaną wydajność i dokładność oraz doprowadzą do obniżenia kosztów.

Jesteśmy dumni z naszych postępów, a to dopiero początek. Naszą wizją jest wyposażenie każdej organizacji w agenty AI, które dostarczają opłacalne i wysokowydajne rozwiązania. Dzięki dodatkowym możliwościom agentów AI i modelom SLM rozwiązanie AI Companion pomoże Ci stworzyć miejsce pracy, w którym możesz zrobić więcej i pracować efektywniej.