Informe de rendimiento de vídeo y audio de Zoom 2024

La calidad de audio y vídeo es fundamental en la experiencia de las reuniones virtuales. Cuando una u otra está por debajo de lo esperado o incluso no funciona, la experiencia del usuario se ve afectada, lo que genera frustración. En Zoom, siempre queremos saber cómo se compara Zoom Meetings con otras soluciones de reuniones. Por eso, le pedimos a TestDevLab que comparara la calidad de vídeo y audio en diversas condiciones y tipos de llamada para los siguientes proveedores:

- Zoom

- Microsoft Teams

- Google Meet

- Cisco Webex

Los hallazgos que se presentan en este informe reflejan los resultados de las pruebas de TestDevLab de abril de 2024.

Acerca de TestDevLab

TestDevLab (TDL) ofrece servicios de pruebas de software y control de calidad para aplicaciones móviles, web y de escritorio, así como el desarrollo de herramientas de prueba personalizadas. Se especializan en pruebas de software y control de calidad, y desarrollan soluciones personalizadas avanzadas para pruebas de seguridad, batería y uso de datos de aplicaciones móviles. Además, ofrecen evaluaciones de calidad de vídeo y audio para aplicaciones y productos de VoIP o comunicaciones para API de backend automatizada, así como pruebas de carga y rendimiento web.

El equipo de TestDevLab está compuesto por más de 500 ingenieros altamente experimentados que se dedican a pruebas y desarrollo de software. La mayoría de sus ingenieros de pruebas poseen certificaciones de la International Software Testing Qualifications Board (ISTQB), lo que garantiza un alto nivel de experiencia en pruebas de software conforme a los estándares del sector y la calidad del servicio.

Con el fin de asegurar una evaluación justa para todos los proveedores, las pruebas se llevaron a cabo con equipos y cuentas de TestDevLab. Además, las cuentas individuales de cada proveedor se mantuvieron con la configuración predeterminada, con la única excepción de habilitar una resolución máxima HD (1080p) en aquellos proveedores que, por defecto, limitan la resolución de vídeo.

Los escenarios de prueba incluyeron un dispositivo «receptor», un dispositivo «transmisor» y otros dispositivos que actuaron como participantes adicionales. Todos los dispositivos estaban conectados a la misma videollamada. En función del escenario de prueba, se configuraron la disposición de las llamadas y la red para reproducir los parámetros de prueba requeridos.

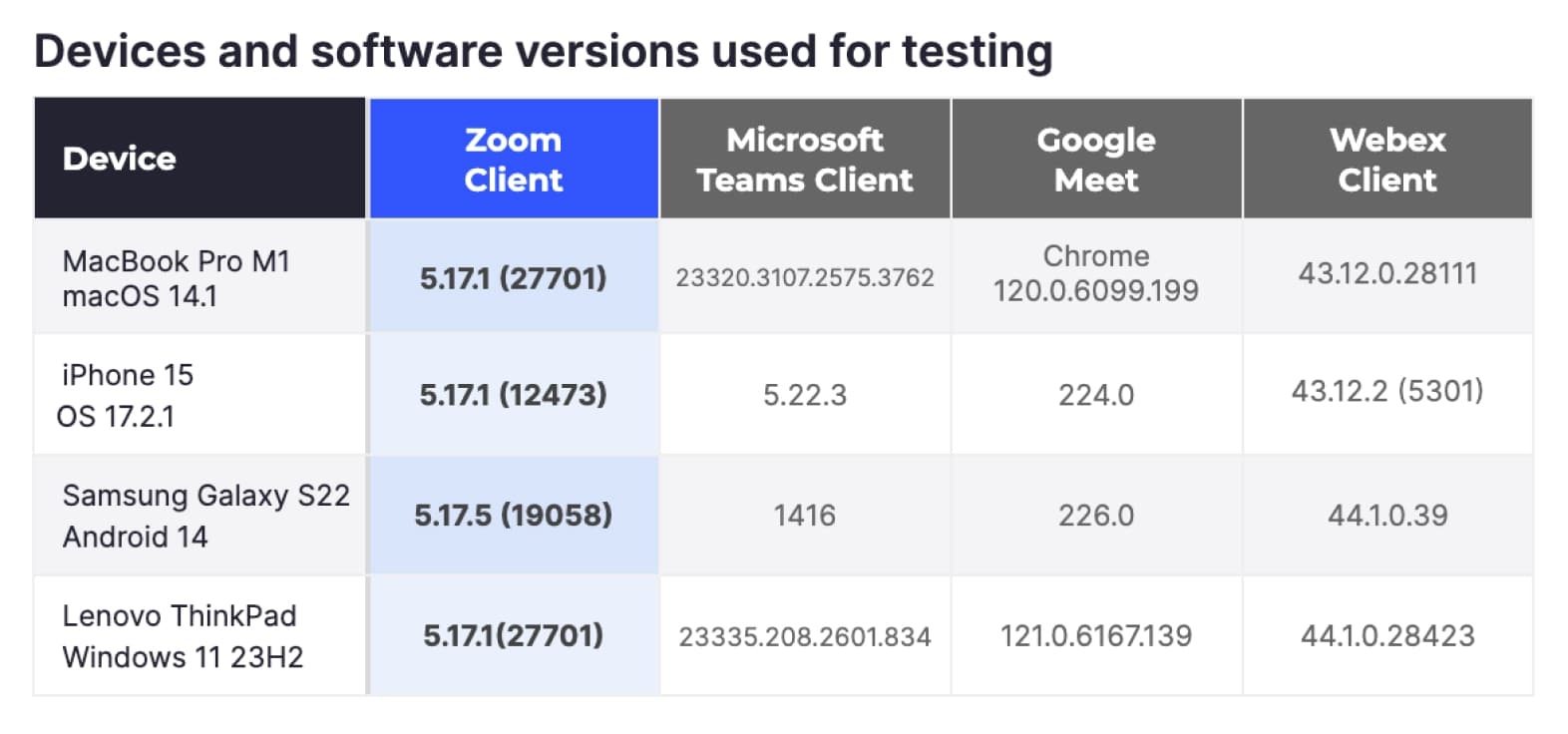

Dispositivos y versiones de software utilizados para pruebas

Escenarios de prueba

Para proporcionar una visión general de la calidad de vídeo y audio en Meetings, pedimos a TDL que probara los escenarios de reuniones más comunes con hardware de uso común.

Escenarios de red variables

En estos escenarios, el objetivo fue evaluar cómo reaccionan las distintas plataformas ante diversas condiciones de red, utilizando algunos entornos de cómputo habituales. Para lograr este objetivo, TDL utilizó cuatro plataformas de hardware comunes: equipos MacBook Pro, equipos Windows, iPhones y dispositivos Android. Configuramos el tipo de reunión más común con tres participantes, sin contenido compartido y una configuración de vista del presentador/orador para maximizar la resolución de vídeo.

Los escenarios de red que se probaron incluyeron los siguientes:

- Red óptima: sin limitación de red, se usa como referencia.

- Red limitada a 1 Mbps: el ancho de banda de la red está limitado a 1 Mbps.

- Red limitada a 500 Kbps: el ancho de banda de la red está limitado a 500 Kbps.

- Pérdida de paquetes variable: las reuniones comenzaron con una pérdida de paquetes del 10 %, aumentaron al 20 % después de 1 minuto y, luego, al 40 % después de un minuto más.

- Latencia variable: las reuniones comienzan sin limitaciones. Tras 1 minuto, se introducen 100 ms de latencia y 30 ms de jitter durante 1 minuto. Luego, la latencia aumenta a 500 ms y el jitter a 90 ms.

- Recuperación de red: las reuniones comenzaron sin limitaciones. Después de 1 minuto, se simuló un problema de red que limitó el ancho de banda a 1 Mbps, agregó una pérdida de paquetes del 10 % e introdujo 100 ms de latencia y 30 ms de jitter durante 1 minuto. Luego, se volvió a una condición de red óptima.

- Red móvil 3G: se realizó una videollamada en la red móvil 3G solo en dispositivos móviles.

- Prueba de red congestionada: la llamada comienza con una red óptima y, luego, en varios intervalos, se envía una breve ráfaga de datos de gran volumen a través de la red para simular una red congestionada.

Cada llamada duró tres minutos y el proceso se repitió cinco veces. Con todos los proveedores, variaciones de hardware y condiciones de red, TDL realizó 420 reuniones.

Al limitar las llamadas, las restricciones se aplicaron únicamente al dispositivo bajo prueba cuando este funcionaba como «receptor».

Escenarios de tipos de llamadas variables

Para estos escenarios, queríamos probar los distintos tipos de llamadas y tecnologías que utilizan la mayoría de los usuarios. El hardware utilizado se limitó a MacBook Pro M1 y equipos Windows. Los escenarios incluían reuniones de cinco y ocho personas organizadas en modo galería. TDL probó reuniones solo con participantes, reuniones con intercambio de contenido y reuniones donde los participantes activaron fondos virtuales.

En todos los casos, la red se mantuvo óptima y sin restricciones. Al igual que antes, cada reunión duró tres minutos y el proceso se repitió cinco veces. En total, TDL organizó 240 reuniones adicionales en esta categoría.

Métricas registradas

Para generar un panorama completo de la calidad de las reuniones, pedimos a TDL que registrara métricas en cuatro categorías principales relacionadas con la calidad de vídeo y audio, la utilización de la red y el uso de recursos. Las métricas se registraron cada segundo de la reunión y se guardaron en una base de datos centralizada.

Calidad de audio

- Puntuación MOS: la puntuación media de opinión (MOS) cuantifica la calidad de las llamadas en función de las valoraciones de usuarios humanos, normalmente en una escala del 1 (mala) al 5 (excelente), lo que refleja la claridad de audio percibida y la experiencia general.

- ViSQOL: ViSQOL (Virtual Speech Quality Objective Listener) es una métrica objetiva que evalúa la calidad de la llamada al comparar la similitud entre la señal de audio original y la transmitida mediante un modelo perceptual.

- Retraso de audio: el retraso de audio mide la latencia entre la palabra hablada y la recepción del oyente, los valores más bajos indican retraso y los más altos una mayor calidad de la llamada.

Calidad de vídeo

- Fotogramas por segundo (FPS): los fotogramas por segundo (FPS) miden el número de fotogramas individuales que se muestran por segundo en un vídeo. Un mayor número de FPS proporciona un movimiento más fluido y una mejor calidad de vídeo.

- VMAF: Video Multi-method Assessment Fusion (VMAF) es una métrica perceptual de calidad de vídeo desarrollada por Netflix que combina múltiples métricas de calidad para predecir la satisfacción del espectador y la calidad del vídeo.

- VQTDL: Video Quality Temporal Dynamics Layer (VQTDL), desarrollada por TDL, evalúa la calidad del vídeo al analizar las variaciones y dinámicas temporales, al capturar cómo los cambios a lo largo del tiempo afectan a la experiencia global de visualización del vídeo.

- PSNR: la relación señal-ruido máxima (PSNR) es una métrica matemática que se usa para medir la calidad de un vídeo al comparar los fotogramas del vídeo original y comprimido, donde los valores más altos indican menos distorsión y mejor calidad.

- Retraso de vídeo: el retraso de vídeo se refiere al retraso temporal entre la captura real del vídeo en vivo y su visualización en la pantalla remota. Los retrasos reducidos permiten disfrutar de una experiencia de reunión más fluida y en tiempo real.

- Congelación del vídeo: la congelación del vídeo mide la frecuencia y duración de las pausas o interrupciones en el flujo de vídeo; una menor cantidad y duración de estos problemas indica una mejor calidad de vídeo.

Utilización de recursos

- La utilización de la CPU mide el porcentaje de la capacidad de la unidad central de procesamiento (CPU) que utiliza un cliente de la reunión.

- El uso de memoria se refiere a la cantidad de memoria de acceso aleatorio (RAM) que consume un cliente de la reunión.

- La utilización de la GPU mide el porcentaje de la capacidad de la unidad de procesamiento gráfico (GPU) que está utilizando el cliente de la reunión.

Utilización de la red

- Tasa de bits del emisor: es la cantidad de datos de red que se envían desde cada máquina en la reunión.

- Tasa de bits del receptor: es la cantidad de datos de red que recibe cada máquina en la reunión.

No todas las métricas pueden registrarse en todas las plataformas. Por ejemplo, no todas las métricas de utilización de recursos pueden registrarse en dispositivos móviles. TDL maximizó el registro de métricas en cada escenario de llamada.

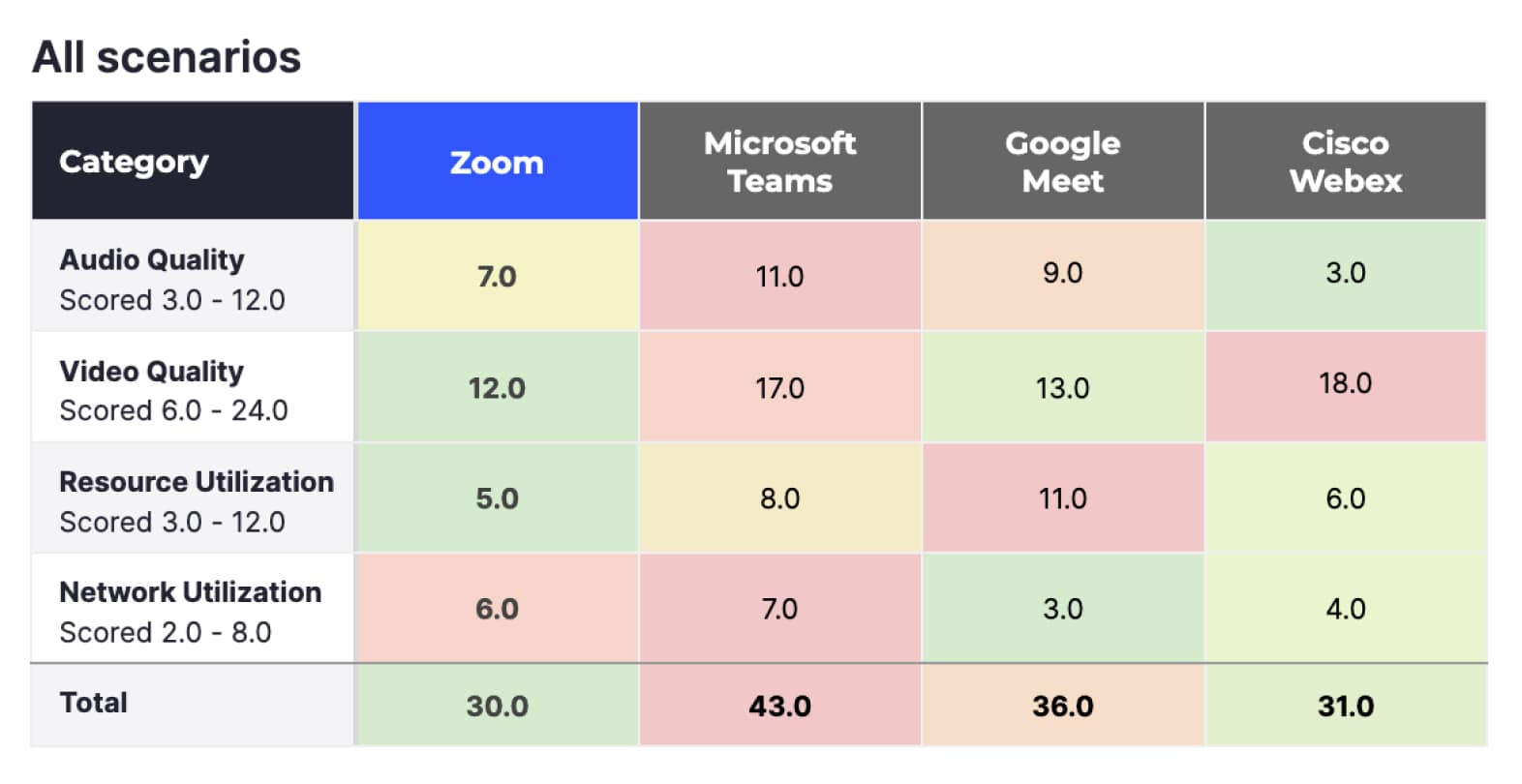

Para simplificar la presentación de la gran cantidad de información recopilada por TDL, puntuamos cada una de las métricas anteriores en una escala del 1 al 4, en la que 1 es la mejor puntuación y 4 la peor. Luego, sumamos las puntuaciones de las métricas en las cuatro categorías. Los totales más bajos representan las mejores puntuaciones de calidad de cada categoría.

En esta sección se exploran los resultados a un alto nivel con varios filtros aplicados para centrarse en las diferentes categorías de llamadas. Más adelante, nos centraremos en escenarios de llamadas individuales y proporcionaremos información más detallada sobre el comportamiento de las distintas plataformas en esos escenarios. Consulte «Resultados detallados» para obtener más información.

Los resultados anteriores incluyen las puntuaciones de las 660 reuniones, lo que incluye todos los dispositivos y escenarios de red:

- Al considerar todas las métricas, Zoom obtuvo la mejor puntuación (30), seguido de cerca por Cisco Webex (31). Google Meet (36) y Microsoft Teams (43) obtuvieron peores puntuaciones en comparación.

- Zoom obtuvo la mejor puntuación en calidad de vídeo y utilización de recursos (12 y 5, respectivamente). Zoom rindió mejor en esta prueba porque Zoom Meetings descarga la mayoría de las funciones de procesamiento de vídeo de la CPU a la GPU, lo que hace que la CPU quede libre para ejecutar otras aplicaciones en el dispositivo.

- En utilización de la red, Google Meet (3) obtuvo la mejor puntuación.

- En calidad de audio, Cisco Webex obtuvo la mejor puntuación (3), seguido de Zoom (7). Google Meet (9) y Microsoft Teams (11) obtuvieron peores puntuaciones en comparación.

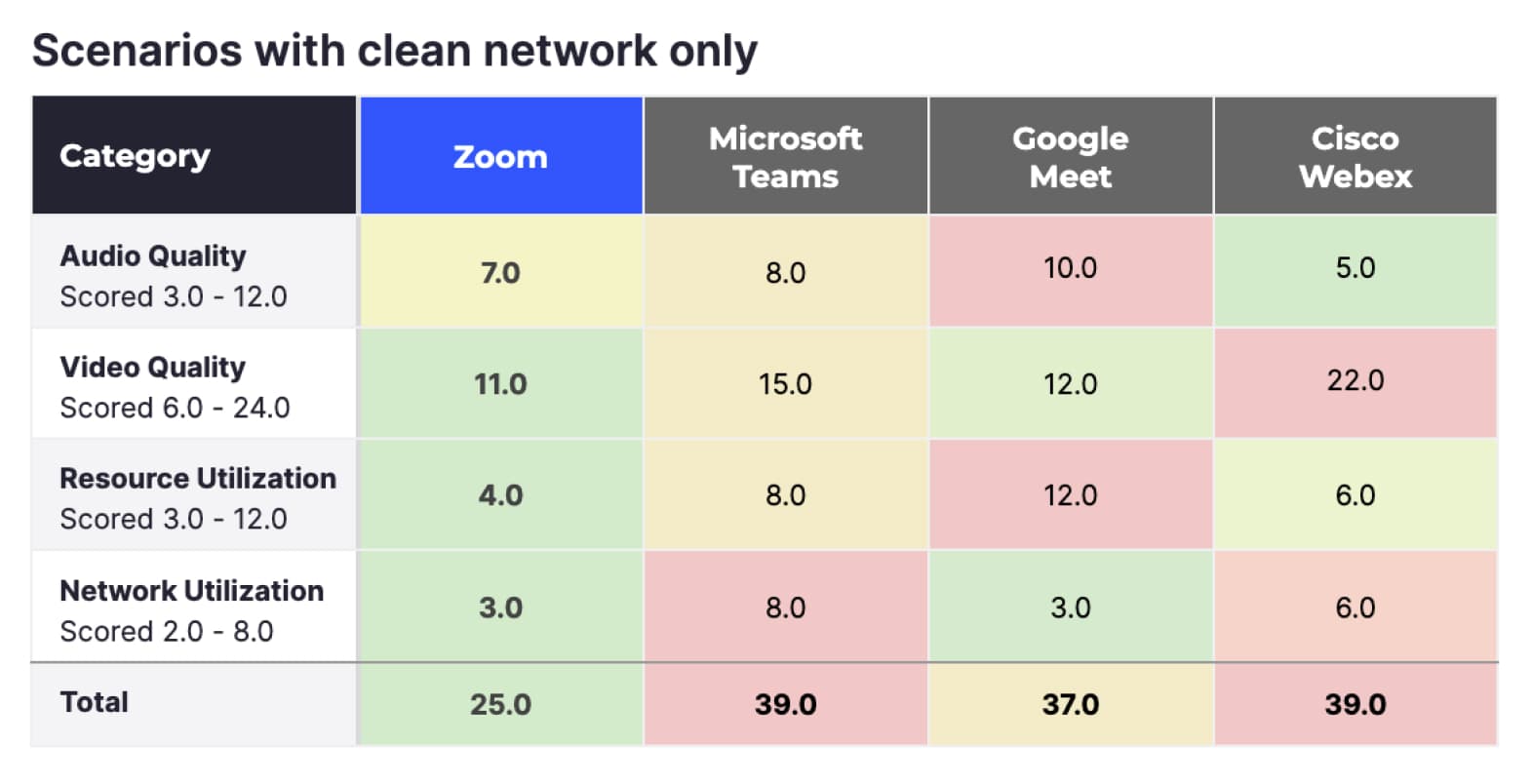

Escenarios con red óptima únicamente

La puntuación general anterior representa la totalidad de las pruebas de TDL, pero en realidad, la mayoría de los usuarios regulares no experimentarán muchas de las limitaciones de red simuladas por TDL. Los resultados a continuación filtran todas las pruebas que presentaron limitaciones de red, y se conservaron únicamente las pruebas de red sin restricciones.

Al analizar reuniones con red óptima, Zoom (25) obtiene una puntuación aún mejor, Google Meet (37) queda segundo, y Microsoft Teams (39) y Cisco Webex (39) son los últimos.

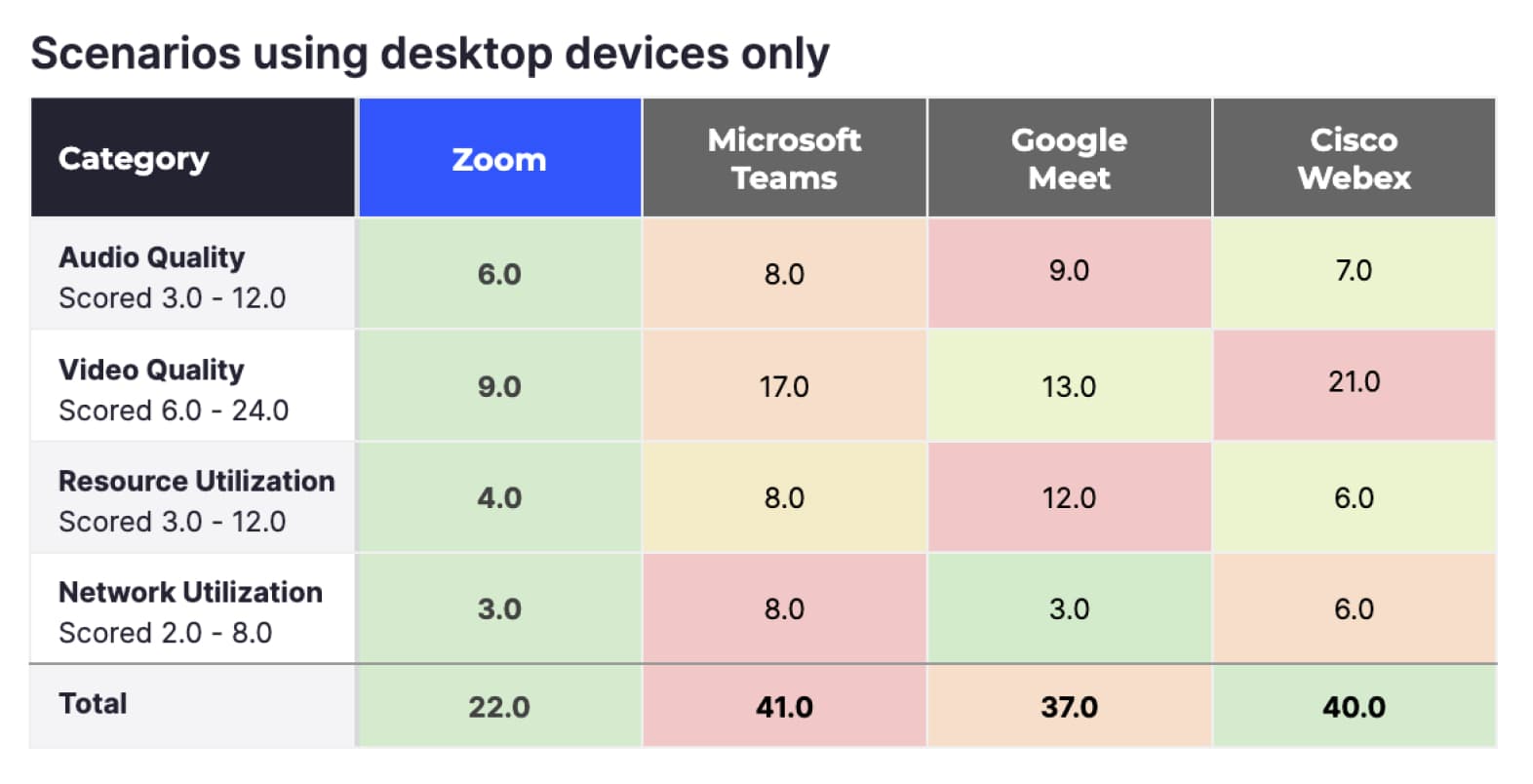

Escenarios que utilizan únicamente dispositivos de escritorio

Si bien muchas personas usan dispositivos móviles para conectarse a las reuniones, un promedio de aproximadamente el 66 % de todos los participantes de Zoom se conectan mediante dispositivos de escritorio (según las estadísticas internas de Zoom). Al filtrar los datos solo a escritorio y a reuniones sin problemas de red, la ventaja de Zoom aumenta aún más, y también lidera en las cuatro métricas.

Resumen

Zoom supera a los servicios alternativos de reuniones evaluados en todas las categorías medidas por TDL, bajo condiciones ideales y en los dispositivos más utilizados. Como las condiciones no siempre son ideales, es importante medir las circunstancias en las que los usuarios pueden experimentar problemas de red.

Los proveedores pueden ajustarse automáticamente a las condiciones cambiantes de la red para mantener una alta calidad de vídeo y audio. El protocolo de cada proveedor se adapta de forma diferente, lo que puede cambiar la resolución de vídeo, la calidad de compresión, los FPS y otros factores. La experiencia global del usuario durante una videollamada depende de lo bien que el proveedor pueda optimizar estos parámetros a medida que fluctúan las condiciones de la red.

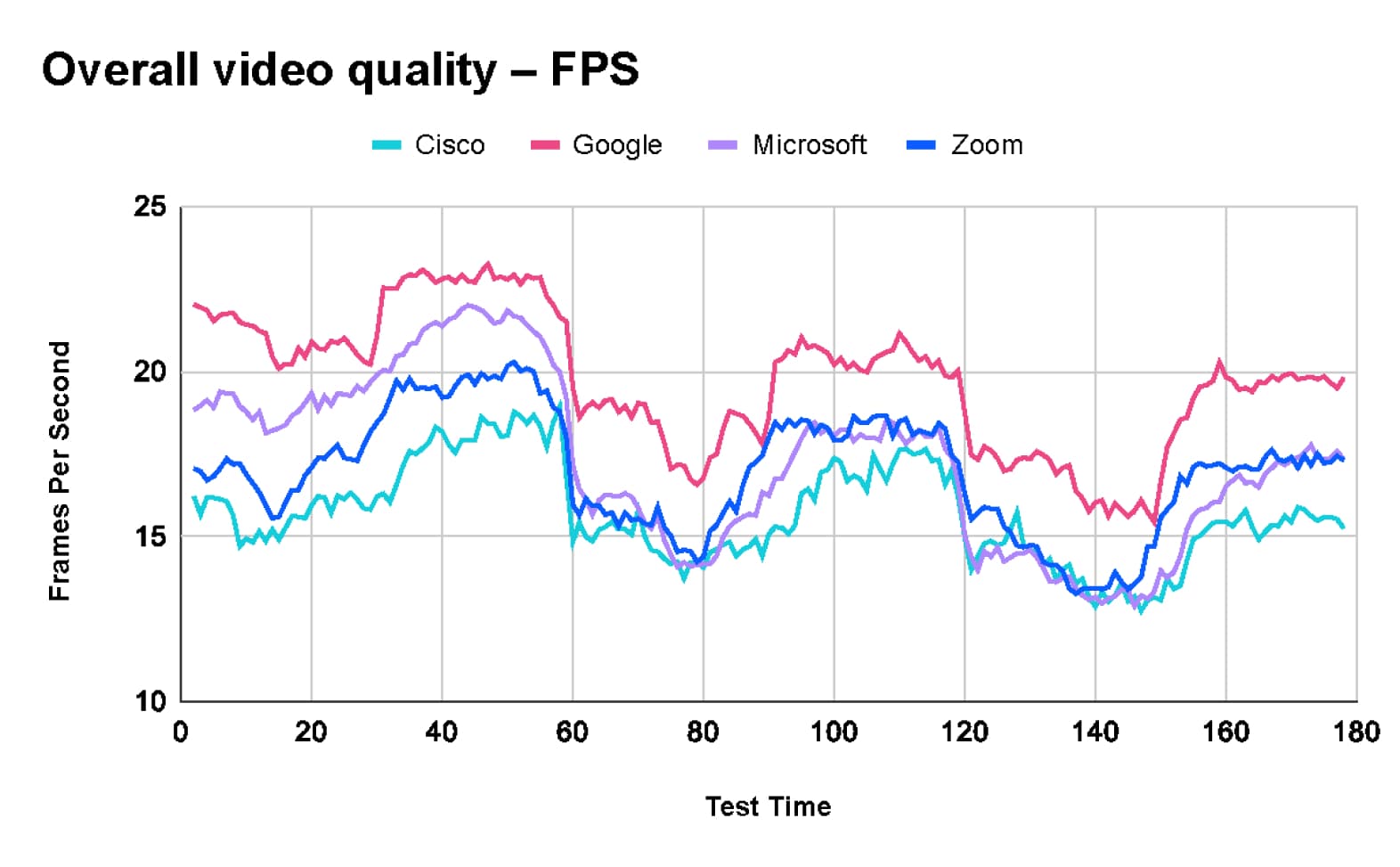

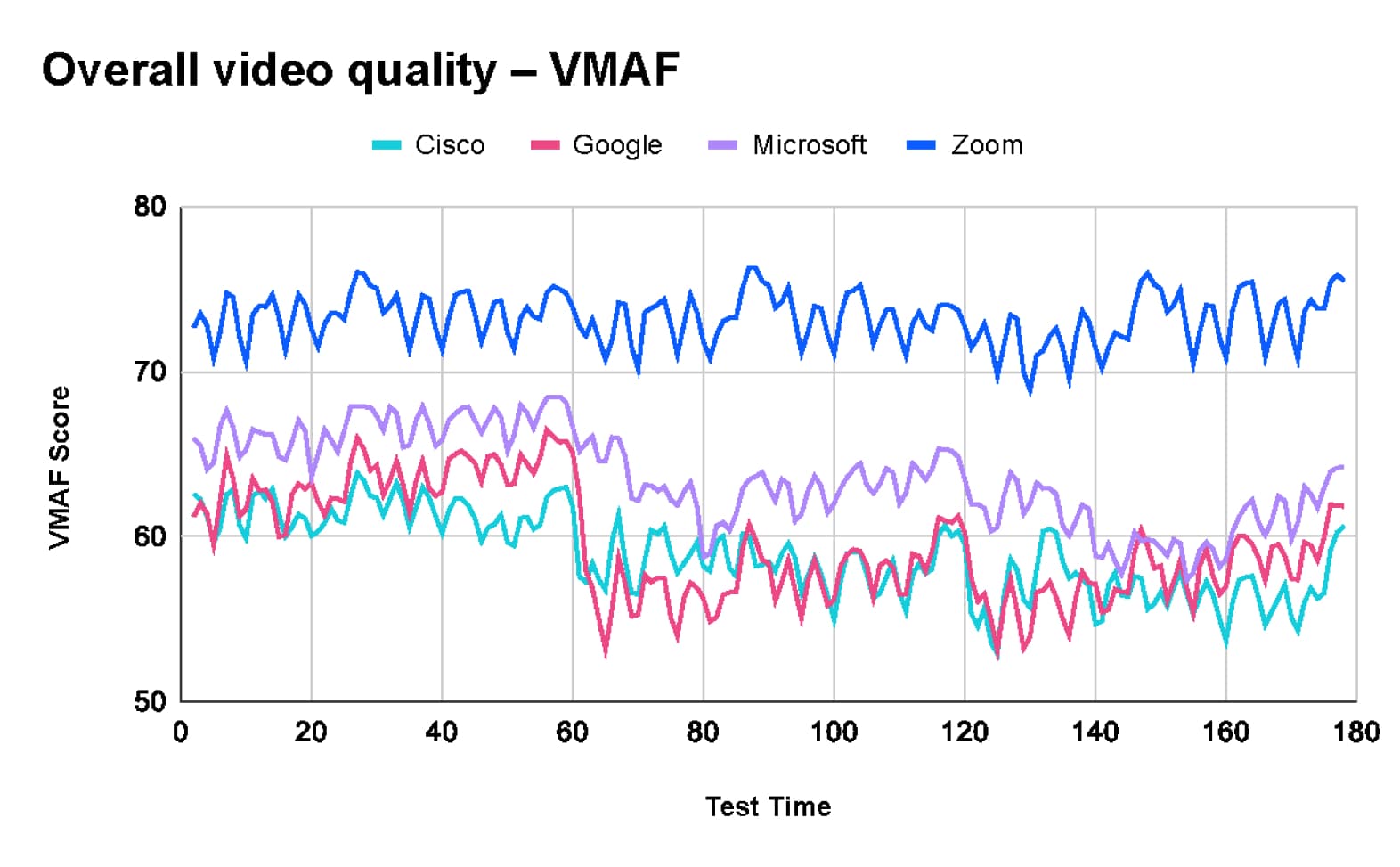

TestDevLab recopiló múltiples métricas para medir la experiencia general del usuario en una llamada. Las dos métricas más relevantes que se recopilaron fueron VMAF, que evalúa la calidad de imagen percibida, y los fotogramas por segundo (FPS), que reflejan la fluidez del vídeo.

Calidad general del vídeo en todas las pruebas

Tras analizar los resultados combinados de 660 pruebas, TDL concluyó que Google Meet ofrece la velocidad promedio más alta de 20 fotogramas por segundo (fps). En comparación, Microsoft Teams y Zoom tienen un promedio de 17 fps, mientras que Webex tiene un promedio de 16 fps.

Sin embargo, la mayor velocidad de fotogramas de Google Meet implica una desventaja en la calidad del vídeo. Según el gráfico de Video Multimethod Assessment Fusion (VMAF), Zoom lidera la calidad con una puntuación promedio de 73,2. Le sigue Microsoft Teams con una puntuación de 63,5, Google Meet con 59,5 y Webex con una puntuación promedio de 58,9.

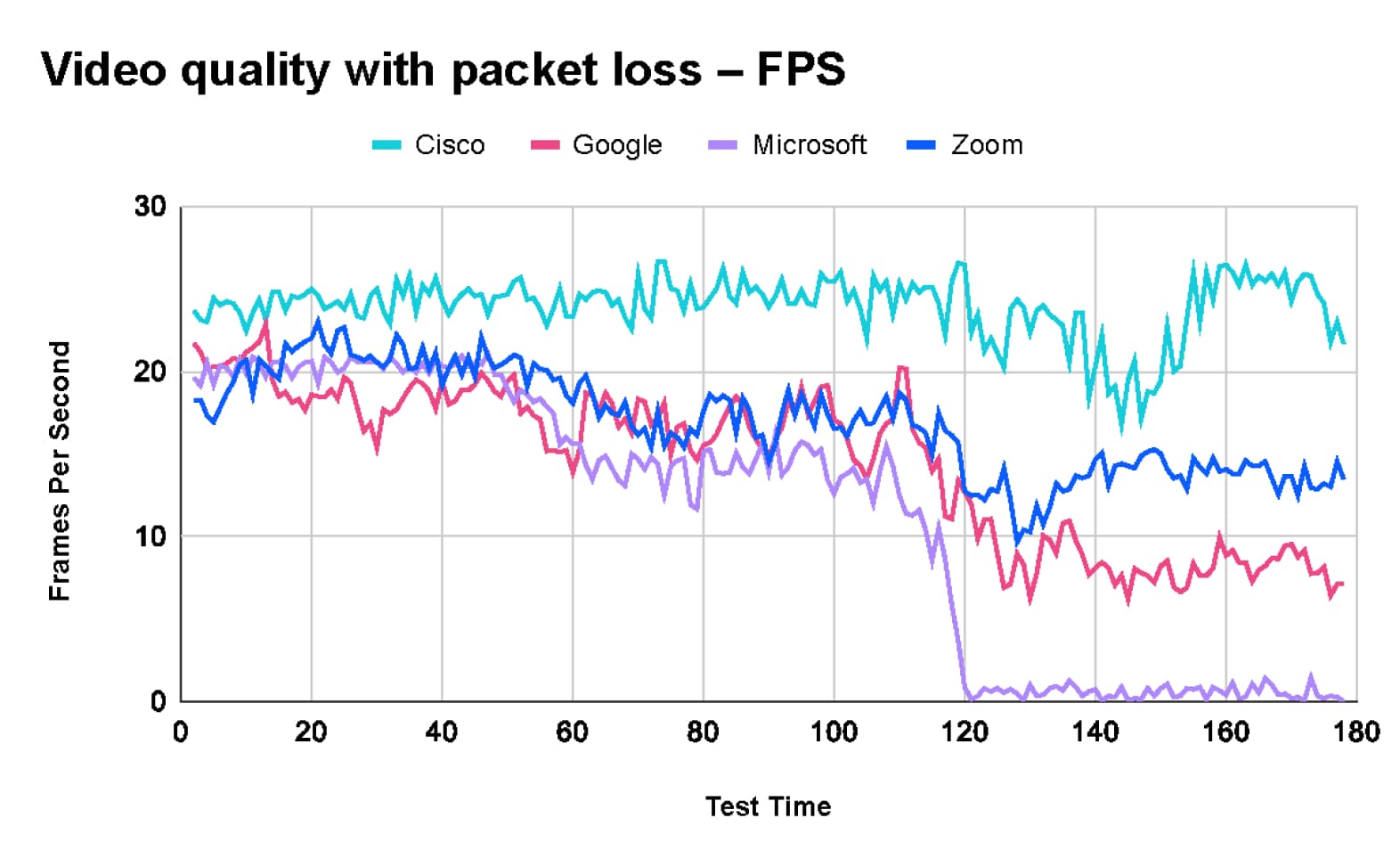

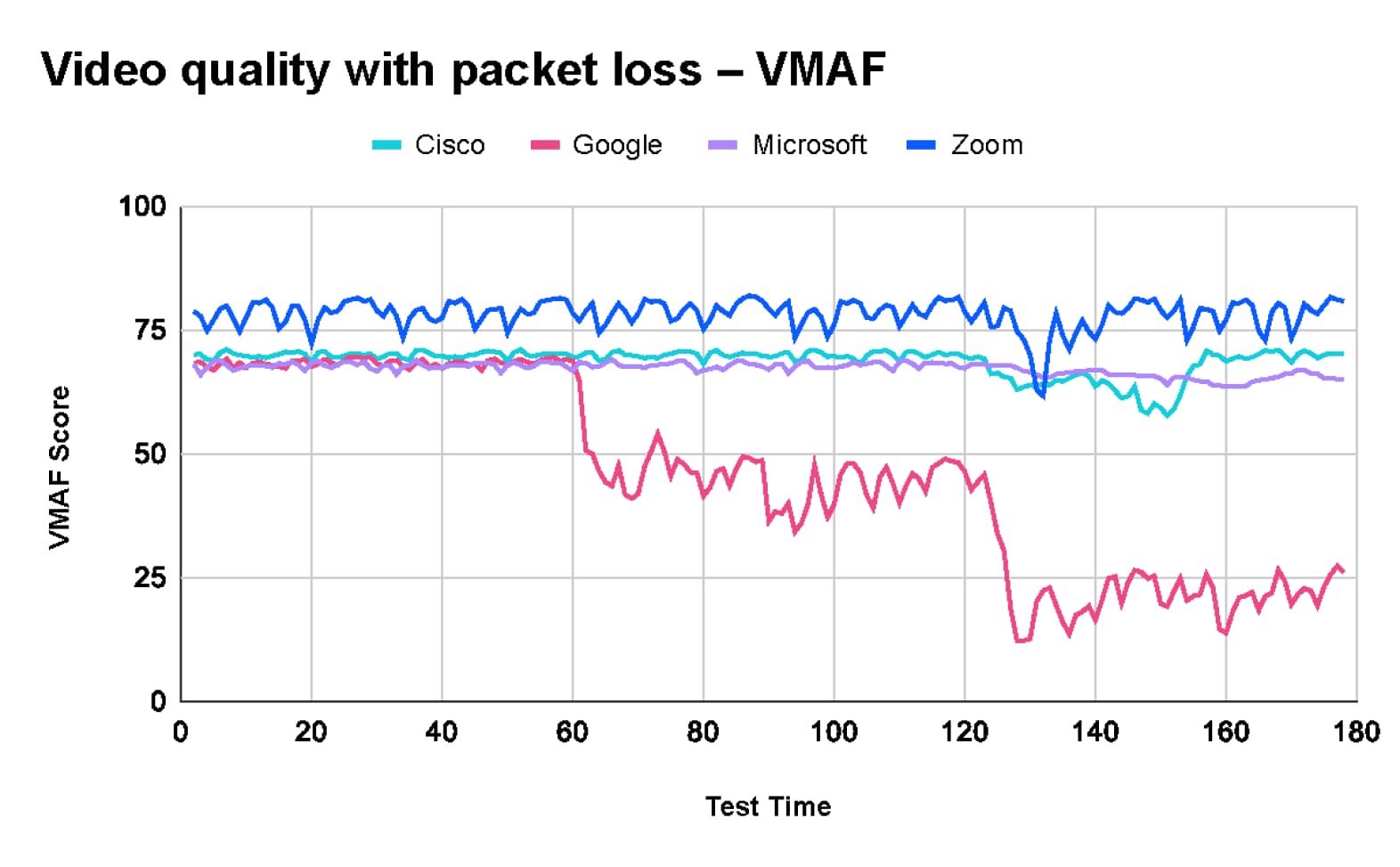

Calidad de vídeo con pérdida de paquetes

La prueba de pérdida de paquetes que realizó TestDevLab incluyó tres etapas.

- La llamada comenzó con una pérdida de paquetes del 10 %.

- Tras 60 segundos, la pérdida de paquetes aumentó al 20 %.

- Tras otros 60 segundos, la pérdida de paquetes aumentó aún más hasta un 40 %.

Como se muestra en los gráficos siguientes:

- Zoom mantiene la máxima calidad de vídeo con una puntuación de VMAF de alrededor de 80, pero la velocidad de fotogramas cae de aproximadamente 20 fps a 13 fps.

- Webex mantiene una calidad de vídeo y una velocidad de fotogramas relativamente estables durante toda la prueba.

- Google Meet experimenta una caída significativa en la puntuación de VMAF de 70 a 20 con una pérdida de paquetes del 40 %, y la velocidad de fotogramas baja de unos 15 fps a 8 fps al final de la prueba.

- Microsoft Teams mantiene la calidad de imagen con una puntuación de VMAF de 70. Sin embargo, la velocidad de fotogramas cae drásticamente de unos 20 fps al inicio de la prueba a 2 fps cuando se introduce una pérdida de paquetes del 40 %, lo que provoca que el vídeo se congele.

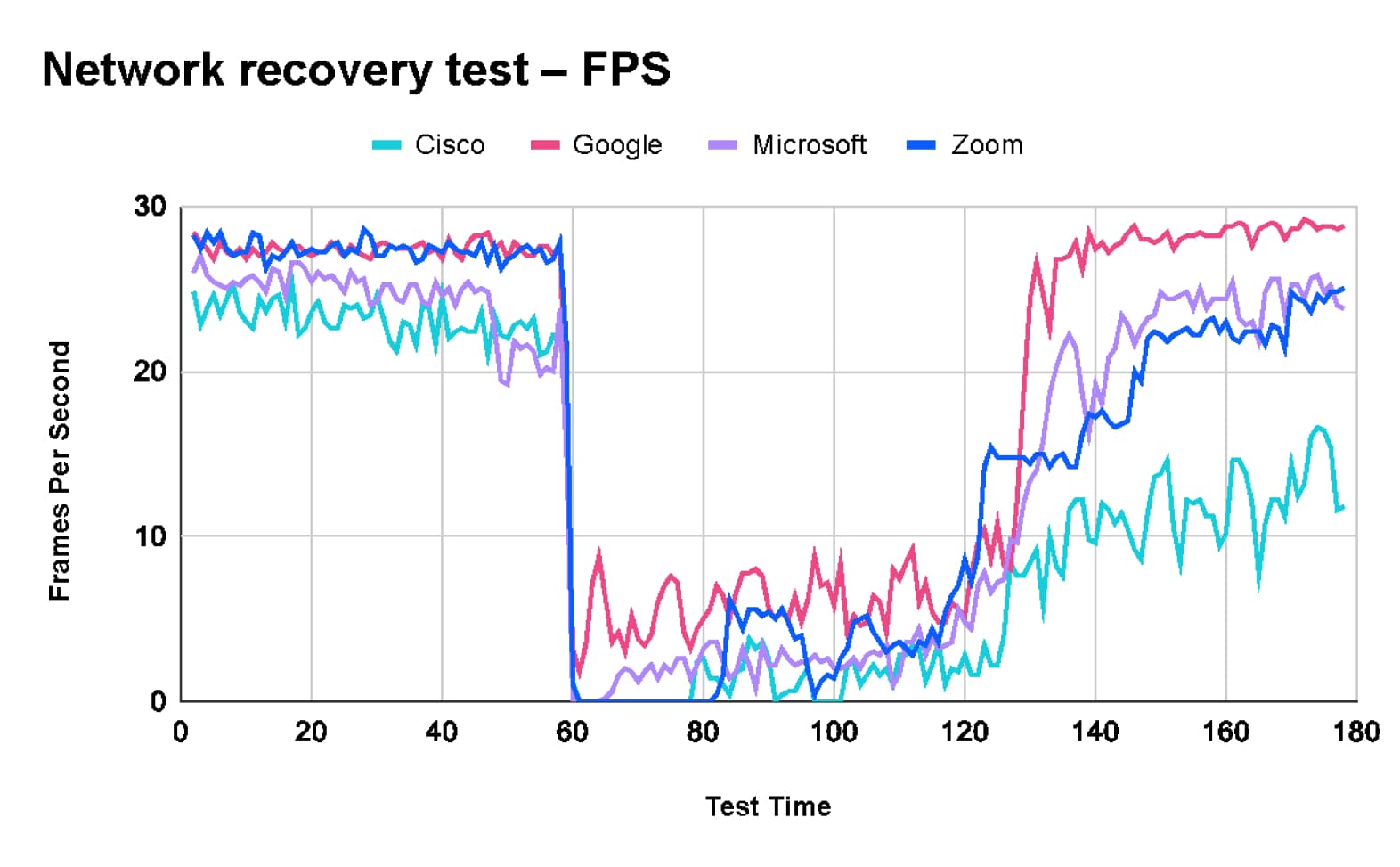

Prueba de recuperación de la red

En la prueba de recuperación de la red, TDL comenzó la prueba con una red óptima.

- A los 60 segundos, se introdujeron diversos problemas de red, lo que incluye un límite de 1 Mbps, una pérdida de paquetes del 10 %, un retraso de 100 ms y un jitter de 30 ms.

- Después de 60 segundos de “red defectuosa”, se levantaron las limitaciones y la red volvió a su estado original.

Esta prueba se diseñó para comprobar el comportamiento de las plataformas probadas cuando se produce un problema temporal en la red y la capacidad de cada plataforma para recuperarse cuando el problema deja de existir.

Los resultados de la prueba muestran que, aunque Zoom mantiene una alta calidad de vídeo, tarda unos 10 segundos en reajustar los parámetros de su códec a las nuevas condiciones de la red, lo que se traduce en una velocidad de fotogramas muy baja durante varios segundos. En cuanto al tiempo de recuperación, Zoom está en un punto intermedio, entre Webex con muy poco tiempo de recuperación y Teams y Google con recuperación rápida.

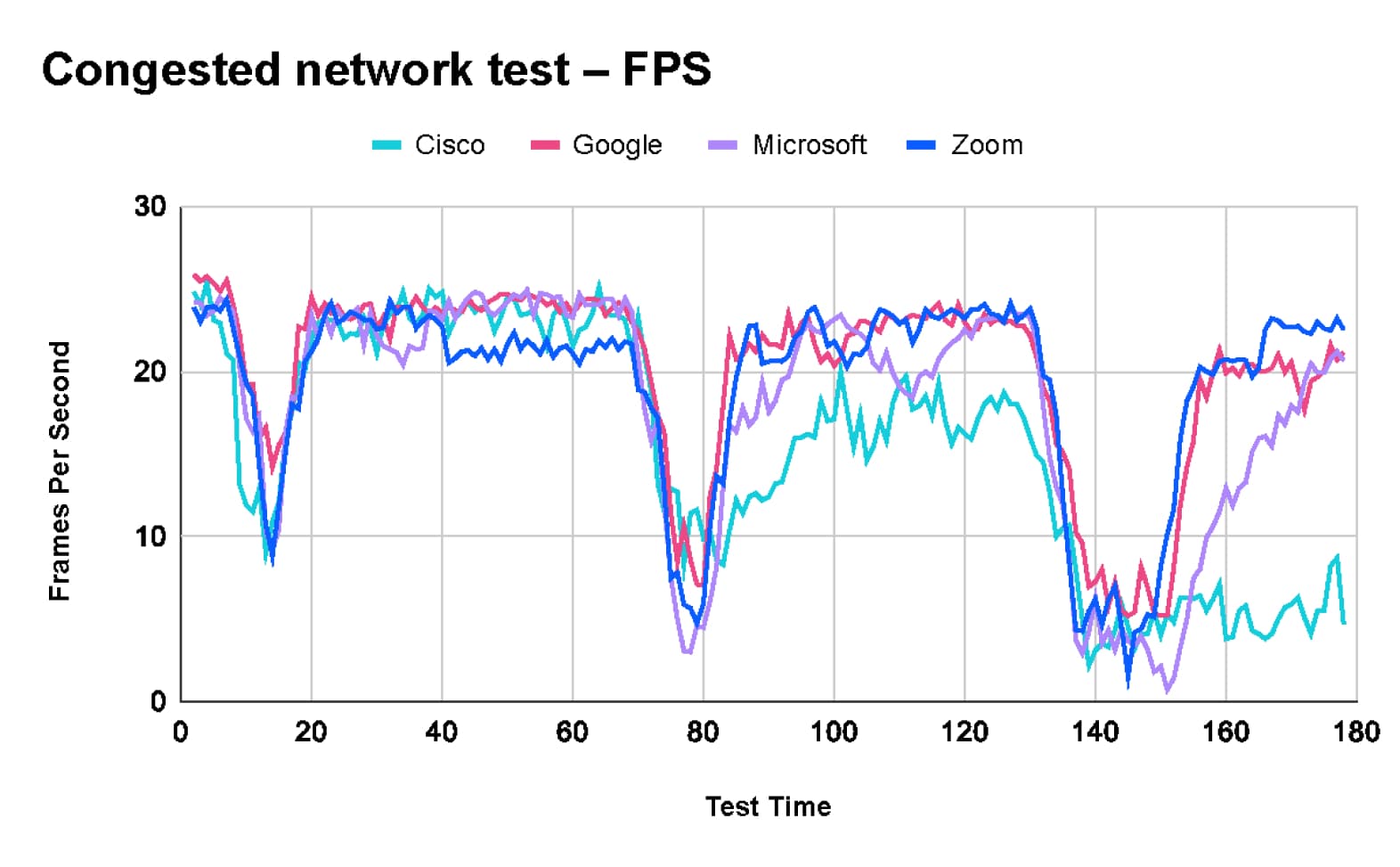

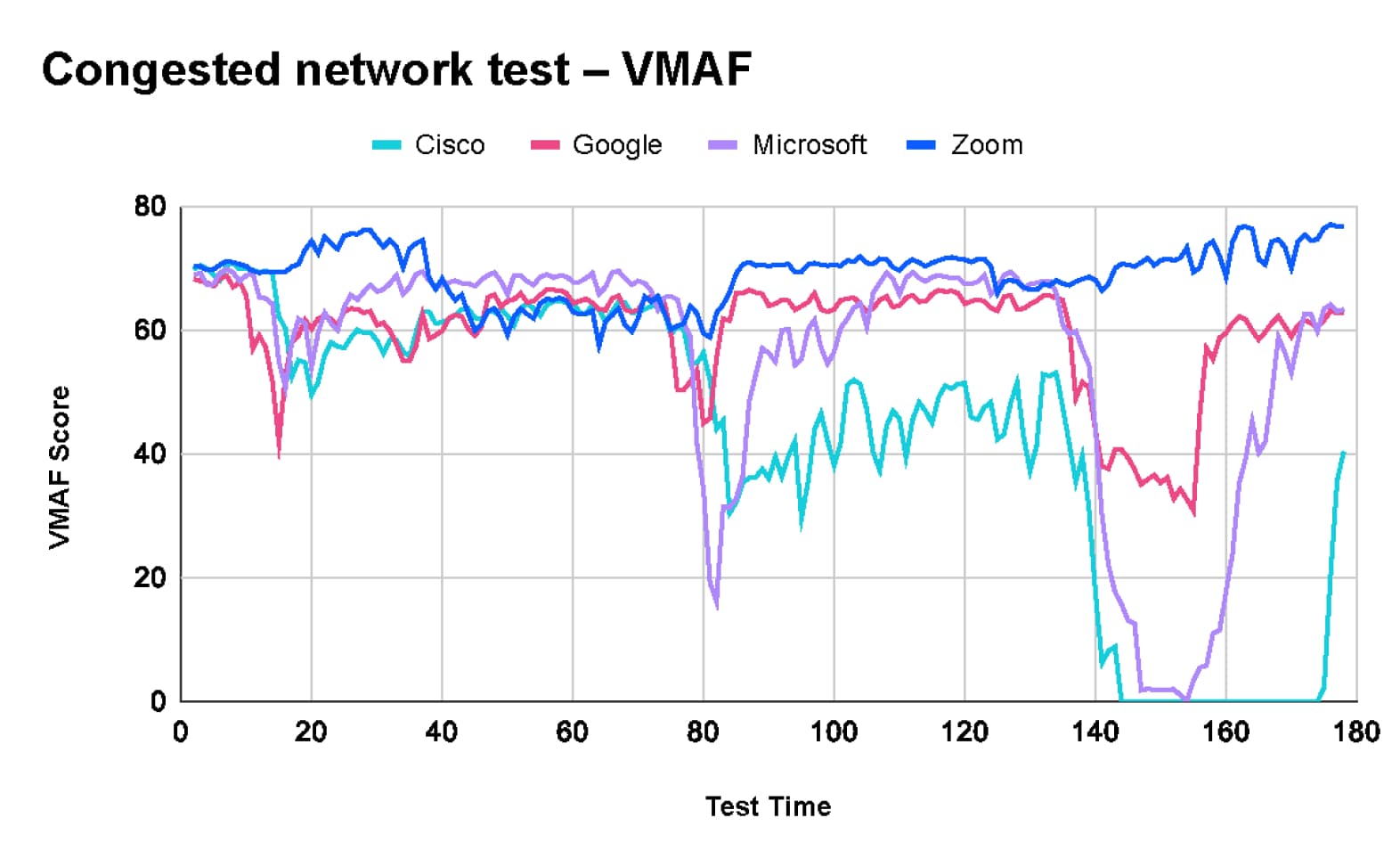

Prueba de red congestionada

El objetivo de la prueba de red congestionada era evaluar el comportamiento de las plataformas bajo diferentes duraciones de congestión y su capacidad para mantener el rendimiento en redes con saturación intermitente de tráfico.

- El guion de prueba alternaba entre periodos de inactividad y una saturación de tráfico de 10 Mbps (en una línea de 10 Mbps), con periodos de congestión cada vez mayores y diferentes longitudes de pausa en el medio.

Los resultados de la prueba muestran que Zoom mantiene la calidad de imagen durante toda la prueba mientras sacrifica la velocidad de fotogramas y el retraso de vídeo para adaptarse a las condiciones cambiantes de la red. Cabe destacar que Webex interrumpió por completo el vídeo al finalizar la prueba.

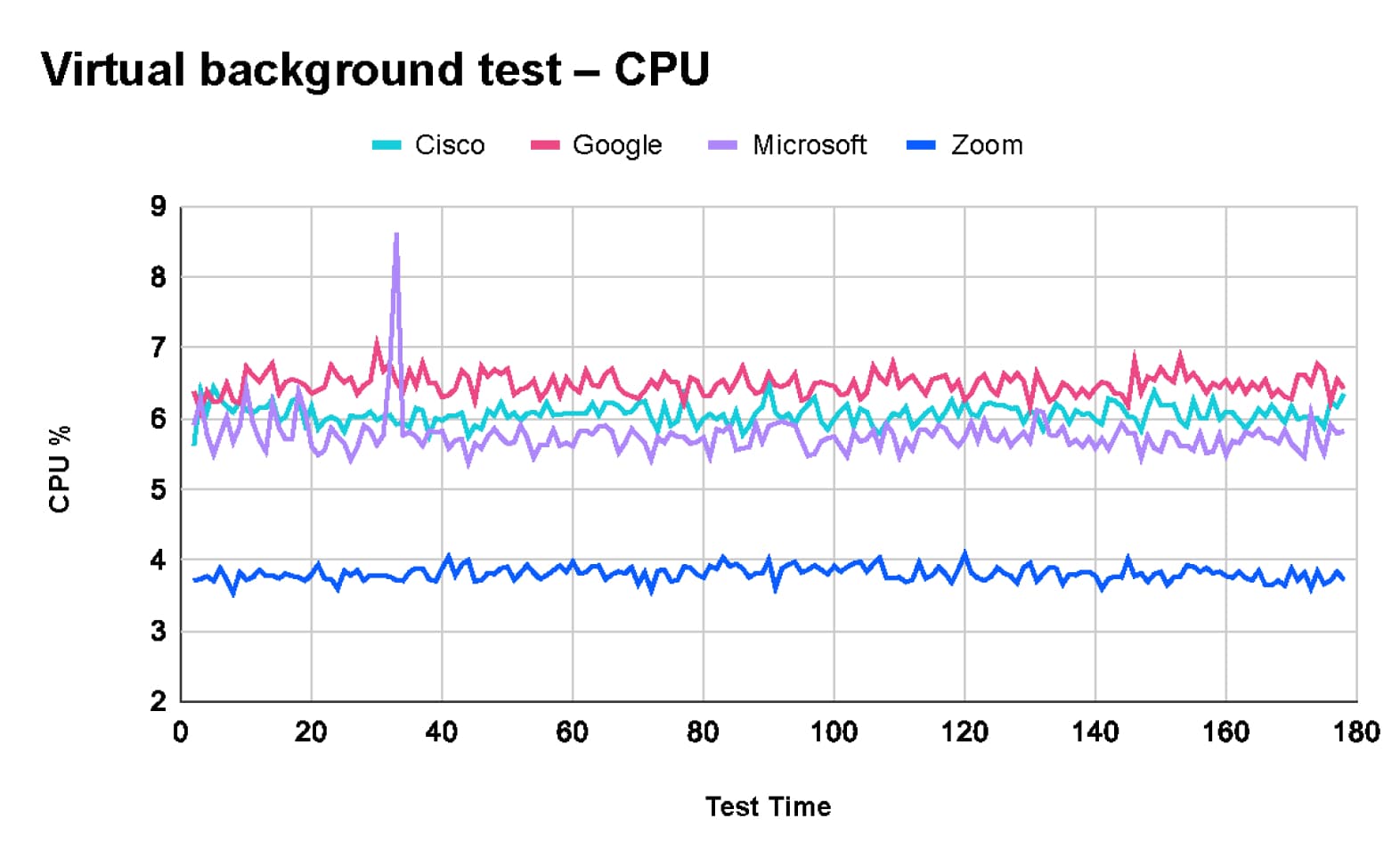

Prueba de calidad de fondo virtual

En nuestros escenarios de prueba, le pedimos a TDL que evaluara la experiencia del usuario con la función de fondo virtual. Esta función sustituye el fondo real del usuario por una imagen o un vídeo, lo que requiere un procesamiento significativo para generar una imagen compuesta de alta calidad.

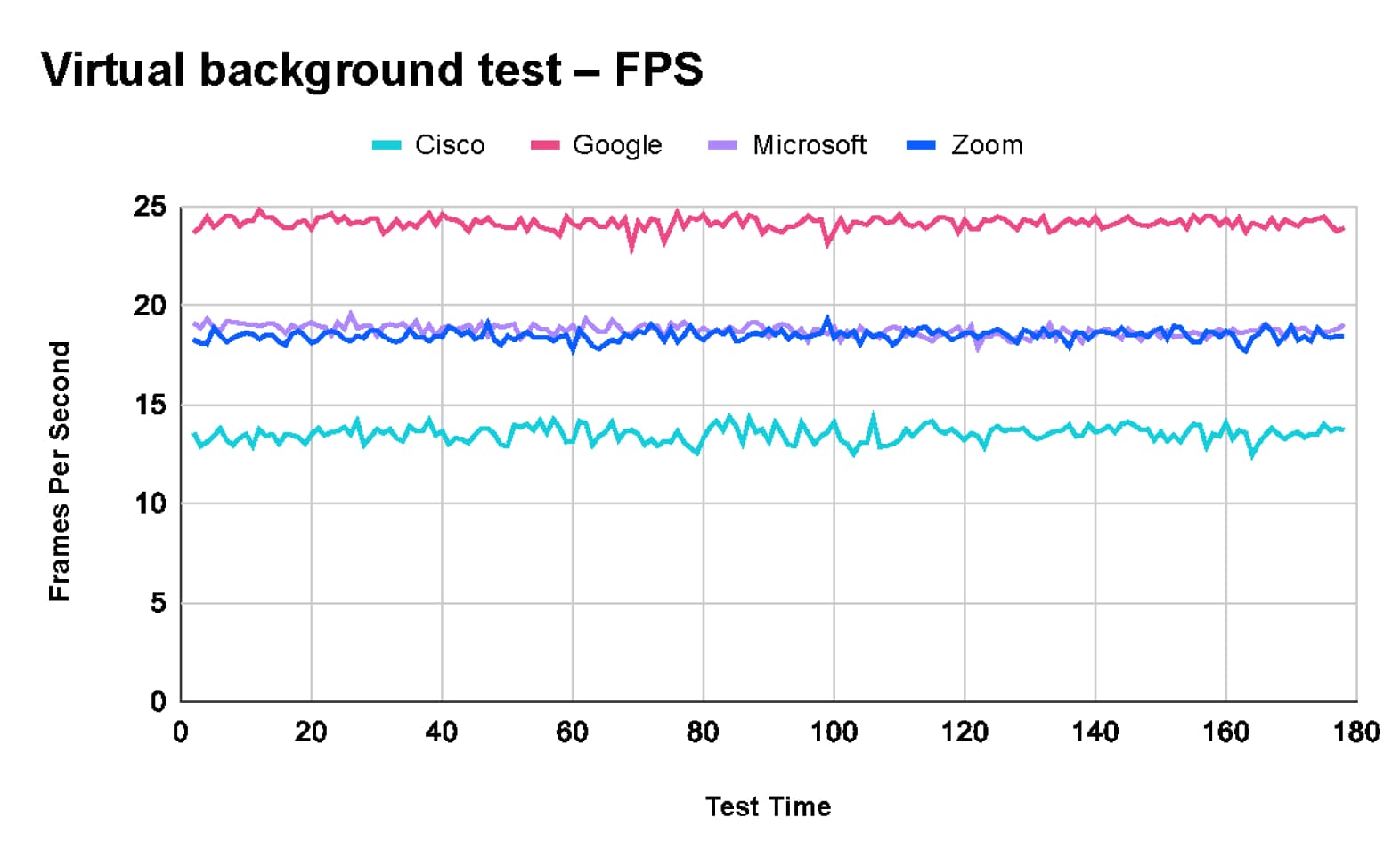

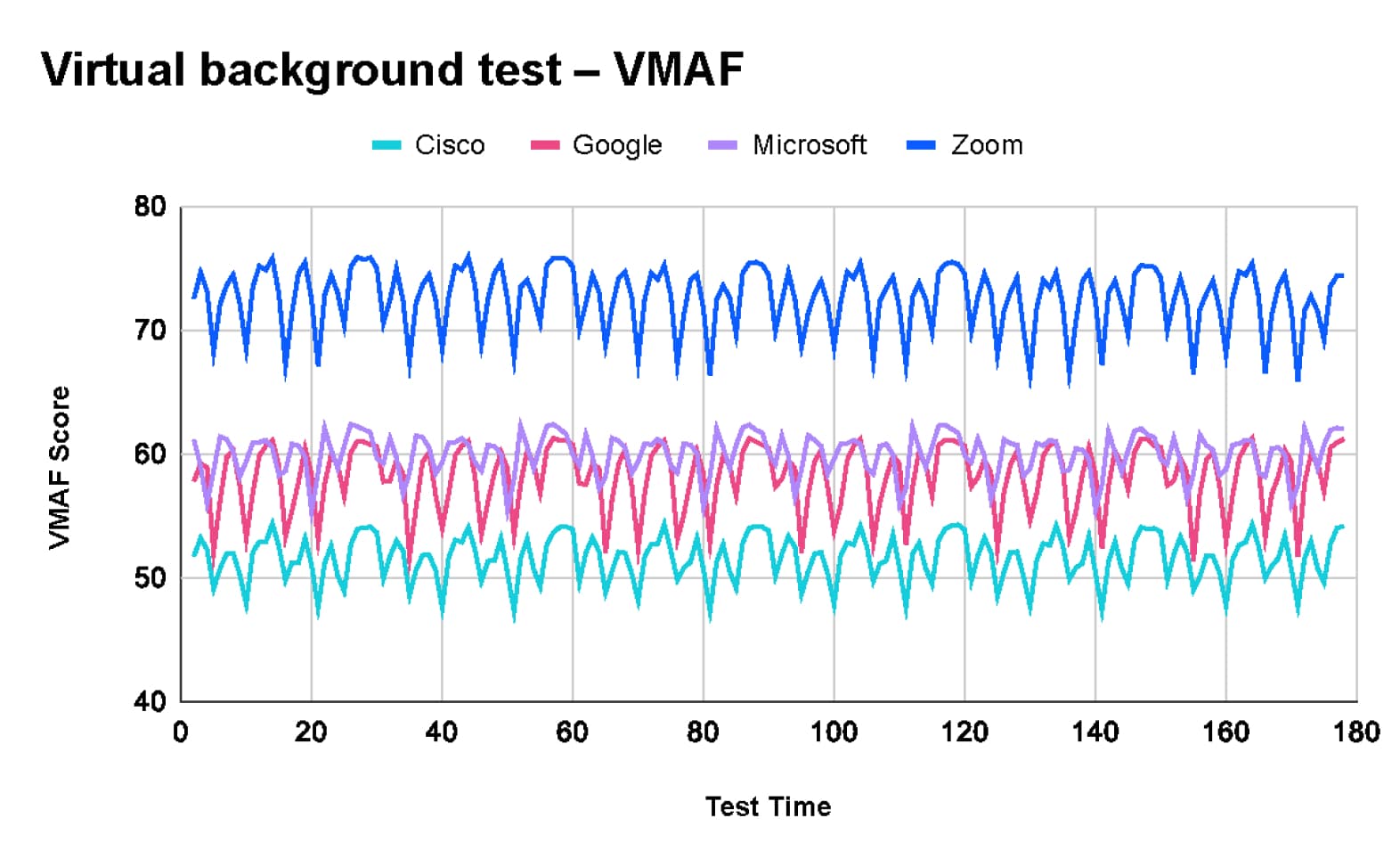

Según los resultados de TDL, Zoom ofreció la mejor calidad de imagen. Algunos clientes de reuniones priorizan la calidad del vídeo, y algunos priorizan la velocidad de fotogramas. Las puntuaciones de VMAF demostraron lo siguiente:

- Zoom (73) tiene una velocidad de fotogramas estable de 18 fps

- Microsoft Teams (60) tiene una velocidad de fotogramas estable de 18 fps

- Google Meet (58) tiene una velocidad de fotogramas alta de 24 fps

- Cisco Webex (52) tiene una velocidad de fotogramas baja de 13 fps

Estos hallazgos son consistentes con las pruebas de calidad de fondo virtual internas de Zoom realizadas el año pasado, que se muestran en este vídeo.

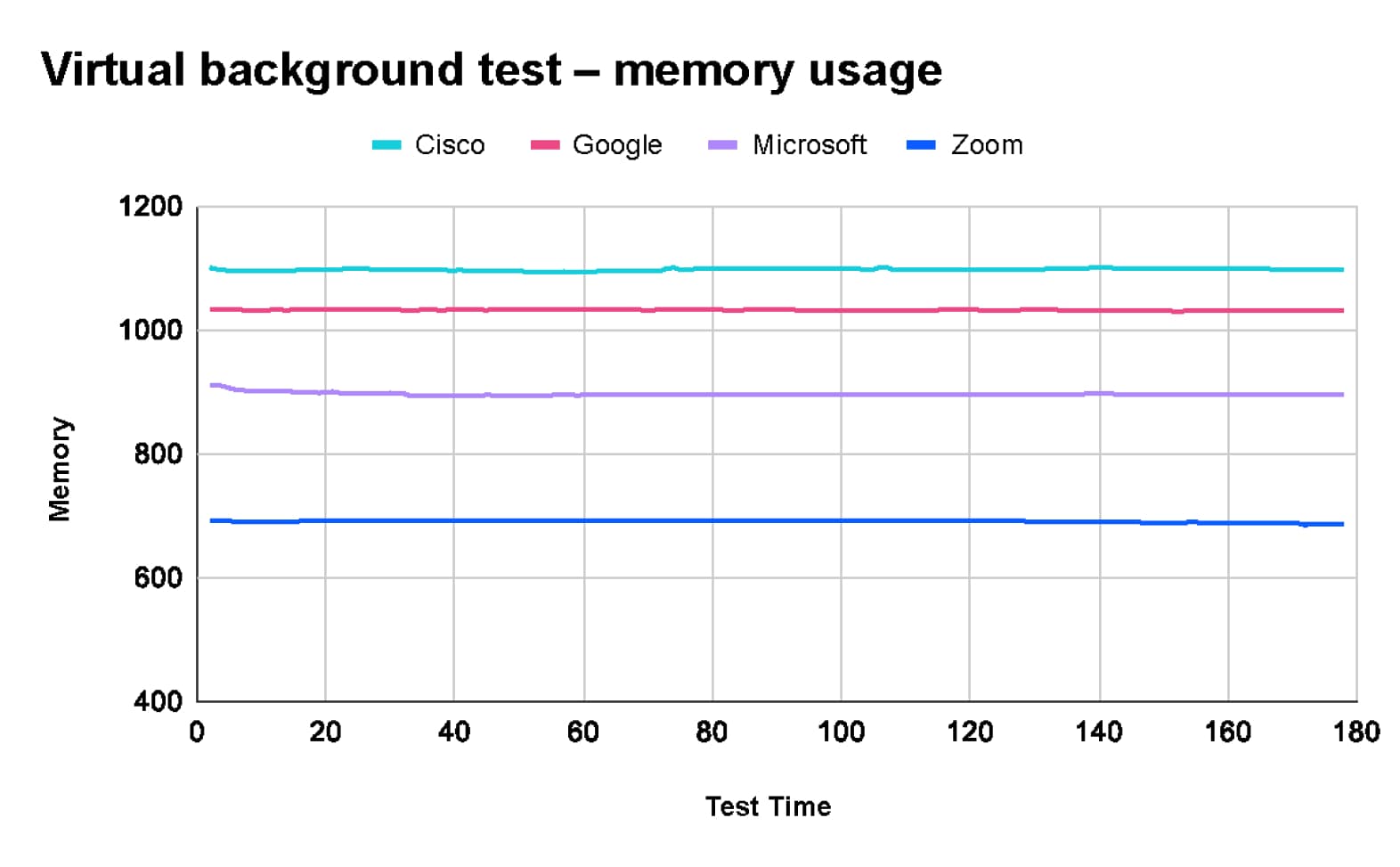

Además, las pruebas de TDL revelaron que Zoom utiliza menos recursos de CPU y memoria cuando utiliza la función de fondo virtual.

Las extensas pruebas de TDL ponen de manifiesto diferencias significativas en el rendimiento entre Zoom, Microsoft Teams, Google Meet y Cisco Webex bajo diversas condiciones de red y escenarios de reunión.

- Zoom ofrece de manera constante la mejor experiencia general, destacó en calidad de vídeo y utilización de recursos, y mantuvo un buen rendimiento con la red sobrecargada.

- Google Meet se destaca por su eficiencia de red, mientras que Cisco Webex ofrece una buena calidad de audio.

- El rendimiento líder de Zoom, especialmente en vídeo de alta calidad y utilización eficiente de recursos, lo posiciona como la mejor opción para reuniones virtuales sólidas y fiables.