Gặp Zoom AI Companion, trợ lý AI mới của bạn!

Tăng năng suất và thúc đẩy cộng tác nhóm bằng Zoom AI Companion, sản phẩm miễn phí đi kèm các gói Zoom trả phí đủ điều kiện.

CTO của Zoom, Xuedong Huang, thảo luận về cách thức các mô hình ngôn ngữ nhỏ (SLM) thúc đẩy tầm nhìn của chúng tôi để các tác tử AI làm việc cùng nhau theo cách tiếp cận liên kết nhằm cải thiện công việc hàng ngày của bạn.

Cập nhật vào February 25, 2025

Đăng vào February 19, 2025

Xuedong Huang là Giám đốc Công nghệ (CTO). Trước khi đến với Zoom, ông từng làm việc tại Microsoft với vai trò Lãnh đạo Kỹ thuật và CTO của Azure AI. Ông có sự nghiệp nổi bật trong lĩnh vực AI: ông thành lập nhóm công nghệ giọng nói của Microsoft vào năm 1993, dẫn dắt nhóm AI của Microsoft đạt được một số cột mốc đầu tiên trong ngành tương đồng với khả năng của con người về nhận diện giọng nói, dịch máy, hiểu ngôn ngữ tự nhiên và thị giác máy tính, là thành viên của Hội Kỹ sư Điện và Điện tử (IEEE) và Người đạt giải thưởng của Hiệp hội Máy tính (ACM), đồng thời là thành viên được bầu của Viện hàn lâm Kỹ thuật Quốc gia và Viện hàn lâm Khoa học và Nghệ thuật Hoa Kỳ.

Xuedong nhận bằng Tiến sĩ Kỹ thuật điện (EE) tại Đại học Edinburgh năm 1989 (được tài trợ bởi ORS của Anh và Học bổng của Đại học Edinburgh), bằng Thạc sĩ Khoa học máy tính của Đại học Thanh Hoa năm 1984 và bằng Cử nhân Khoa học máy tính từ Đại học Hồ Nam năm 1982.

Tại Zoom, chúng tôi luôn tập trung vào đổi mới, điều này thúc đẩy sự khám phá liên tục của chúng tôi về chuyển đổi AI-first thông qua Zoom AI Companion. Trong năm qua, tôi đã chia sẻ cách tiếp cận liên kết của chúng tôi mang lại kết quả chất lượng cao và cách chúng tôi tập trung vào chất lượng nhận dạng giọng nói tạo ra nền tảng tốt hơn cho các tính năng AI khác của chúng tôi. Khi trí tuệ nhân tạo tiếp tục được cải thiện, chúng tôi đang đẩy nhanh việc áp dụng AI tác tử.

Cho đến nay, trí tuệ nhân tạo đã dựa vào các mô hình ngôn ngữ lớn (LLM) để đáp ứng yêu cầu của người dùng và đưa ra phản hồi tạo sinh. Tuy nhiên, có nhiều cơ hội hơn nữa khi chúng ta xem xét cách thức SLM có thể kích hoạt tác tử AI tùy chỉnh. Chúng tôi đang phát triển AI Companion để hỗ trợ AI tác tử quản lý một loạt các hành động gồm nhiều bước thay mặt bạn.

Khi chúng ta coi AI như tác tử thay vì các kỹ năng hoặc phản hồi độc lập, điều này có nghĩa là không chỉ nhập lệnh để đưa ra kết quả đơn giản và thay vào đó nên nó như là một phần mở rộng và mục tiêu của chúng ta. Để thực hiện điều này, các tác tử AI của chúng tôi có các đặc điểm sau:

Để giúp hiện thực hóa các tác tử AI này, chúng tôi rất vui mừng thông báo một cột mốc quan trọng trong hành trình này: Mô hình ngôn ngữ nhỏ (SLM) mới phát triển của chúng tôi đã đạt được hiệu suất hàng đầu trong hạng mục 2 tỷ tham số trên bảng xếp hạng công khai. Thông qua việc tùy chỉnh với AI Studio sắp ra mắt của Zoom, chúng tôi đang thiết kế các SLM của Zoom để đạt được chất lượng gần với LLM hàng đầu trong ngành trong các khối lượng công việc chuyên biệt. Điều này sẽ mở đường cho AI Companion thực hiện các nhiệm vụ AI tác tử phức tạp với nhiều tác tử AI, cho phép chúng hợp tác với nhau một cách hiệu quả về chi phí chưa từng có.

Trong cách tiếp cận AI liên kết của Zoom, thay vì phụ thuộc vào một mô hình lớn duy nhất và toàn diện, chúng tôi ủng hộ việc điều phối nhiều mô hình được tùy chỉnh. Các SLM của Zoom được thiết kế để cải thiện phương pháp này bằng cách tối ưu hóa cho các nhiệm vụ cụ thể. Bằng cách phân phối khối lượng công việc trên các SLM tùy chỉnh với các tác tử tương ứng—đồng thời tận dụng các LLM hàng đầu—chúng tôi hướng đến đạt được một số lợi ích quan trọng:

Hãy cùng thảo luận về ý nghĩa của bước đột phá này và cách nó so sánh chính xác với các mô hình hàng đầu.

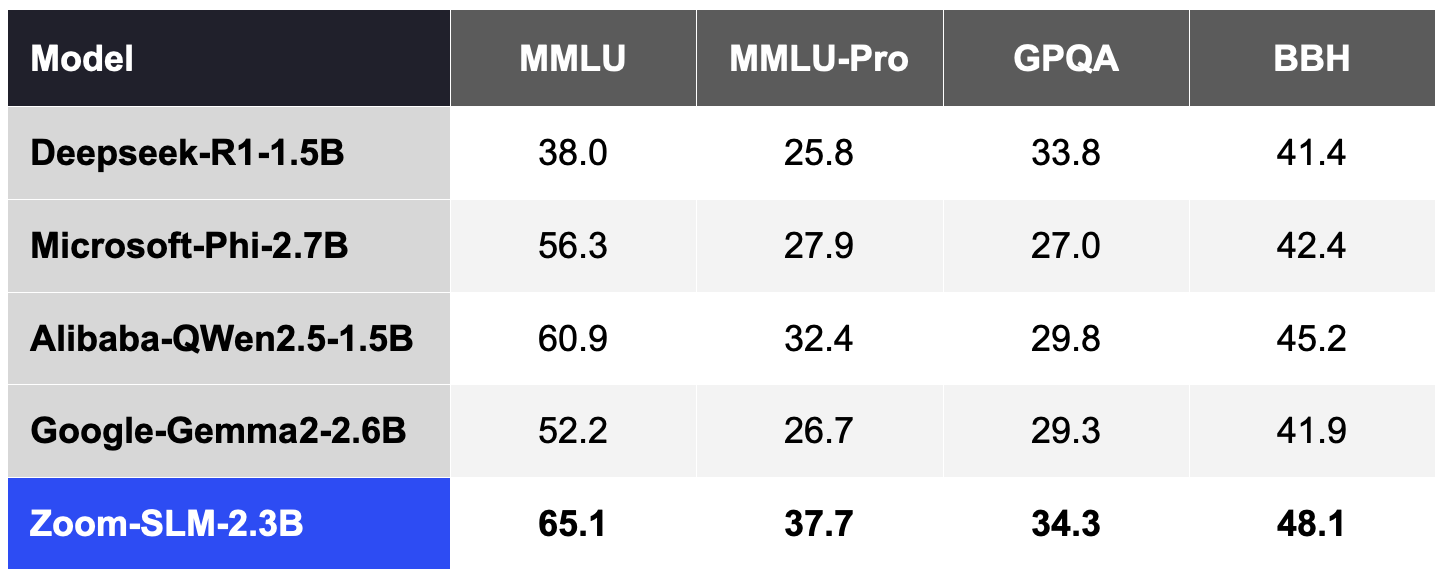

Để tạo SLM của Zoom, chúng tôi đã sử dụng 6 nghìn tỷ mã thông báo từ dữ liệu đa ngôn ngữ và 256 GPU Nvidia H100. Từ đầu đến cuối, toàn bộ chu kỳ đào tạo kéo dài khoảng 30 ngày. Các bảng sau đây mô tả khả năng SLM của Zoom so với các mô hình khác trên một số tiêu chuẩn công khai dựa trên thử nghiệm nội bộ của chúng tôi:

Theo thông lệ chung của cộng đồng, chúng tôi đã đánh giá độ chính xác của các tiêu chuẩn đó bằng công cụ Lighteval, công cụ này cung cấp 5 ví dụ trên MMLU và MMLU-Pro, 2 ví dụ trên GPQA, và 3 ví dụ trên BBH.

Bảng 1. Zoom SLM so với các SLM khác trong danh mục 2B (điểm cao hơn là tốt hơn).

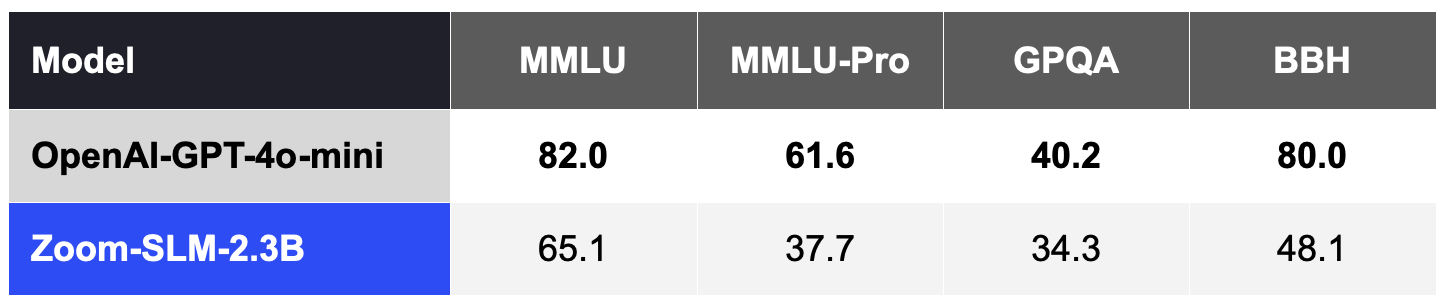

Nhìn chung, các mô hình ngôn ngữ nhỏ (SLM) vẫn kém cạnh tranh hơn trong các chỉ số chất lượng này so với các mô hình ngôn ngữ lớn hàng đầu (LLM) như GPT-4o-mini của OpenAI, nếu không được tùy chỉnh cho một lĩnh vực hoặc nhiệm vụ cụ thể, như được thể hiện trong Bảng 2.

Bảng 2. Zoom SLM, không có tùy chỉnh, kém cạnh tranh hơn so với các LLM vượt qua danh mục 2B, chẳng hạn như OpenAI GPT 4o-mini.

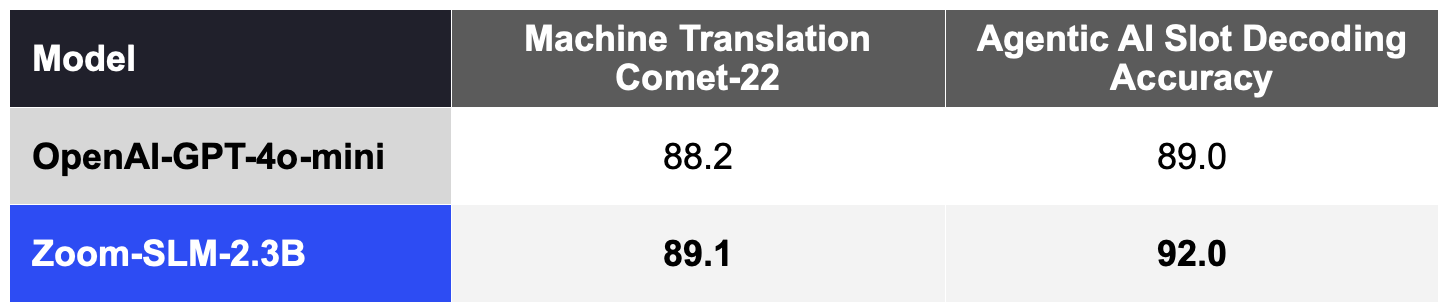

Tuy nhiên, kết quả thú vị nhất là các SLM này có thể cung cấp khả năng vượt trội khi được tùy chỉnh cho một nhiệm vụ chuyên biệt. Thông qua việc tùy chỉnh với AI Studio của Zoom, chúng tôi kỳ vọng sẽ thu hẹp hiệu quả khoảng cách chất lượng so với các mô hình ngôn ngữ lớn (LLM) đắt đỏ hơn. Các SLM tùy chỉnh có thể hoạt động như các tác tử chuyên biệt để thực hiện các nhiệm vụ chính trong sự phối hợp với các LLM, ưu tiên nâng cao độ chính xác, tốc độ và hiệu quả chi phí cho từng tác tử AI.

Các mô hình ngôn ngữ tự động (SLM) được tùy chỉnh có thể xuất sắc trong các nhiệm vụ như dịch máy. Bằng cách điều chỉnh SLM với 11,5 tỷ mã thông báo (bao gồm dữ liệu tổng hợp) được thiết kế cho dịch máy, chúng tôi đã cải thiện đáng kể các chỉ số chất lượng COMET-22 được sử dụng rộng rãi trên 14 cặp ngôn ngữ, bao gồm các ngôn ngữ chính như tiếng Trung, tiếng Anh, tiếng Pháp, tiếng Nhật, tiếng Bồ Đào Nha và tiếng Tây Ban Nha như được thể hiện trong Bảng 3.

Các mô hình SLM của chúng tôi cũng có thể được tùy chỉnh để hỗ trợ tiêu chuẩn đánh giá AI tác tử của AI Companion cho việc giải mã slot, đo lường mức độ mà mô hình diễn giải các lệnh của người dùng trong việc thực thi hành động. Với 2 tỷ mã thông báo tổng hợp cho dữ liệu trong lĩnh vực AI tác tử, mô hình SLM tùy chỉnh cũng vượt trội hơn GPT-4o-mini như được thể hiện trong Bảng 3.

Sự kết hợp giữa hiệu quả và khả năng thích ứng này được thiết kế để cho phép Zoom mang đến dịch thuật máy được cải tiến nhiều cho khách hàng trên toàn thế giới cũng như hỗ trợ Zoom AI Studio tùy chỉnh cho các khối lượng công việc AI tác tử cụ thể.

Bảng 3. So sánh giữa Zoom SLM tùy chỉnh và OpenAI GPT-4o-mini trong các khối lượng công việc chuyên biệt, điểm số cao hơn là tốt hơn.

Những SLM tùy chỉnh này sẽ là nền tảng cho các tác tử AI của chúng tôi, hoạt động hiệu quả hơn và đạt kết quả tương đương với các LLM đắt tiền hơn mà mọi người hiện đang sử dụng. Sử dụng trí tuệ nhân tạo liên kết của chúng tôi, các tác tử và kỹ năng AI này sẽ giúp thúc đẩy hiệu quả, chi phí và độ chính xác không gì sánh kịp.

Chúng tôi tự hào về tiến bộ của mình—và đây chỉ mới là sự khởi đầu. Tầm nhìn của chúng tôi là trang bị cho mọi tổ chức các tác tử AI cung cấp các giải pháp hiệu quả về chi phí và hiệu suất cao. Với các khả năng bổ sung của các tác tử AI và SLM, AI Companion sẵn sàng giúp bạn tạo ra một môi trường làm việc nơi bạn có thể hoàn thành nhiều việc hơn và làm việc hiệu quả nhất.