Maak kennis met Zoom AI Companion, je nieuwe AI-assistent!

Geef je productiviteit en teamsamenwerking een boost met Zoom AI Companion, een AI-assistent die zonder extra kosten is inbegrepen bij Zoom-abonnementen die ervoor in aanmerking komen.

Xuedong Huang, CTO van Zoom, bespreekt hoe kleine taalmodellen (SLM's) onze visie voor AI-agents sturen om samen te werken in een gefedereerde aanpak om je dagelijkse taken te verbeteren.

Bijgewerkt op February 25, 2025

Gepubliceerd op February 19, 2025

Xuedong Huang is de Chief Technology Officer (CTO). Vóór Zoom werkte hij bij Microsoft waar hij de functies van Azure AI CTO en Technical Fellow vervulde. Zijn carrière op het gebied van AI is indrukwekkend: hij richtte in 1993 de spraaktechnologiegroep van Microsoft op, leidde de AI-teams van Microsoft naar verschillende mijlpalen in de vorm van menselijke niveaus op het gebied van spraakherkenning, machinevertaling, begrip van natuurlijke taal en computer vision, is lid van het IEEE, ACM Fellow en een verkozen lid van de National Academy of Engineering en de American Academy of Arts and Sciences.

Xuedong behaalde een PhD in Electrical Engineering aan de Universiteit van Edinburgh in 1989 (gesponsord door de Britse ORS en Edinburgh University Scholarship), een Master of Science in Computer Science aan de Tsinghua University in 1984 en zijn Bachelor of Science in Computer Science aan de Hunan University in 1982.

Bij Zoom blijven we ons richten op innovatie, wat onze voortdurende verkenning van AI-first-transformatie door Zoom AI Com stimuleert. In het afgelopen jaar heb ik gedeeld hoe onze gefedereerde aanpak hoogwaardige resultaten oplevert en hoe onze focus op de kwaliteit van spraakherkenning een betere basis creëert voor onze andere AI-functies. Naarmate kunstmatige intelligentie zich verder ontwikkelt, versnellen we de adoptie van Agentic AI.

Tot nu toe heeft kunstmatige intelligentie vertrouwd op grote taalmodellen (LLM's) om te reageren op gebruikersprompts en gegenereerde antwoorden te geven. Er zijn echter nog veel meer mogelijkheden wanneer we kijken naar hoe SLM’s op maat gemaakte AI-agents kunnen verbeteren en versterken. We ontwikkelen AI Companion om agentic AI te ondersteunen die namens jou een reeks meerstapsacties kan uitvoeren.

Wanneer we AI beschouwen als agenten in plaats van op zichzelf staande vaardigheden en reacties, betekent dit dat ze verder gaan dan het invoeren van prompts om eenvoudige resultaten te leveren en in plaats daarvan een verlengstuk van onszelf en onze doelstellingen zouden moeten zijn. Hiervoor hebben onze AI-agents de volgende kenmerken:

Om deze AI-agents te realiseren, kondigen we met trots een belangrijke mijlpaal aan in dit traject: ons nieuw ontwikkelde Small Language Model (SLM) heeft geavanceerde prestaties geleverd in de categorie van 2 miljard parameters op een openbaar benchmarkklassement. Met maatwerk via Zooms aanstaande AI Studio ontwerpen we de SLM's van Zoom om de kwaliteit van 's werelds toonaangevende LLM’s in gespecialiseerde workloads te benaderen. Dit zal de weg vrijmaken voor AI Companion om complexe Agentic AI-taken uit te voeren met meerdere AI-agents die samenwerken voor ongeëvenaarde kosteneffectiviteit.

In de federatieve AI-aanpak van Zoom vertrouwen we niet op één enkel, allesomvattend groot model, maar pleiten we voor het orkestreren van meerdere aangepaste modellen. De SLM's van Zoom zijn ontworpen om deze aanpak te verbeteren door te optimaliseren voor specifieke taken. Door werklasten te verdelen over aangepaste SLM's met bijbehorende agenten—en tegelijkertijd gebruik te maken van toonaangevende LLM's—streven we naar het behalen van verschillende belangrijke voordelen:

Laten we bespreken wat deze doorbraak betekent en hoe deze zich precies verhoudt tot toonaangevende modellen.

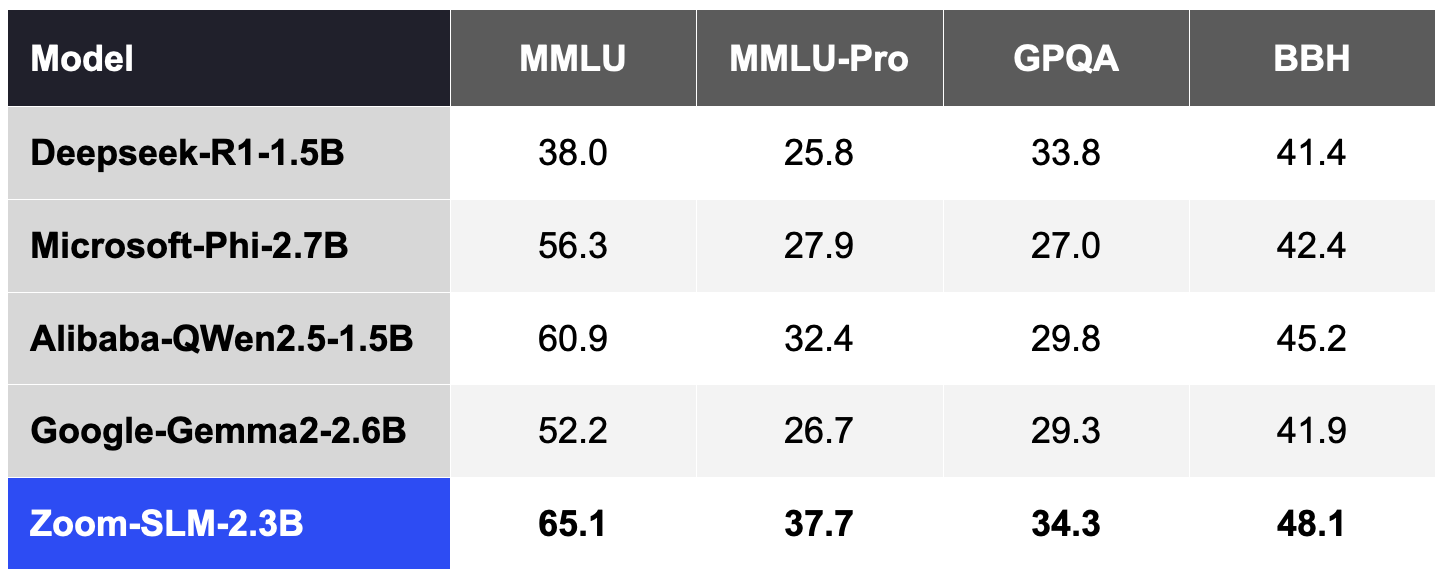

Om Zoom’s SLM te creëren, gebruikten we 6 biljoen tokens aan meertalige data en 256 Nvidia H100 GPU's. Van begin tot eind duurde de hele trainingscyclus ongeveer 30 dagen. De volgende tabellen beschrijven hoe de SLM-capaciteit van Zoom zich verhoudt tot andere modellen voor verschillende openbare benchmarks op basis van onze interne tests:

Conform de gangbare praktijk binnen de community hebben we de nauwkeurigheid van deze benchmarks geëvalueerd met behulp van de Lighteval-tool. Deze tool leverde 5 voorbeeldfoto’s van MMLU en MMLU-Pro, 2 voorbeeldfoto’s van GPQA en 3 voorbeeldfoto’s van BBH.

Tabel 1. Zoom SLM in vergelijking met andere SLM's in de 2B-categorie (hogere scores zijn beter).

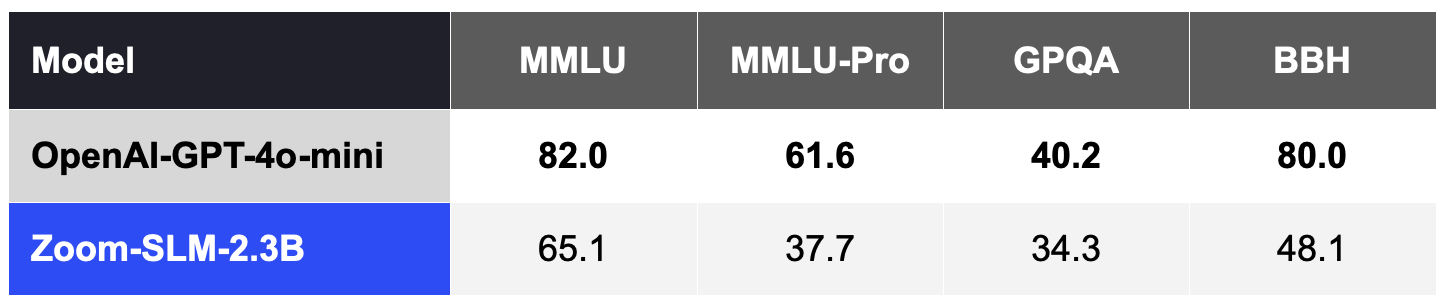

Over het algemeen blijven SLM's minder concurrerend op deze kwaliteitsmaatstaven dan toonaangevende LLM's, zoals GPT-4o-mini van OpenAI, zonder aanpassing voor een specifiek domein of een specifieke taak, zoals weergegeven in Tabel 2.

Tabel 2. Zoom SLM, zonder maatwerk, is minder concurrerend dan LLM's boven de 2B-categorie, zoals OpenAI GPT 4o-mini.

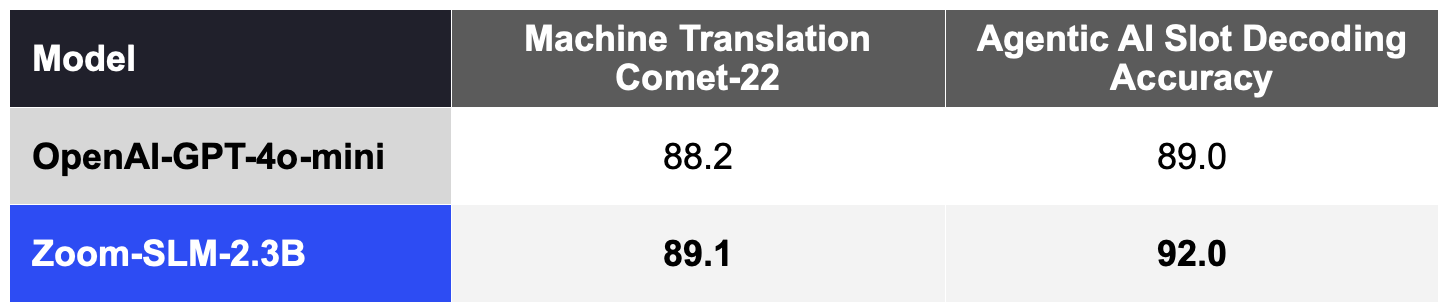

Het meest interessante resultaat is echter dat deze SLM's uitzonderlijke mogelijkheden kunnen bieden wanneer ze worden aangepast voor een specifieke taak. Door maatwerk met Zoom's AI Studio verwachten we de kwaliteitskloof met duurdere LLM's effectief te verkleinen. Aangepaste SLM's kunnen fungeren als gespecialiseerde agenten om belangrijke taken uit te voeren in samenwerking met LLM's, waarbij de nadruk ligt op het verbeteren van de nauwkeurigheid, snelheid en kosteneffectiviteit voor elke AI-agent.

Aangepaste SLM's kunnen uitblinken in taken zoals machinevertaling. Door de SLM aan te passen met 11,5 miljard tokens (inclusief synthetische data) die zijn ontworpen voor machinevertaling, hebben we de veelgebruikte COMET-22 kwaliteitsmetriek aanzienlijk verbeterd voor 14 taalparen, waaronder belangrijke talen zoals Chinees, Engels, Frans, Japans, Portugees en Spaans zoals weergegeven in tabel 3.

Onze SLM's kunnen ook worden aangepast om de Agentic AI-benchmark van AI Companion voor slotdecodering te ondersteunen, die meet hoe goed het model gebruikerscommando's interpreteert bij het uitvoeren van acties. Met 2 miljard synthetische tokens voor de gegevens van het Agentic AI-domein presteert de aangepaste SLM ook beter dan GPT-4o-mini, zoals te zien is in tabel 3.

Deze combinatie van efficiëntie en aanpassingsvermogen is ontworpen om Zoom in staat te stellen onze sterk verbeterde machinevertaling naar onze wereldwijde klanten te brengen en Zoom AI Studio te ondersteunen bij het aanpassen voor specifieke Agentic AI-werkbelastingen.

Tabel 3. Aangepaste Zoom SLM versus OpenAI GPT-4o-mini bij gespecialiseerde workloads, hogere scores zijn beter.

Deze aangepaste SLM's zullen de ruggengraat vormen van onze AI-agents, efficiënter werken en vergelijkbare resultaten opleveren als de duurdere LLM's die mensen momenteel gebruiken. Met onze gefedereerde AI zullen deze AI-agents en -vaardigheden zorgen voor ongeëvenaarde efficiëntie, kostenbesparing en nauwkeurigheid.

We zijn trots op onze vooruitgang en dit is nog maar het begin. Onze visie is om elke organisatie te voorzien van AI-agenten die kosteneffectieve en goed presterende oplossingen bieden. Dankzij de krachtige mogelijkheden van AI-agents en SLM’s helpt AI Companion je een werkplek te creëren waarin je meer gedaan krijgt en je het beste uit jezelf kunt halen.