Conozca Zoom AI Companion, su nuevo asistente de IA

Aumente la productividad y la colaboración en equipo con Zoom AI Companion, disponible sin coste adicional con planes de pago elegibles de Zoom.

El CTO de Zoom, Xuedong Huang, explica cómo los modelos de lenguaje reducidos (SLM) son fundamentales en nuestro planteamiento sobre cómo deben operar los agentes de IA que colaboran entre sí, por medio de un enfoque federado, para asistirle en sus tareas cotidianas.

Actualizado el February 25, 2025

Publicado el February 19, 2025

Xuedong Huang es el director de Tecnología (CTO). Antes de Zoom, trabajó en Microsoft, donde se desempeñó como director de Tecnología y colaborador técnico de Azure AI. Su trayectoria es destacada en el ámbito de la IA: fundó el grupo de tecnología del discurso de Microsoft en 1993, dirigió los equipos de IA de Microsoft para alcanzar varios de los primeros hitos de paridad humana del sector en reconocimiento del habla, traducción automática, comprensión del lenguaje natural y visión por computadora, es miembro del IEEE y la ACM y miembro electo de la Academia Nacional de Ingeniería y la Academia Estadounidense de las Artes y las Ciencias.

Xuedong obtuvo su doctorado en Ingeniería Eléctrica en la Universidad de Edimburgo en 1989 (patrocinado por la beca británica ORS y la Universidad de Edimburgo), su maestría en Ciencias de la Computación en la Universidad de Tsinghua en 1984 y su licenciatura en Ciencias de la Computación en la Universidad de Hunan en 1982.

En Zoom, seguimos enfocados en la innovación, lo que impulsa nuestra exploración continua de la transformación centrada en la IA con Zoom AI Companion. En el último año, he hablado sobre cómo nuestro enfoque federado ofrece resultados de alta calidad y cómo nuestro enfoque en la calidad del reconocimiento de voz crea una base más sólida para el resto de funciones de IA que ofrecemos. La mejora continua de la IA nos permite avanzar rápidamente en la adopción de la IA agéntica.

Hasta ahora, la IA ha dependido de modelos extensos de lenguaje (LLM) para responder a las solicitudes del usuario y proporcionar respuestas generadas. Sin embargo, las posibilidades se multiplican cuando pensamos en cómo los SLM pueden potenciar los agentes de IA personalizados. Estamos desarrollando AI Companion para que una IA agéntica pueda gestionar por usted una serie de acciones en varios pasos.

Al ver la IA como agentes y no solo como habilidades o respuestas independientes, entendemos que su papel va más allá de procesar instrucciones simples: deben actuar como una extensión de nuestra voluntad y objetivos. Para lograrlo, nuestros agentes de IA cuentan con las siguientes características:

Para ayudar a hacer realidad estos agentes de IA, estamos encantados de anunciar un hito significativo en este periplo: nuestro nuevo modelo de lenguaje reducido (SLM) ha alcanzado un rendimiento de vanguardia dentro de la categoría de 2000 millones de parámetros en la tabla de clasificación de referencia pública. A través de la personalización que ofrecerá el próximo AI Studio de Zoom, estamos diseñando los SLM de Zoom para que alcancen una calidad comparable a la de los LLM líderes del sector en tareas especializadas. Esto abrirá el camino para que AI Companion realice tareas complejas de IA agéntica con múltiples agentes de IA trabajando de forma paralela para ofrecer una rentabilidad sin parangón.

En el enfoque de IA federada de Zoom, en lugar de depender de un único y complejo modelo grande, apostamos por coordinar múltiples modelos personalizados. Los SLM de Zoom han sido diseñados para potenciar esta estrategia, ya que se optimizan para tareas específicas. Al distribuir las cargas de trabajo entre SLM personalizados y sus agentes correspondientes —sin dejar de aprovechar los principales LLM— buscamos alcanzar varios beneficios clave:

Veamos qué significa este avance y qué ventajas ofrece frente a los modelos líderes del sector.

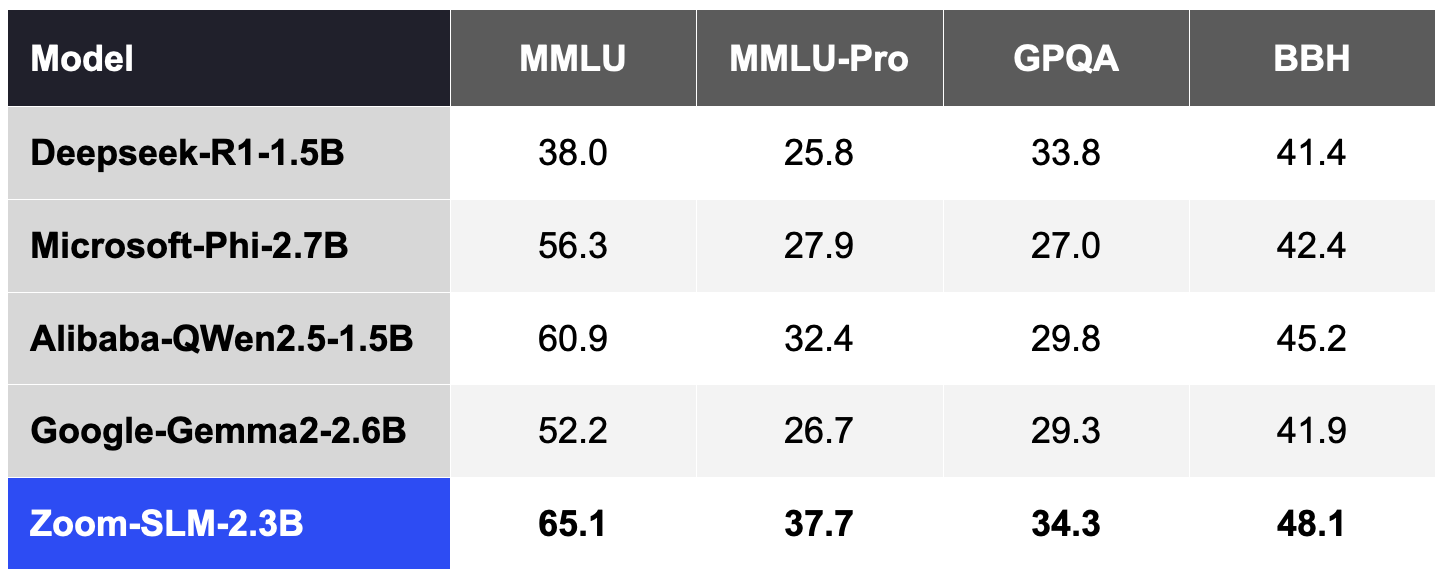

Para crear un SLM de Zoom, utilizamos 6 billones de tokens de datos multilingües y 256 GPU Nvidia H100. De principio a fin, todo el ciclo de formación tomó aproximadamente 30 días. Las siguientes tablas comparan las capacidades de los SLM de Zoom con las de otros modelos para varios puntos de referencia públicos según nuestras pruebas internas:

Siguiendo la práctica habitual de la comunidad, evaluamos la precisión de estos puntos de referencia mediante la herramienta Lighteval, que proporcionó 5 ejemplos en MMLU y MMLU-Pro, 2 en GPQA y 3 en BBH.

Tabla 1. Zoom SLM en comparación con otros SLM en la categoría 2B (las puntuaciones más altas son mejores).

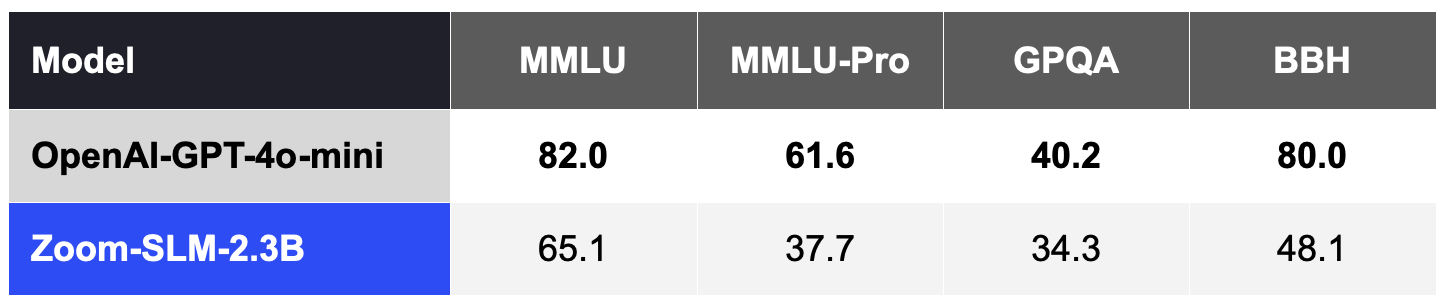

En general, los SLM siguen siendo menos competitivos en estas medidas de calidad que los principales LLM, como el GPT-4o-mini de OpenAI, sin personalización para un dominio o una tarea específicos, tal y como se muestra en la tabla 2.

Tabla 2. Zoom SLM, sin personalización, es menos competitivo que los LLM superiores a la categoría 2B, como OpenAI GPT-4o-mini.

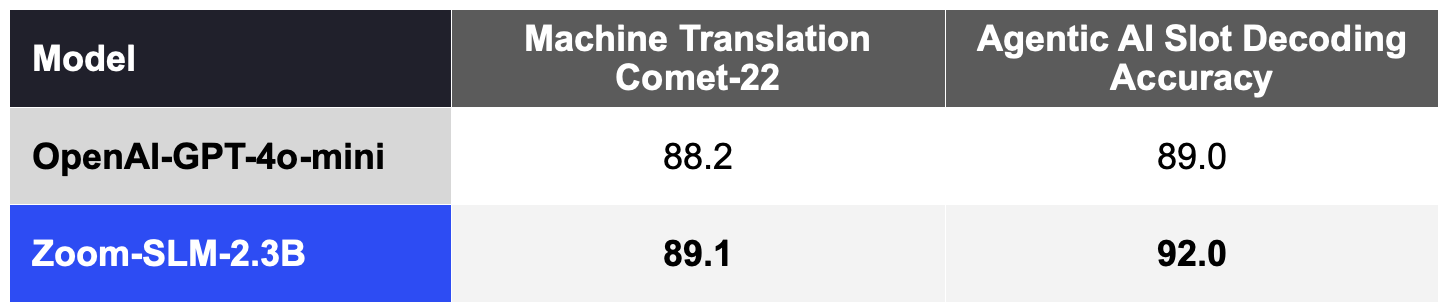

Sin embargo, el resultado más interesante es que estos SLM pueden ofrecer capacidades excepcionales cuando se personalizan para una tarea especializada. Mediante la personalización con AI Studio de Zoom, esperamos reducir de forma eficaz la brecha de calidad frente a los LLM más costosos. Los SLM personalizados pueden actuar como agentes especializados para llevar a cabo tareas clave en coordinación con los LLM para priorizar la mejora de la precisión, la velocidad y la rentabilidad de cada agente de IA.

Los SLM personalizados pueden sobresalir en tareas como la traducción automática. Al adaptar el SLM con 11,5 mil millones de tokens (incluidos datos sintéticos) diseñados para la traducción automática, hemos mejorado de forma significativa las métricas de calidad COMET-22 ampliamente adoptadas en 14 pares de idiomas, que incluyen idiomas principales como el chino, el inglés, el francés, el japonés, el portugués y el español , tal y como se muestra en la tabla 3.

Nuestros SLM también pueden personalizarse para admitir el estándar de referencia de IA agéntica de AI Companion para la decodificación de campos, que mide la precisión con la que el modelo interpreta los comandos del usuario al ejecutar acciones. Gracias a sus 2000 millones de tokens sintéticos para los datos del dominio de IA agéntica, el SLM personalizado también supera al GPT-4o-mini, tal y como se muestra en la tabla 3.

Mediante esta combinación de eficiencia y adaptabilidad, desde Zoom podemos ofrecer una traducción automática muy mejorada a nuestros clientes de todo el mundo, así como respaldar a Zoom AI Studio en la personalización de cargas de trabajo específicas para la IA agéntica.

Tabla 3. Zoom SLM personalizado frente a OpenAI GPT-4o-mini en cargas de trabajo especializadas (las puntuaciones más altas son mejores).

Estos SLM personalizados serán el pilar de nuestros agentes de IA, al operar de forma más eficiente y ofrecer resultados comparables a los LLM más costosos que suelen usarse en la actualidad. Gracias a nuestra IA federada, estos agentes y habilidades de IA contribuirán a mejorar de forma significativa la eficiencia, a reducir costes y a aumentar la precisión de una manera nunca vista.

Nos enorgullecemos de nuestro progreso, ¡y esto es solo el principio! Nuestro objetivo es dotar a cada organización de agentes de IA que proporcionen soluciones rentables y de alto rendimiento. Gracias a las capacidades adicionales de los agentes de IA y los SLM, AI Companion le ayudará a crear un entorno de trabajo donde pueda ser más productivo y dar lo mejor de sí mismo.