Report sulle prestazioni audio e video di Zoom 2024

La qualità audio e video è un aspetto fondamentale delle riunioni virtuali. Quando una delle due è scadente o, peggio, totalmente insufficiente, l’esperienza utente ne risente e può generare frustrazione. Per noi di Zoom è importante valutare sempre le prestazioni di Zoom Meetings rispetto ad altre soluzioni di videoconferenza. Per questo motivo, abbiamo incaricato TestDevLab di analizzare la qualità audio e video in diverse condizioni e diversi tipi di chiamata confrontando i seguenti fornitori:

- Zoom

- Microsoft Teams

- Google Meet

- Cisco Webex

I risultati forniti in questo report riflettono i risultati dei test eseguiti da TestDevLab ad aprile 2024.

Informazioni su TestDevLab

TestDevLab (TDL) offre servizi di software testing e quality assurance per applicazioni per dispositivi mobili, web e desktop, oltre allo sviluppo di strumenti di testing personalizzati. L’azienda è specializzata in software testing e quality assurance e sviluppa soluzioni personalizzate avanzate per test sulla sicurezza, sul consumo della batteria e sull’utilizzo dei dati nelle app per dispositivi mobili. Esegue inoltre valutazioni della qualità audio e video per applicazioni VoIP o di comunicazione, oltre a test automatizzati di API backend e test di carico e prestazioni web.

Il team di TestDevLab è composto da oltre 500 ingegneri altamente qualificati specializzati in software testing e sviluppo. La maggior parte dei loro test engineer possiede certificazioni dell’International Software Testing Qualifications Board (ISTQB), che garantiscono un elevato livello di competenza nei test software, in linea con gli standard di settore e con la qualità del servizio.

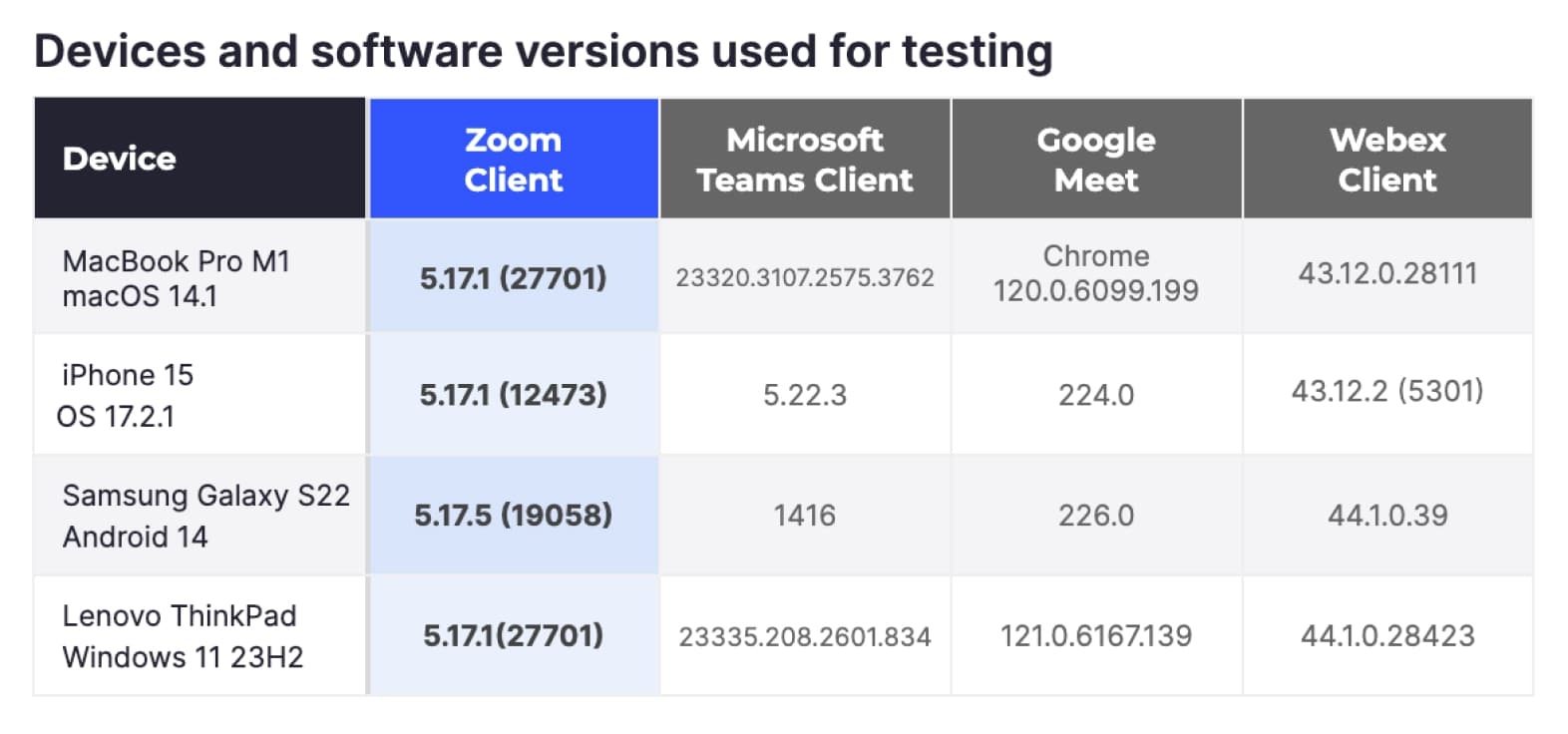

Per garantire un test equo tra tutti i fornitori, tutti i test sono stati eseguiti utilizzando le apparecchiature e gli account di TestDevLab. Inoltre, gli account dei singoli fornitori sono stati mantenuti alla configurazione predefinita, ad eccezione dell’abilitazione della risoluzione massima HD (1080p) per i fornitori che limitano la risoluzione video per impostazione predefinita.

Gli scenari di test prevedevano un dispositivo "Ricevente", un dispositivo "Mittente" e altri che fungevano da partecipanti aggiuntivi. Tutti i dispositivi erano collegati alla stessa videochiamata. A seconda dello scenario di test, il layout della chiamata e le impostazioni di rete sono stati configurati per riprodurre i parametri richiesti.

Dispositivi e versioni software utilizzate per i test

Scenari di test

Per avere una visione complessiva della qualità audio e video in Zoom Meetings, abbiamo chiesto a TestDevLab di testare gli scenari di riunione più comuni, utilizzando hardware di uso comune.

Scenari di rete variabili

Per questi scenari, abbiamo voluto testare la reazione delle diverse piattaforme in varie condizioni di rete utilizzando alcune piattaforme di elaborazione comuni. Per raggiungere questo obiettivo, TDL ha utilizzato quattro piattaforme hardware popolari: computer MacBook Pro, computer Windows, iPhone e dispositivi Android. Abbiamo configurato il tipo di riunione più comune con tre partecipanti, senza contenuti condivisi e con impostazione vista presentatore/oratore per garantire la massima risoluzione video.

Gli scenari di rete testati includevano:

- Rete pulita: nessuna limitazione di rete, utilizzata come valore di riferimento.

- Rete limitata a 1 Mbps: la larghezza di banda di rete è stata limitata a 1 Mbps.

- Rete limitata a 500 Kbps: la larghezza di banda della rete è stata limitata a 500 Kbps.

- Perdita di pacchetti variabile: le riunioni sono iniziate con una perdita di pacchetti del 10%, che è passata al 20% dopo 1 minuto e poi al 40% dopo un altro minuto.

- Latenza variabile: le riunioni Zoom sono iniziate senza limitazioni. Dopo 1 minuto, sono stati introdotti 100 ms di latenza e 30 ms di jitter per 1 minuto. Poi la latenza è stata aumentata a 500ms e il jitter a 90ms.

- Ripristino della rete: le riunioni sono iniziate senza limitazioni. Dopo 1 minuto, è stato simulato un problema di rete che limitava la larghezza di banda a 1 Mbps, è stata aggiunta una perdita di pacchetti del 10% e sono stati introdotti 100 ms di latenza e 30 ms di jitter per 1 minuto, dopodiché la rete è tornata alla condizione pulita.

- Rete mobile 3G: è stata effettuata una videochiamata sulla rete mobile 3G su dispositivi mobili.

- Test di rete congestionata: la chiamata è iniziata con una rete pulita e poi, a intervalli variabili, sono stati inviati brevi picchi di dati ad alto volume per simulare una rete occupata.

Ogni chiamata è durata tre minuti ed è stata ripetuta cinque volte. TDL ha effettuato un totale di 420 riunioni considerando tutti i fornitori, le varianti hardware e le condizioni di rete.

Quando sono state applicate limitazioni alla chiamata, queste hanno interessato solo il dispositivo testato in qualità di "ricevente".

Scenari con tipologie di chiamata variabili

Per questi scenari, abbiamo voluto testare le diverse tipologie di chiamata e le tecnologie utilizzate dalla maggior parte degli utenti. L’hardware impiegato era limitato a computer MacBook Pro M1 e computer Windows. Gli scenari includevano riunioni con cinque e otto partecipanti, organizzate in modalità galleria. TDL ha testato riunioni solo con partecipanti, riunioni con solo partecipanti, riunioni con condivisione di contenuti e riunioni in cui i partecipanti hanno attivato sfondi virtuali.

In tutti i casi, la rete è rimasta pulita e senza limitazioni. Come in precedenza, ogni riunione è durata tre minuti ed è stata ripetuta cinque volte. Complessivamente, TDL ha condotto altre 240 riunioni in questa categoria.

Metriche acquisite

Per generare un quadro completo della qualità delle riunioni, abbiamo chiesto a TDL di acquisire metriche in quattro categorie principali relative alla qualità audio e video, all’utilizzo della rete e all’utilizzo delle risorse. Le metriche sono state registrate in ogni secondo di riunione e salvate in un database centralizzato.

Qualità audio

- Punteggio MOS: il Mean Opinion Score (MOS) quantifica la qualità di una chiamata sulla base delle valutazioni degli utenti, generalmente su una scala da 1 (scarsa) a 5 (eccellente), riflettendo la chiarezza audio percepita e l’esperienza complessiva.

- ViSQOL: ViSQOL (Virtual Speech Quality Objective Listener) è una metrica oggettiva che valuta la qualità di una chiamata confrontando la somiglianza tra il segnale audio originale e quello trasmesso utilizzando un modello percettivo.

- Ritardo audio: il ritardo audio misura la latenza tra la parola pronunciata e la sua ricezione da parte dell’ascoltatore; valori più bassi indicano un ritardo minore e una qualità della chiamata superiore.

Qualità video

- Fotogrammi al secondo (FPS): i fotogrammi al secondo (FPS) misurano il numero di singoli fotogrammi visualizzati al secondo in un video. FPS più elevati garantiscono movimenti più fluidi e una migliore qualità video.

- VMAF: Video Multi-method Assessment Fusion (VMAF) è una metrica percettiva di qualità video sviluppata da Netflix, che combina diverse metriche di qualità per prevedere la soddisfazione dello spettatore e la qualità video.

- VQTDL: Video Quality Temporal Dynamics Layer (VQTDL), una metrica sviluppata da TDL, valuta la qualità video analizzando le variazioni temporali e dinamiche, catturando come i cambiamenti nel tempo influenzano l’esperienza complessiva di visione.

- PSNR: Peak Signal-to-Noise Ratio (PSNR) è una metrica matematica utilizzata per misurare la qualità di un video confrontando i fotogrammi video originali e quelli compressi. Valori più alti indicano una minore distorsione e una qualità migliore.

- Ritardo video: il ritardo video indica il tempo di latenza tra la cattura del video in tempo reale e la sua visualizzazione sullo schermo remoto. Un ritardo più basso indica un’esperienza di riunione più vicina al tempo reale.

- Blocco video: il blocco video misura la frequenza e la durata delle pause o degli arresti nel flusso video; blocchi meno frequenti e più brevi indicano una migliore qualità video.

Utilizzo delle risorse

- L’utilizzo della CPU misura la percentuale della capacità dell’unità di elaborazione centrale (CPU) utilizzata dal client della riunione.

- L’utilizzo della memoria si riferisce alla quantità di memoria ad accesso casuale (RAM) utilizzata dal client della riunione.

- L’utilizzo della GPU misura la percentuale della capacità dell’unità di elaborazione grafica (GPU) utilizzata dal client della riunione.

Utilizzo della rete

- Bitrate del mittente: la quantità di dati di rete inviati da ciascun dispositivo durante la riunione

- Bitrate del ricevente: la quantità di dati di rete ricevuti da ciascun dispositivo durante la riunione

Non tutte le metriche possono essere acquisite su tutte le piattaforme. Ad esempio, non tutte le metriche di utilizzo delle risorse possono essere misurate sui dispositivi mobili. TDL ha comunque massimizzato l’acquisizione delle metriche in ciascun scenario di chiamata.

Per semplificare la presentazione della grande quantità di informazioni raccolte da TDL, abbiamo valutato ciascuna delle metriche in base a una scala da 1 a 4, dove 1 è il punteggio migliore e 4 è il peggiore. Abbiamo poi sommato i punteggi delle metriche nelle quattro categorie. I totali più bassi indicano le migliori prestazioni in ciascuna categoria.

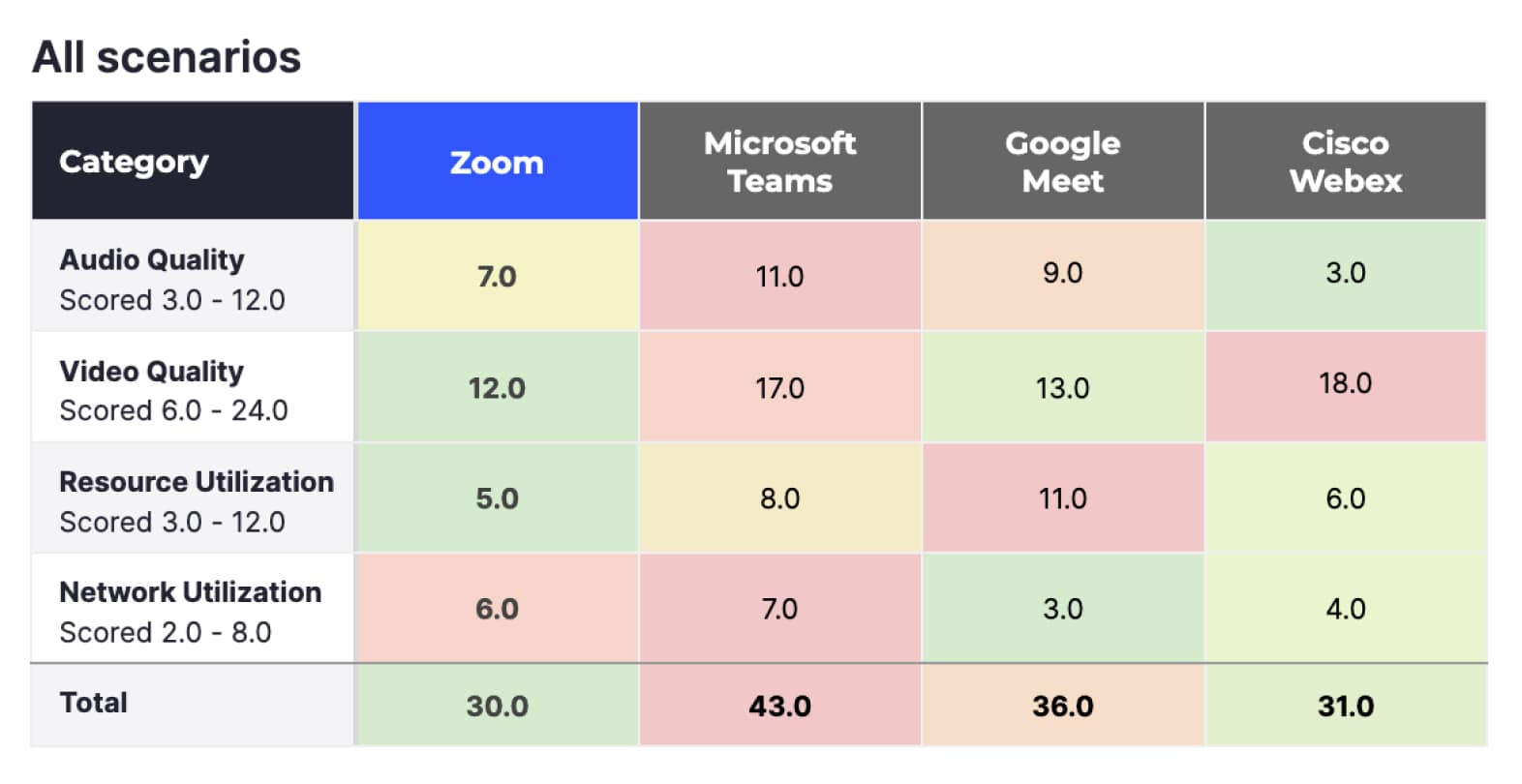

Questa sezione analizza i risultati a un livello generale, applicando diversi filtri per focalizzarsi su categorie di chiamata differenti. Successivamente, ci concentreremo sui singoli scenari di chiamata, fornendo informazioni più dettagliate sul comportamento delle diverse piattaforme in ciascuno di essi. Per informazioni più approfondite, consulta la sezione "Risultati dettagliati".

I risultati sopra riportati includono i punteggi di tutte le 660 riunioni, inclusi tutti i dispositivi e gli scenari di rete:

- Considerando tutte le metriche, Zoom ha ottenuto il punteggio migliore (30), seguito a breve distanza da Cisco Webex (31). Google Meet (36) e Microsoft Teams (43) hanno ottenuto punteggi inferiori.

- Zoom ha ottenuto i punteggi migliori per qualità video e utilizzo delle risorse (rispettivamente 12 e 5). Questo risultato è dato dal fatto che Zoom Meetings sposta la maggior parte delle funzioni di elaborazione video dalla CPU alla GPU, lasciando la CPU libera per eseguire altre applicazioni sul dispositivo.

- Per utilizzo della rete, Google Meet (3) ha ottenuto il punteggio più alto.

- Per la qualità audio, Cisco Webex ha ottenuto il punteggio più alto (3), seguito da Zoom (7). Google Meet (9) e Microsoft Teams (11) hanno ottenuto punteggi inferiori.

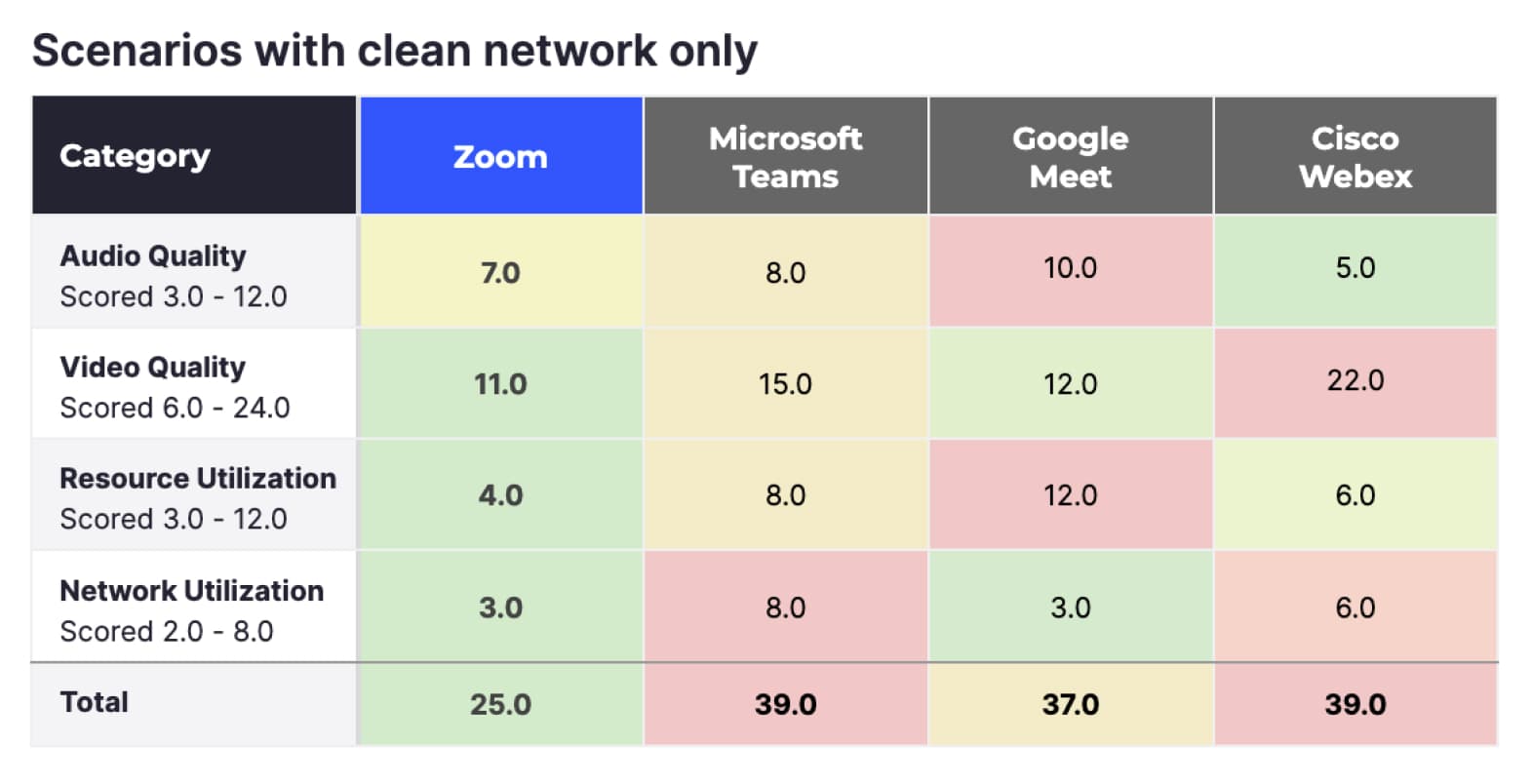

Scenari solo con rete pulita

Il punteggio complessivo riportato sopra rappresenta l’insieme di tutti i test di TestDevLab, ma nella realtà la maggior parte degli utenti non riscontra molte delle limitazioni di rete simulate da TDL. I risultati riportati di seguito escludono tutti i test con limitazioni di rete, mantenendo solo quelli eseguiti su rete pulita.

Per quanto riguarda le riunioni con rete pulita, Zoom (25) ottiene un punteggio ancora migliore, Google Meet (37) si classifica al secondo posto e Microsoft Teams (39) e Cisco Webex (39) si classificano ultimi.

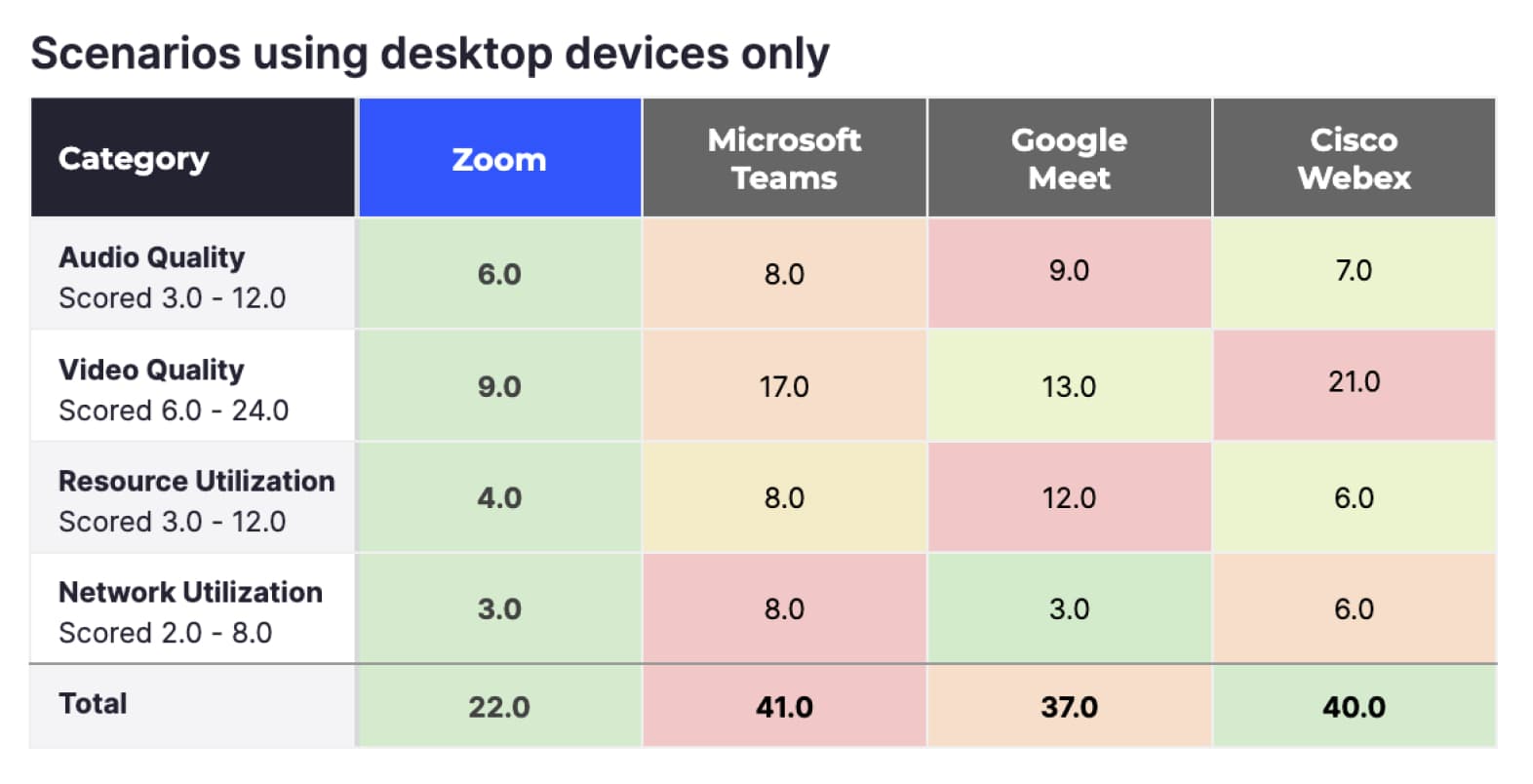

Scenari con dispositivi desktop

Sebbene molte persone utilizzino dispositivi mobili per partecipare alle riunioni, in media circa il 66% di tutti i partecipanti Zoom si collega tramite dispositivi desktop (secondo le statistiche interne di Zoom). Filtrando i dati per solo desktop e riunioni senza problemi di rete, il vantaggio di Zoom aumenta ulteriormente e si posiziona al primo posto in tutte le quattro metriche.

Riepilogo

Zoom supera i servizi di videoconferenza alternativi testati da TDL in tutte le categorie misurate in condizioni ideali e con i dispositivi più comunemente utilizzati. Poiché le condizioni non sono sempre ideali, è importante valutare anche gli scenari in cui gli utenti potrebbero riscontrare problemi di rete.

I fornitori possono adattarsi automaticamente alle variazioni delle condizioni di rete per mantenere una qualità audio e video elevata. I protocolli di ciascun fornitore si adattano in modo diverso, modificando potenzialmente risoluzione video, qualità della compressione, FPS e altri parametri. L’esperienza complessiva dell’utente durante una videochiamata dipende da quanto efficacemente il fornitore riesce a mantenere ottimizzati questi parametri al variare delle condizioni di rete.

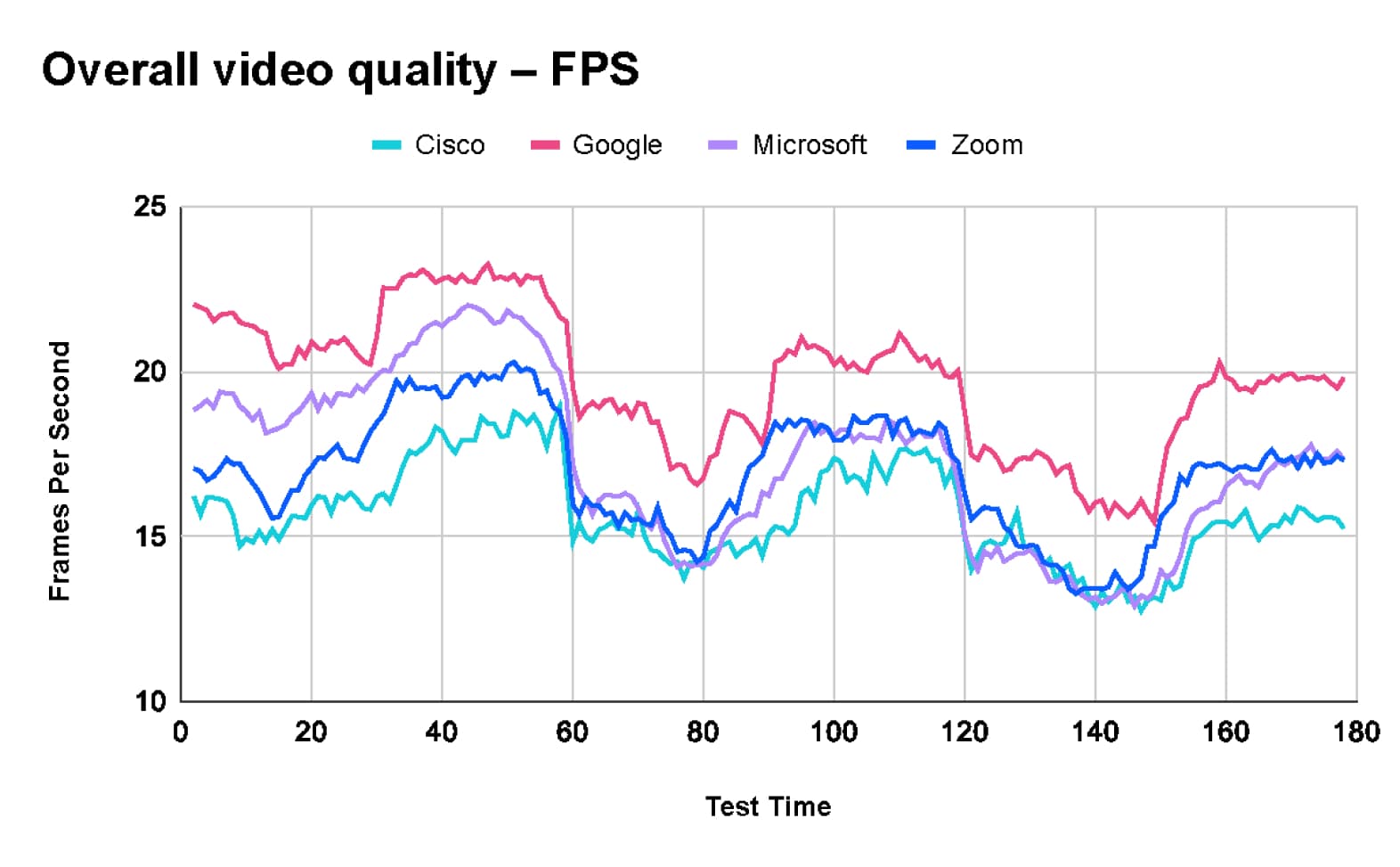

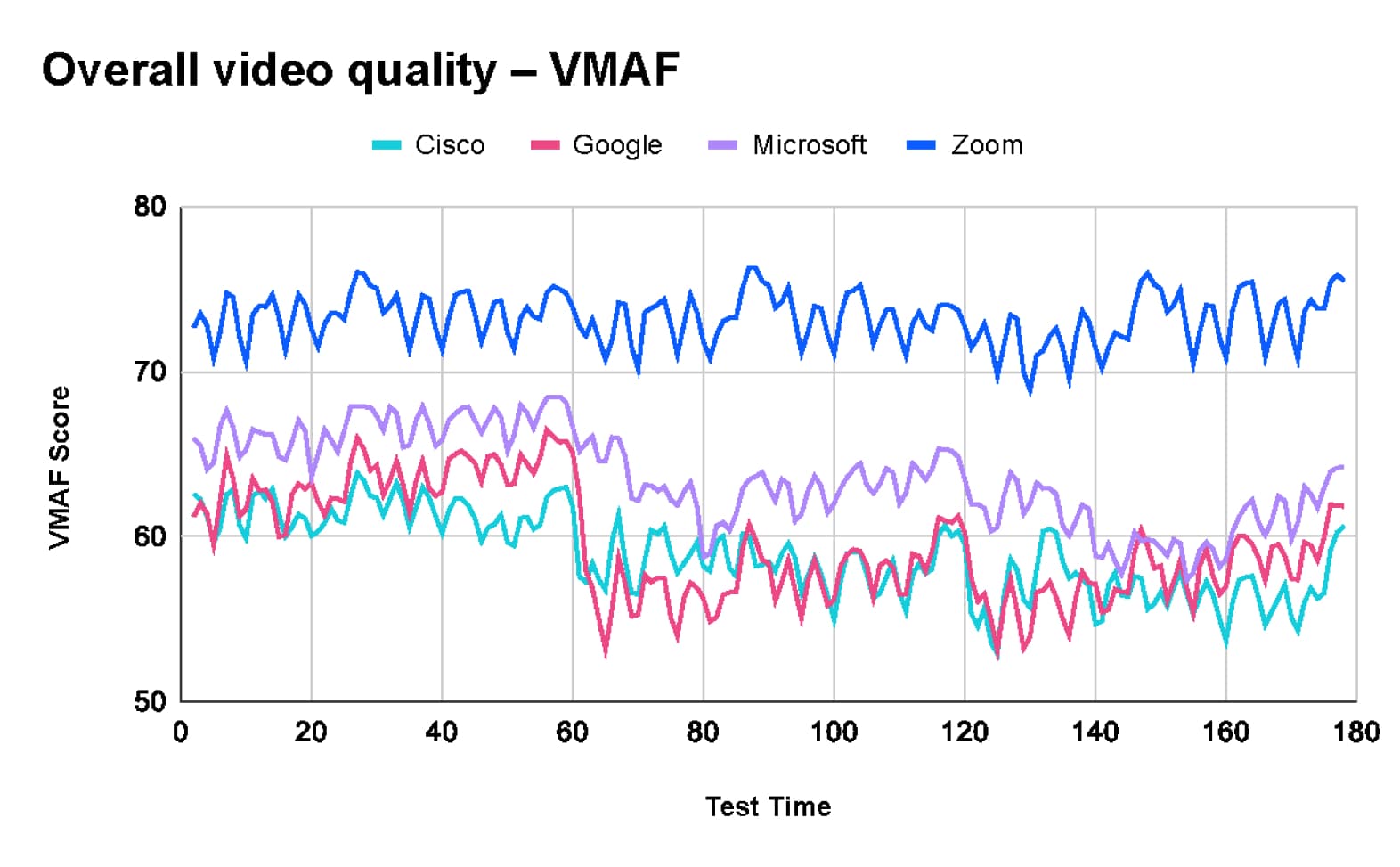

TestDevLab ha acquisito diverse metriche per misurare l’esperienza complessiva dell’utente durante una chiamata. Le due metriche più significative raccolte sono VMAF, che misura la qualità percepita dell’immagine e i fotogrammi al secondo (FPS), che indicano la fluidità del video.

Qualità video complessiva in tutti i test

Dopo aver analizzato i risultati combinati di 660 test, TDL ha rilevato che Google Meet offre la frequenza media di fotogrammi più alta, pari a 20 fotogrammi al secondo (fps). In confronto, Microsoft Teams e Zoom hanno entrambi una media di 17 fps, mentre Webex raggiunge una media di 16 fps.

Tuttavia, la frequenza di fotogrammi più elevata di Google Meet comporta un compromesso sulla qualità video. Secondo il grafico Video Multimethod Assessment Fusion (VMAF), Zoom è in testa per qualità con un punteggio medio di 73,2. Seguono Microsoft Teams con 63,5, Google Meet con 59,5 e Webex con un punteggio medio di 58,9.

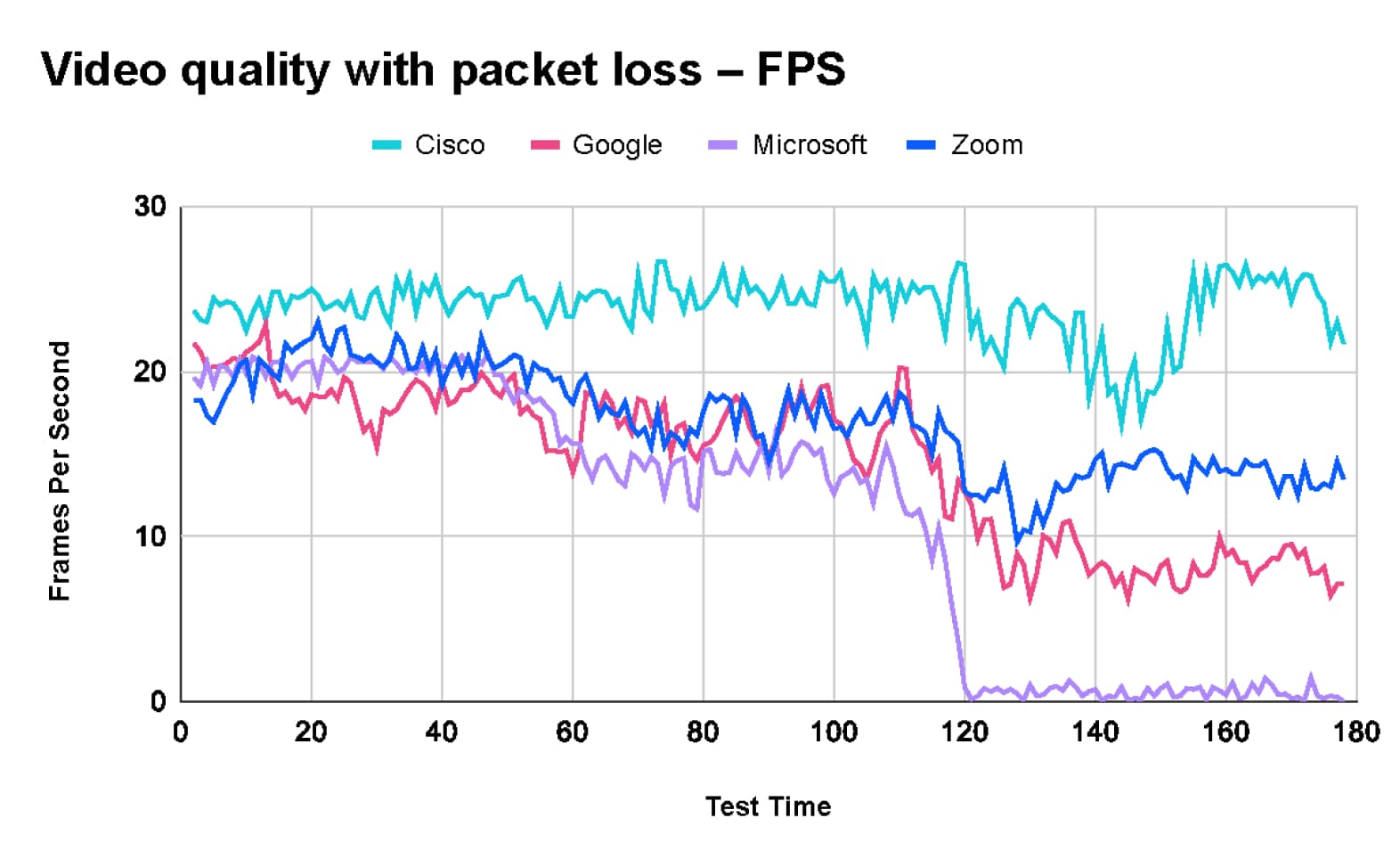

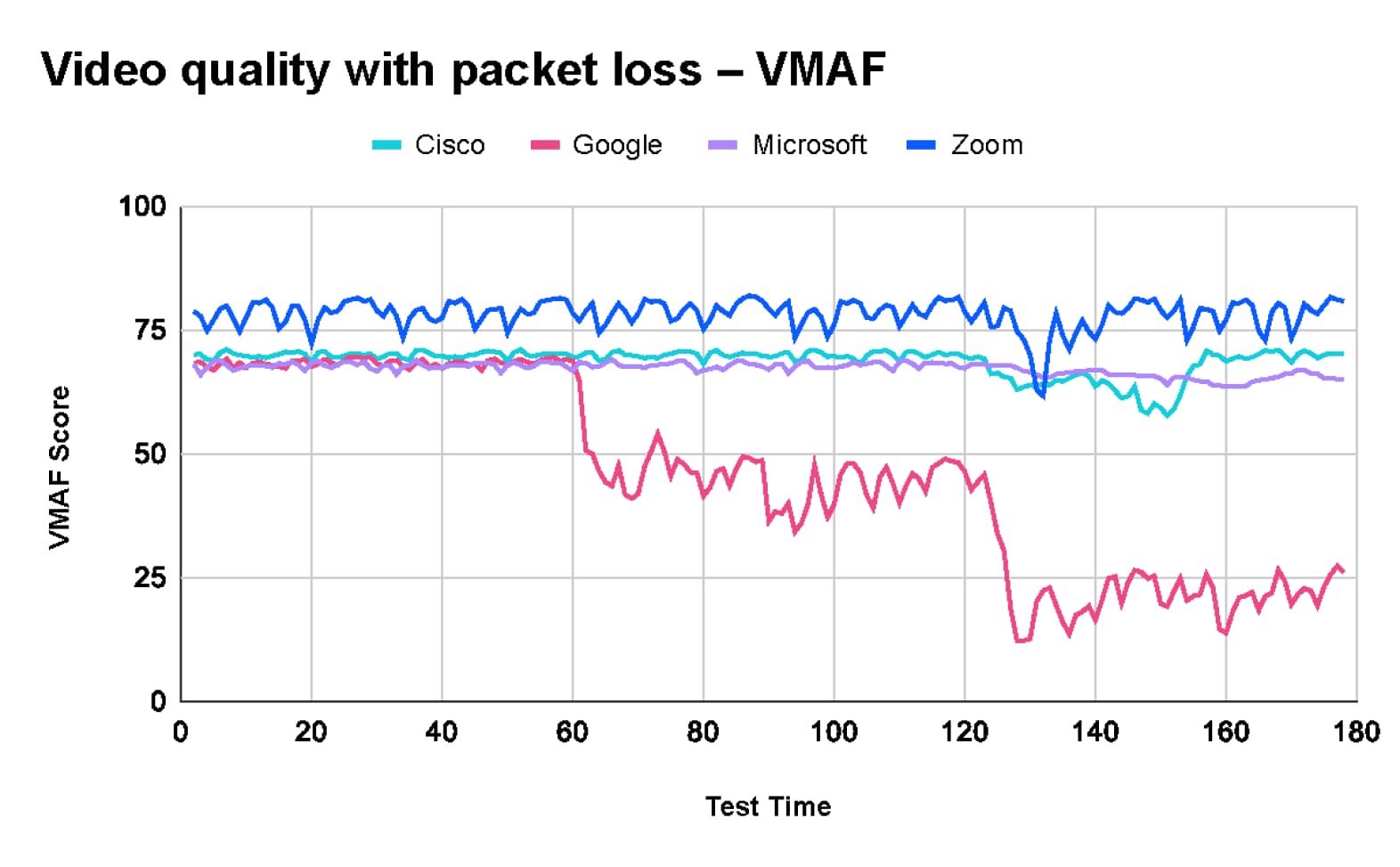

Qualità video con perdita di pacchetti

Il test con perdita di pacchetti condotto da TestDevLab si è svolto in tre fasi.

- La chiamata è iniziata con una perdita di pacchetti del 10%.

- Dopo 60 secondi, la perdita di pacchetti è aumentata al 20%.

- Dopo altri 60 secondi, la perdita di pacchetti è aumentata ulteriormente fino al 40%.

Come mostrato nei grafici seguenti:

- Zoom mantiene la massima qualità video con un punteggio VMAF di circa 80, ma la frequenza di fotogrammi scende da circa 20 fps a 13 fps.

- Webex mantiene relativamente stabile la qualità video e la frequenza di fotogrammi per tutta la durata del test.

- Google Meet registra un calo significativo del punteggio VMAF, passando da 70 a 20 con una perdita di pacchetti del 40%, e la frequenza di fotogrammi diminuisce da circa 15 fps a 8 fps entro la fine del test.

- Microsoft Teams mantiene una buona qualità dell’immagine con un punteggio VMAF di 70. Tuttavia, la frequenza di fotogrammi cala drasticamente, passando da circa 20 fps all’inizio del test a 2 fps quando viene introdotta una perdita di pacchetti del 40%, con un video praticamente fermo.

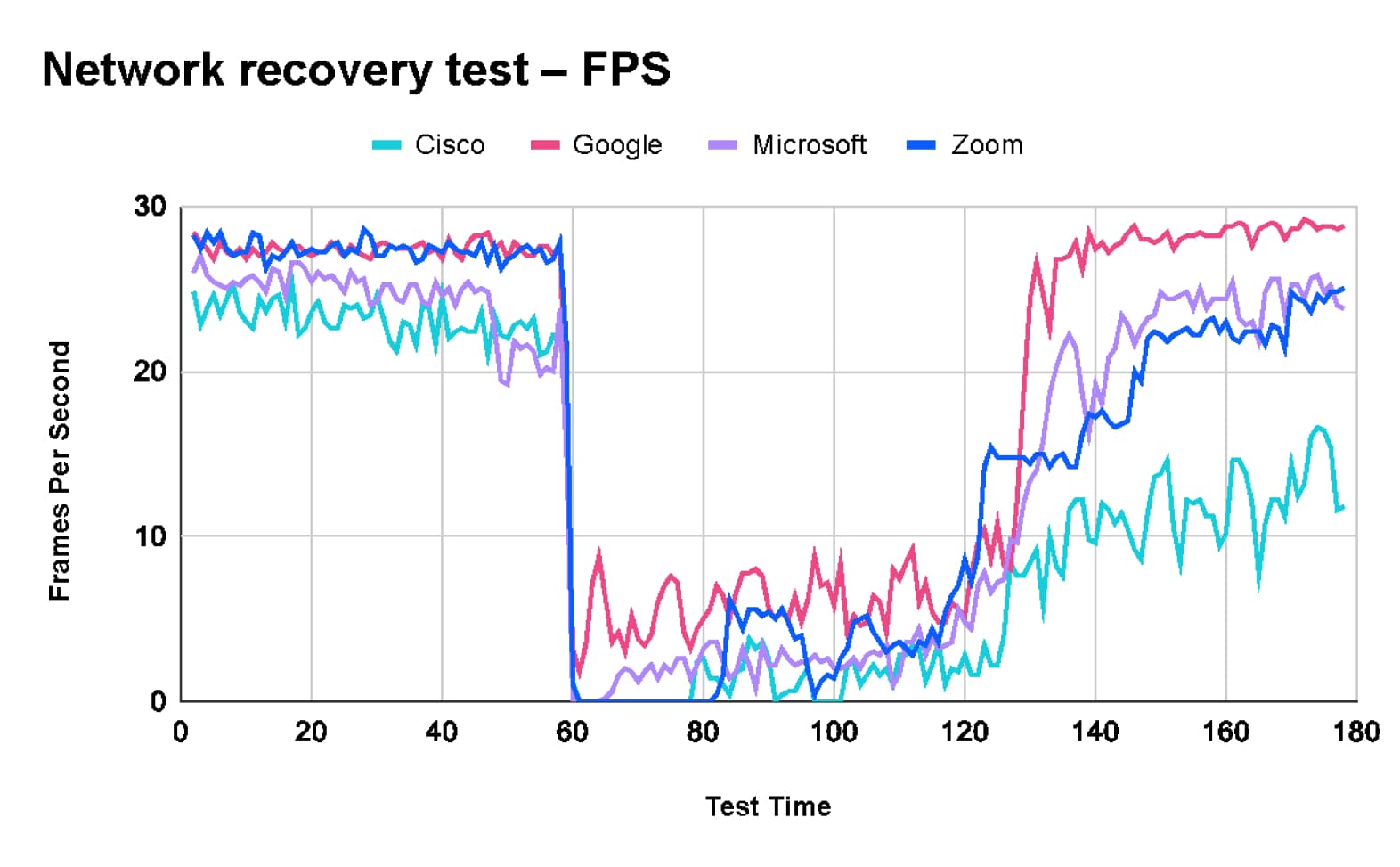

Test di ripristino della rete

Nel test di ripristino della rete, TDL ha iniziato il test con una rete pulita.

- Al 60° secondo, sono stati introdotti numerosi problemi di rete, tra cui un limite di 1 Mbps, una perdita di pacchetti del 10%, un ritardo di 100 ms e un jitter di 30 ms.

- Dopo 60 secondi di "problemi di rete", le limitazioni sono state rimosse e la rete è tornata al suo stato originale.

Questo test è stato progettato per valutare il comportamento delle piattaforme testate in presenza di un problema temporaneo di rete e la capacità di ciascuna piattaforma di recuperare una volta risolto il problema.

I risultati del test mostrano che, pur mantenendo una qualità video elevata, a Zoom servono circa 10 secondi per riadattare i parametri del codec alle nuove condizioni di rete, con una conseguente frequenza di fotogrammi molto bassa per alcuni secondi. Per quanto riguarda i tempi di recupero, Zoom si colloca a metà classifica, tra Webex, che impiega più tempo, e Teams e Google Meet che recuperano più velocemente.

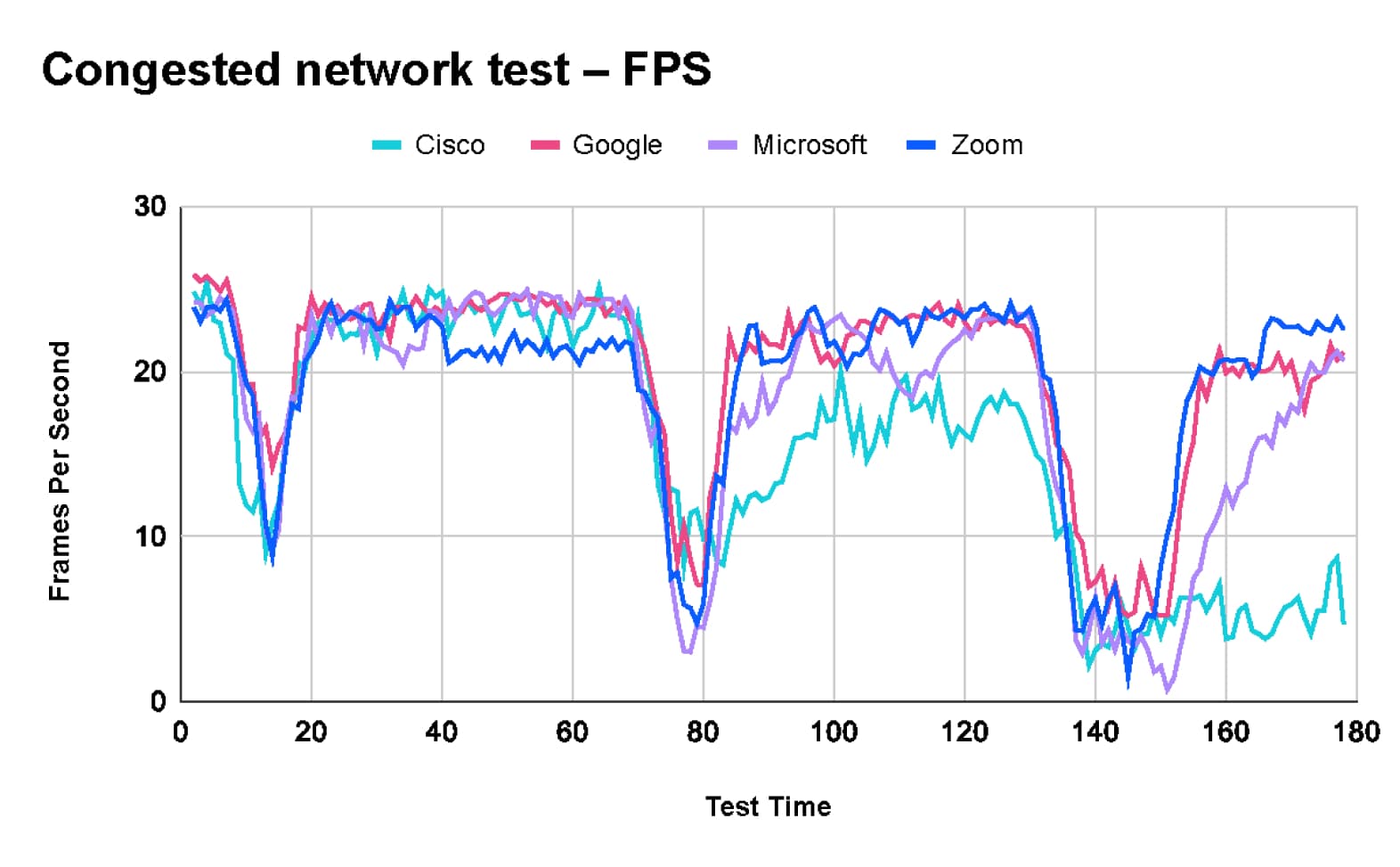

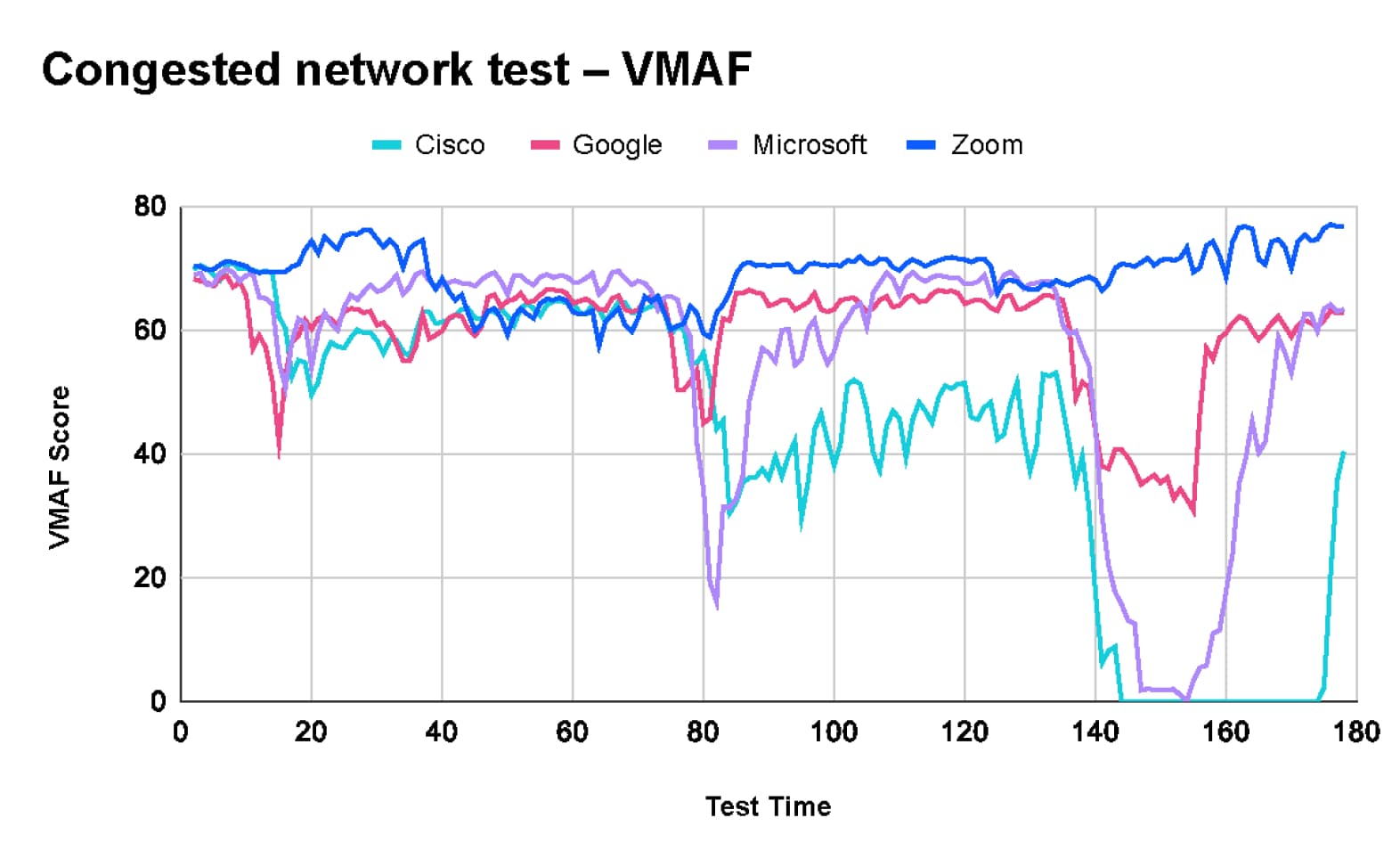

Test con rete congestionata

L’obiettivo del Test con rete congestionata era valutare il comportamento delle piattaforme testate durante periodi di congestione di rete di durata variabile e la loro capacità di mantenere le prestazioni su reti soggette a picchi di traffico intermittenti.

- Lo script del test alternava periodi di inattività a picchi di traffico di 10 Mbps (su una linea da 10 Mbps), con durate di congestione crescenti e intervalli di pausa variabili tra un picco e l’altro.

I risultati del test mostrano che Zoom mantiene la qualità dell’immagine per tutta la durata del test, sacrificando però la frequenza di fotogrammi e il ritardo video per adattarsi alle mutevoli condizioni della rete. In particolare, Webex ha completamente interrotto la riproduzione del video entro la fine del test.

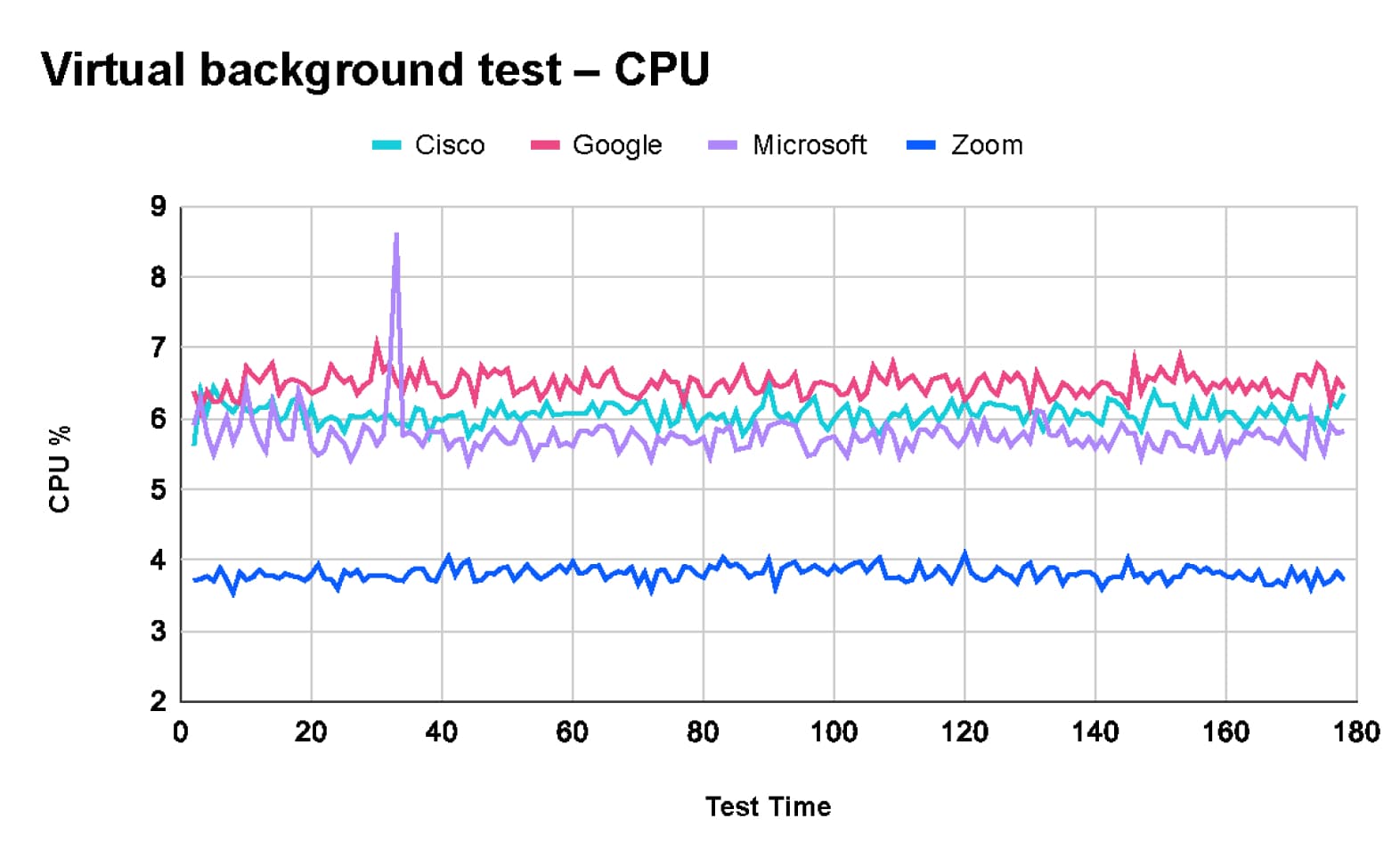

Test sulla qualità degli sfondi virtuali

Nei nostri scenari di test, abbiamo chiesto a TDL di valutare l’esperienza utente della funzionalità di sfondo virtuale. Questa funzionalità, che sostituisce lo sfondo reale dell’utente con un’immagine o un video, richiede un’elaborazione significativa per generare un’immagine composita di alta qualità.

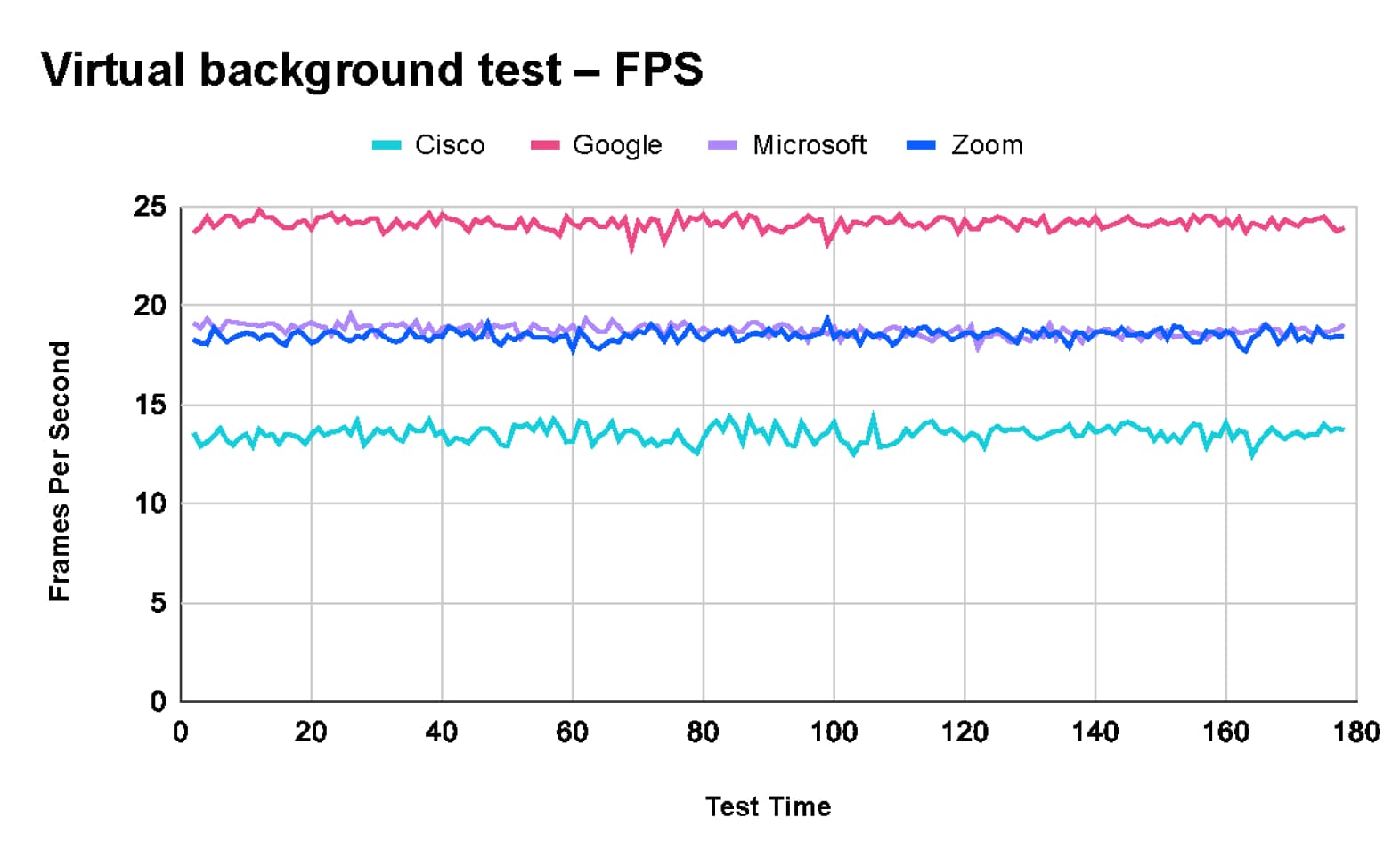

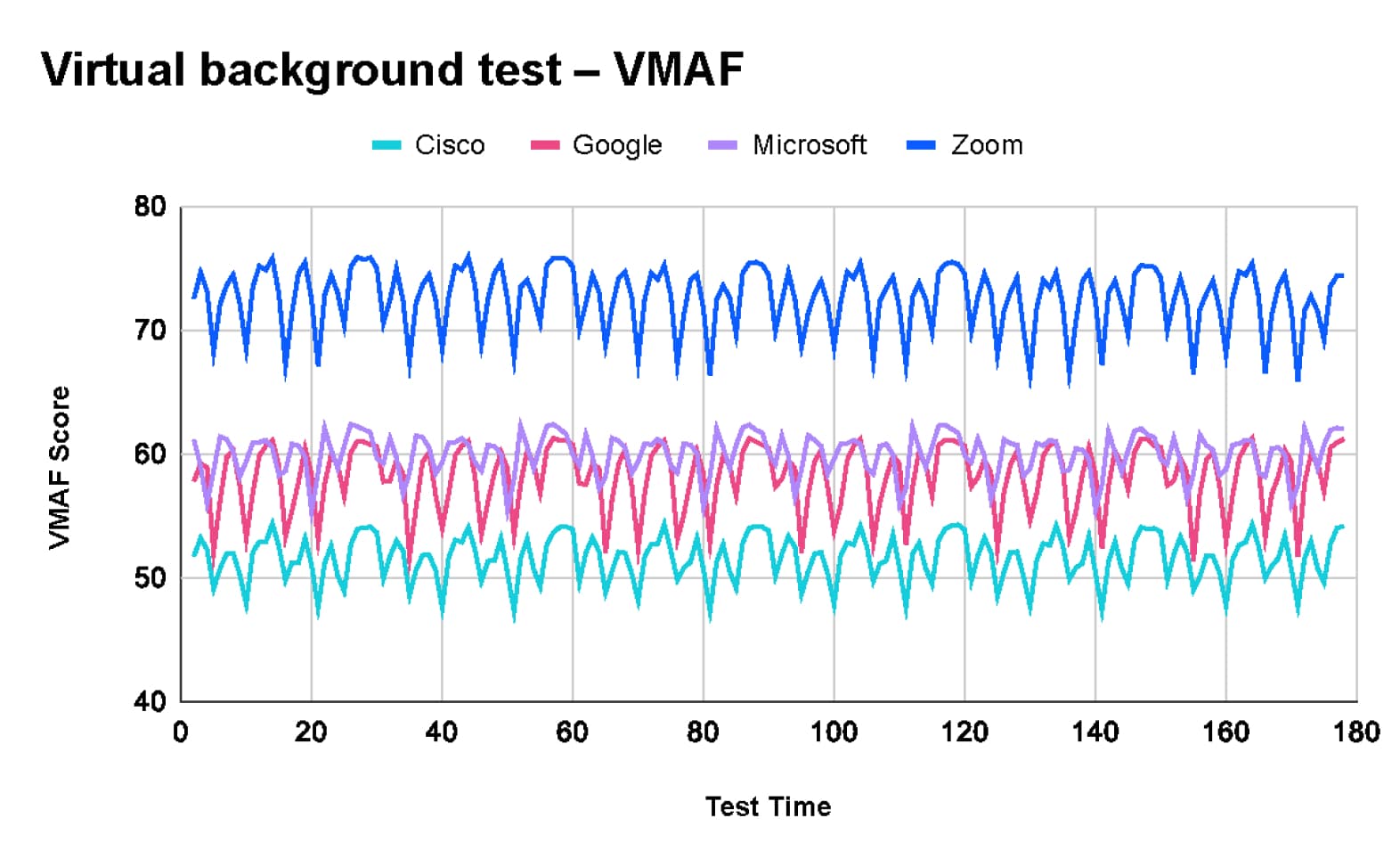

Secondo i risultati di TDL, Zoom ha offerto la migliore qualità dell’immagine. Alcuni client di videoconferenza danno priorità alla qualità video e altri alla frequenza di fotogrammi. Nel punteggio basato su VMAF:

- Zoom (73) con una frequenza di fotogrammi costante di 18 fps

- Microsoft team (60) con una frequenza di fotogrammi costante di 18 fps

- Google Meet (58) con una frequenza di fotogrammi elevata di 24 fps

- Cisco Webex (52) con una bassa frequenza di fotogrammi di 13 fps

Questi risultati sono coerenti con i test interni di Zoom sulla qualità degli sfondi virtuali condotti lo scorso anno, mostrati in questo video.

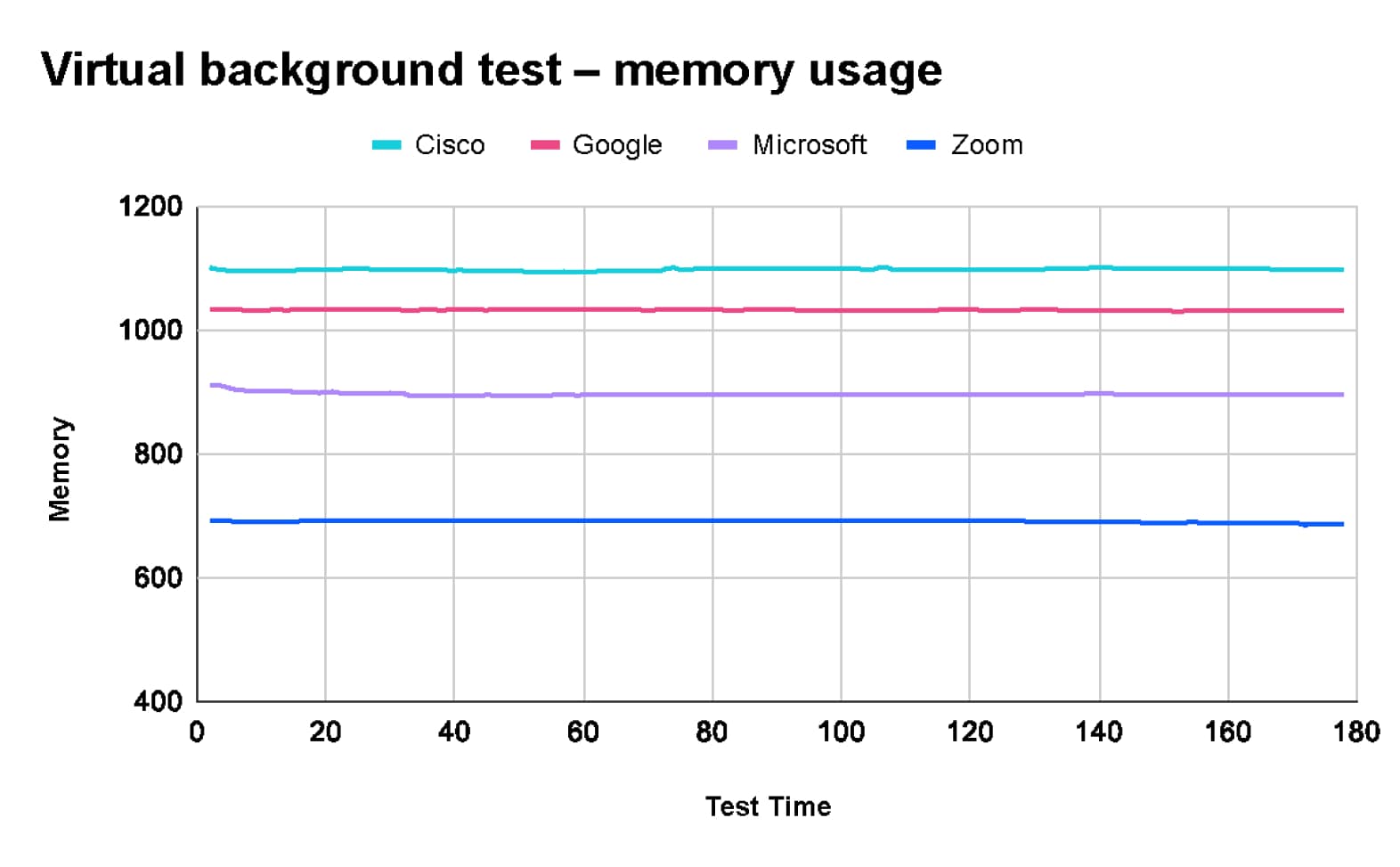

Inoltre, i test di TDL hanno rivelato che Zoom consuma meno risorse di CPU e memoria quando utilizza la funzionalità di sfondo virtuale.

I test approfonditi di TestDevLab evidenziano differenze significative nelle prestazioni tra Zoom, Microsoft Teams, Google Meet e Cisco Webex in diverse condizioni di rete e scenari di riunione.

- Zoom offre costantemente la migliore esperienza complessiva, eccellendo nella qualità video, nell’utilizzo delle risorse e nel mantenimento delle prestazioni anche in condizioni di sovraccarico della rete.

- Google Meet si distingue per l’efficienza della rete, mentre Cisco Webex offre una buona qualità audio.

- Le prestazioni leader di Zoom, in particolare per la qualità video elevata e l’uso efficiente delle risorse, la rendono la scelta migliore per riunioni virtuali efficaci e affidabili.