Rapport 2024 sur les performances audio et vidéo de Zoom

La qualité audio et vidéo est au cœur de l’expérience des réunions virtuelles. Lorsque l’une ou l’autre est médiocre, voire inexistante, l’expérience utilisateur s’en trouve dégradée, ce qui est source de frustration. Chez Zoom, nous cherchons constamment à savoir comment Zoom Meetings se positionne par rapport aux autres solutions de réunion. Nous avons donc chargé TestDevLab de comparer la qualité audio et vidéo dans diverses conditions et pour différents types d’appels pour les fournisseurs suivants :

- Zoom

- Microsoft Teams

- Google Meet

- Cisco Webex

Les conclusions présentées dans ce rapport reflètent les résultats des tests effectués par TestDevLab en avril 2024.

À propos de TestDevLab

TestDevLab (TDL) propose des services de test et d’assurance qualité pour les applications mobiles, Web et de bureau, ainsi que le développement d’outils de test personnalisés. L’entreprise est spécialisée dans les tests logiciels et l’assurance qualité, et développe des solutions personnalisées avancées pour les tests de sécurité, de batterie et d’utilisation des données des applications mobiles. Elle propose également des évaluations de la qualité audio et vidéo pour les applications VoIP ou de communication, des produits pour les API backend automatisées, ainsi que des tests de charge et de performances Web.

L’équipe TestDevLab est composée de plus de 500 ingénieurs hautement expérimentés qui se concentrent sur les tests et le développement logiciel. La majorité de leur personnel est certifié par l’International Software Testing Qualifications Board (ISTQB), ce qui leur confère un haut niveau d’expertise dans les tests logiciels conformément aux normes du secteur et à la qualité de service.

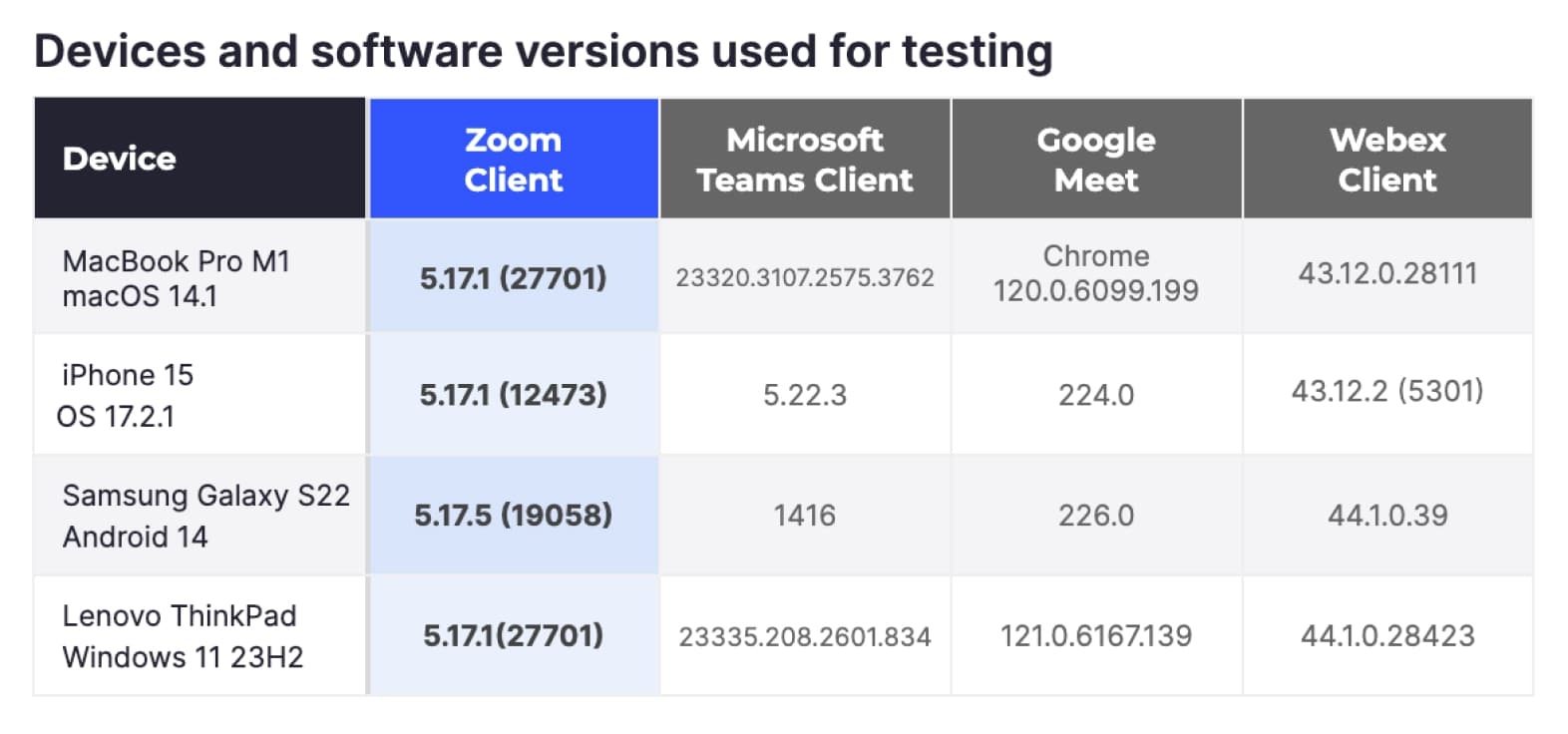

Afin de garantir l’équité des tests pour tous les fournisseurs, tous les tests ont été réalisés à l’aide des équipements et des comptes TestDevLab. De plus, les comptes individuels des fournisseurs ont été conservés dans leur configuration par défaut, à l’exception de l’activation d’une résolution maximale HD (1080p) pour les fournisseurs qui limitent par défaut la résolution vidéo.

Les scénarios de test comprenaient un appareil « récepteur », un appareil « émetteur » et des appareils supplémentaires qui jouaient le rôle de participants supplémentaires. Tous les appareils étaient connectés au même appel vidéo. En fonction du scénario de test, la configuration de l’appel et du réseau a été adaptée afin de reproduire les paramètres de test requis.

Appareils et versions logicielles utilisés pour les tests

Scénarios de test

Afin d’obtenir une vue d’ensemble de la qualité audio et vidéo dans Meetings, nous avons demandé à TDL de tester les scénarios de réunion les plus courants à l’aide d’équipements couramment utilisés.

Scénarios de réseau variables

Pour ces scénarios, nous avons voulu tester la manière dont les différentes plateformes réagissent dans diverses conditions réseau à l’aide de quelques plateformes informatiques courantes. Pour atteindre cet objectif, TDL a utilisé quatre équipements courants : des ordinateurs MacBook Pro, des ordinateurs Windows, des iPhone et des appareils Android. Nous avons configuré le type de réunion le plus courant avec trois participants, aucun contenu partagé et un paramètre d’affichage du présentateur/intervenant permettant d’optimiser la résolution vidéo.

Les scénarios réseau testés comprenaient :

- Réseau propre : aucune limitation réseau, utilisé comme référence.

- Réseau limité à 1 Mbps la bande passante réseau est limitée à 1 Mbps.

- Réseau limité à 500 Kbps : la bande passante réseau est limitée à 500 Kbps.

- Perte de paquets variable : les réunions ont commencé avec une perte de paquets de 10 %, qui est passée à 20 % après 1 minute, puis à 40 % après une minute supplémentaire.

- Latence variable : les réunions commencent sans limitation. Après 1 minute, une latence de 100 ms et une gigue de 30 ms sont introduites pendant 1 minute. Ensuite, la latence passe à 500 ms et la gigue à 90 ms.

- Récupération du réseau : les réunions ont commencé sans aucune restriction. Après 1 minute, un problème réseau a été simulé, limitant la bande passante à 1 Mbps, ajoutant 10 % de perte de poche et introduisant 100 ms de latence et 30 ms de gigue pendant 1 minute. Ensuite, le réseau est revenu à la normale.

- Réseau cellulaire 3G : appel vidéo effectué sur le réseau cellulaire 3G uniquement à partir d’appareils mobiles.

- Test de congestion du réseau : l’appel commence avec un réseau propre, puis, à différents intervalles, une courte rafale de données à haut débit est envoyée sur le réseau afin de simuler une bande passante encombrée.

Chaque appel a duré trois minutes et a été répété cinq fois. TDL a organisé 420 réunions avec tous les fournisseurs, toutes les variantes matérielles et toutes les conditions réseau.

Lorsque des restrictions étaient imposées à un appel, elles se limitaient à l’appareil testé agissant en tant que « récepteur ».

Scénarios de types d’appels variables

Pour ces scénarios, nous avons voulu tester les différents types d’appels et technologies utilisés par la plupart des utilisateurs. Le matériel utilisé se limitait à des ordinateurs MacBook Pro M1 et Windows. Les scénarios comprenaient des réunions de cinq et huit personnes organisées en mode galerie. TDL a testé des réunions avec uniquement des participants, des réunions avec partage de contenu et des réunions où les participants activaient des arrière-plans virtuels.

Dans tous les cas, le réseau est resté propre et sans restriction. Comme précédemment, chaque réunion a duré trois minutes et a été répétée cinq fois. Au total, TDL a organisé 240 réunions supplémentaires dans cette catégorie.

Mesures capturées

Afin d’obtenir une image complète de la qualité des réunions, nous avons demandé à TDL de recueillir des données dans quatre catégories principales liées à la qualité audio et vidéo, à l’utilisation du réseau et à l’utilisation des ressources. Les données ont été recueillies à chaque seconde de la réunion et enregistrées dans une base de données centralisée.

Qualité audio

- Score MOS : le score MOS (Mean Opinion Score) quantifie la qualité des appels en fonction des évaluations des utilisateurs, généralement sur une échelle de 1 (mauvais) à 5 (excellent), reflétant la clarté audio perçue et l’expérience globale.

- ViSQOL : ViSQOL (Virtual Speech Quality Objective Listener) est une mesure objective qui évalue la qualité des appels en comparant la similitude entre les signaux audio originaux et transmis à l’aide d’un modèle perceptuel.

- Décalage audio : le décalage audio mesure la latence entre la parole prononcée et sa réception par l’auditeur. Plus la valeur est faible, plus le décalage est important et plus la qualité de l’appel est élevée.

Qualité vidéo

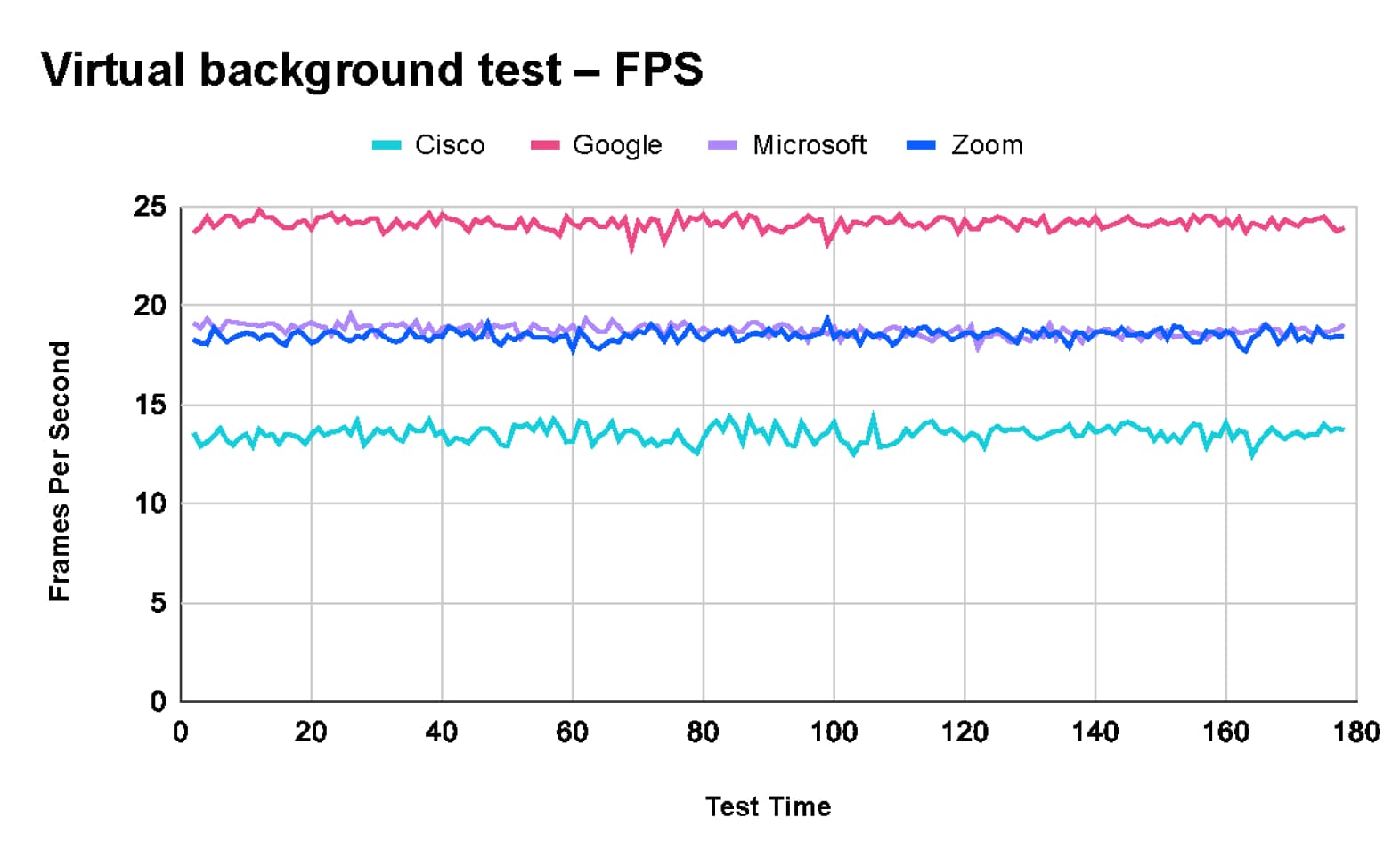

- Images par seconde (FPS) : le taux d’images par seconde (FPS) mesure le nombre d’images individuelles affichées par seconde dans une vidéo. Plus le FPS est élevé, plus le mouvement est fluide et la qualité vidéo améliorée.

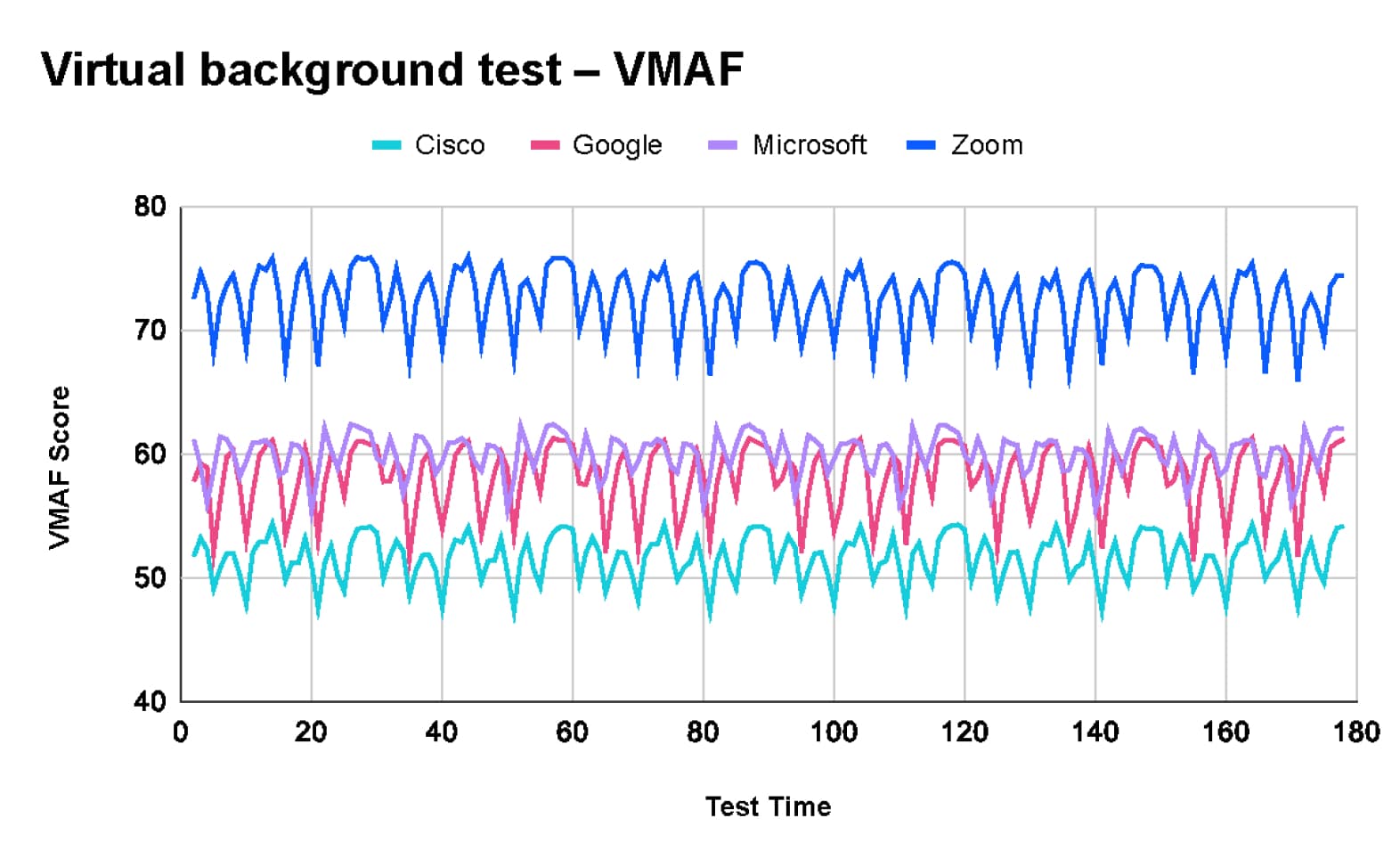

- VMAF : la VMAF (Video Multi-method Assessment Fusion) est une mesure de la qualité perçue des vidéos développée par Netflix qui combine plusieurs mesures de qualité afin de prédire la satisfaction des spectateurs et la qualité des vidéos.

- VQTDL : le VQTDL (Video Quality Temporal Dynamics Layer), développé par TDL, évalue la qualité vidéo en analysant les variations et la dynamique temporelles, capturant ainsi l’impact des changements au fil du temps sur l’expérience globale de visionnage.

- PSNR : Le rapport signal/bruit de crête (PSNR) est une mesure mathématique utilisée pour évaluer la qualité d’une vidéo en comparant les images originales et compressées. Plus la valeur est élevée, moins il y a de distorsion et meilleure est la qualité.

- Décalage vidéo : le décalage vidéo désigne le délai entre la capture vidéo en direct et son affichage sur l’écran distant. Plus le décalage est faible, plus l’expérience de réunion est proche du temps réel.

- Blocage vidéo : le blocage vidéo mesure la fréquence et la durée des pauses ou des blocages dans le flux vidéo. Moins il y a de blocages et plus ils sont courts, meilleure est la qualité vidéo.

Utilisation des ressources

- L’utilisation du processeur mesure le pourcentage de la capacité du processeur central (CPU) utilisé par le client de réunion.

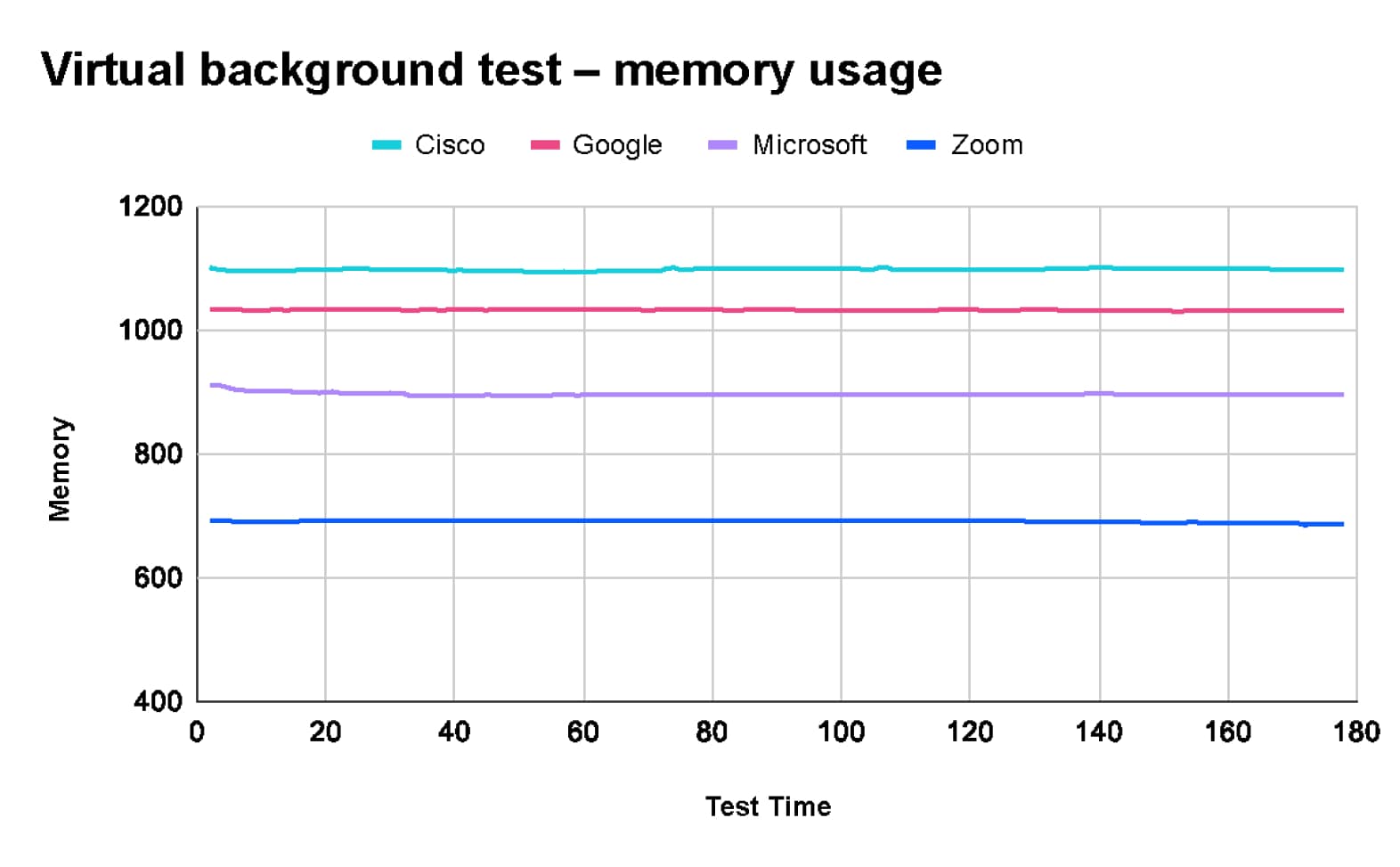

- L’utilisation de la mémoire fait référence à la quantité de mémoire vive (RAM) consommée par un client de réunion.

- L’utilisation du GPU mesure le pourcentage de la capacité du processeur graphique (GPU) utilisé par le client de réunion.

Utilisation du réseau

- Débit binaire de l’expéditeur : quantité de données réseau envoyées par chaque machine participant à la réunion

- Débit binaire du récepteur : quantité de données réseau reçues par chaque machine participant à la réunion

Certaines mesures ne peuvent pas être capturées sur toutes les plateformes. Par exemple, les mesures d’utilisation des ressources ne peuvent pas toutes être capturées sur les appareils mobiles. TDL optimise la capture des mesures dans chaque scénario d’appel.

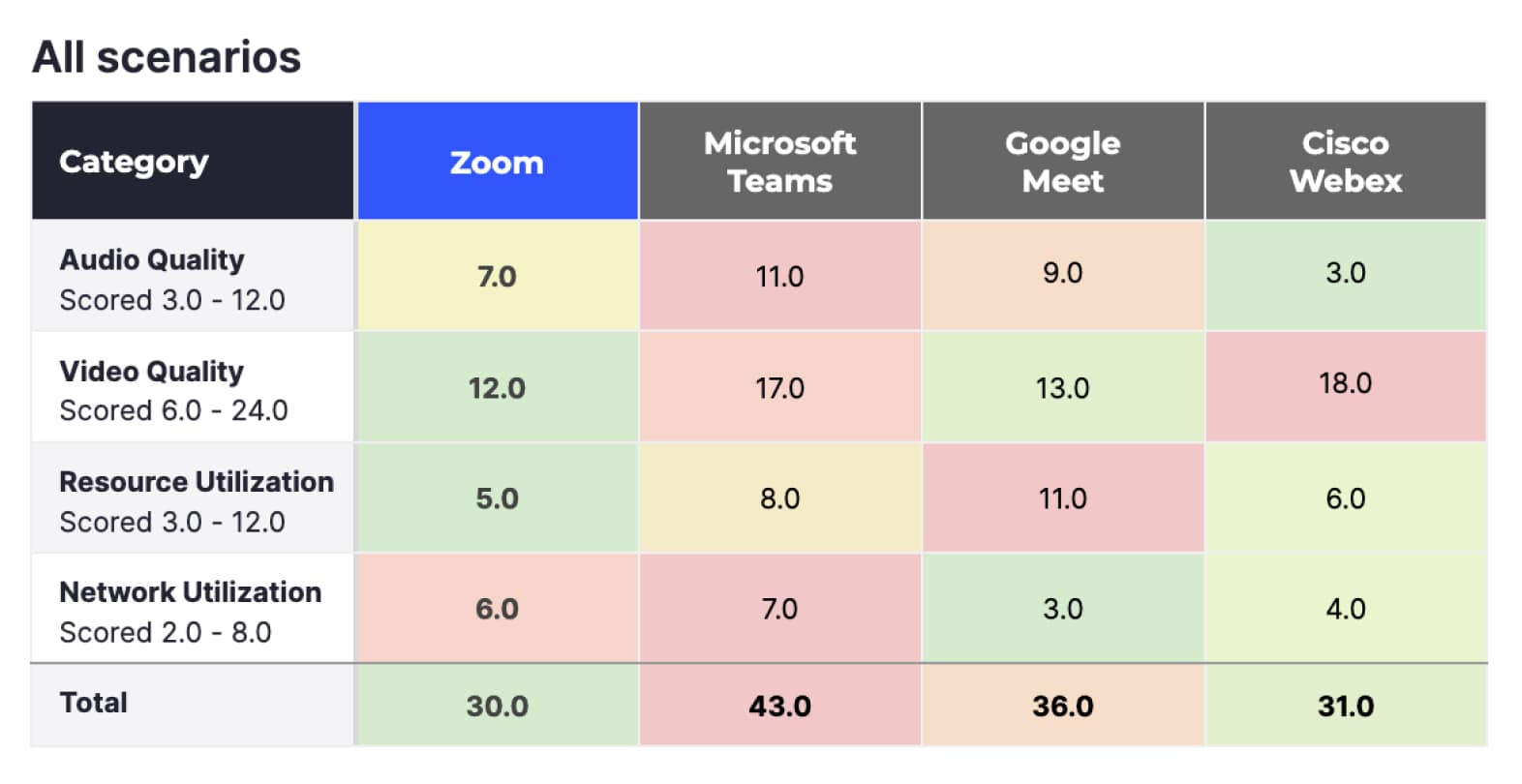

Afin de simplifier la présentation de la grande quantité d’informations recueillies par TDL, nous avons noté chacun des indicateurs ci-dessus sur une échelle de 1 à 4, où 1 correspond à la meilleure note et 4 à la moins bonne. Nous avons ensuite additionné les notes obtenues pour les indicateurs dans les quatre catégories. Les totaux les plus bas représentent les meilleures notes de qualité dans chaque catégorie.

Cette section examine les résultats de manière générale, en appliquant différents filtres afin de se concentrer sur différentes catégories d’appels. Plus loin, nous nous intéresserons à des scénarios d’appels individuels et fournirons des informations plus détaillées sur le comportement des différentes plateformes dans ces scénarios. Pour plus d’informations, consultez la section « Résultats détaillés ».

Les résultats ci-dessus incluent les scores des 660 réunions, tous appareils et scénarios réseau confondus :

- Si l’on considère tous les critères, Zoom obtient le meilleur score (30), suivi de près par Cisco Webex (31). Google Meet (36) et Microsoft Teams (43) obtiennent des scores moins bons en comparaison.

- Zoom a obtenu les meilleurs résultats en matière de qualité vidéo et d’utilisation des ressources (respectivement 12 et 5). Zoom a été plus performant dans ce test, car Meetings décharge la plupart des fonctions de traitement vidéo du CPU vers le GPU, laissant ainsi le processeur libre d’exécuter d’autres applications sur l’appareil.

- En termes d’utilisation du réseau, Google Meet (3) a obtenu le meilleur score.

- En termes de qualité audio, Cisco Webex a obtenu le meilleur score (3), suivi de Zoom (7). Google Meet (9) et Microsoft Teams (11) ont obtenu des scores moins bons en comparaison.

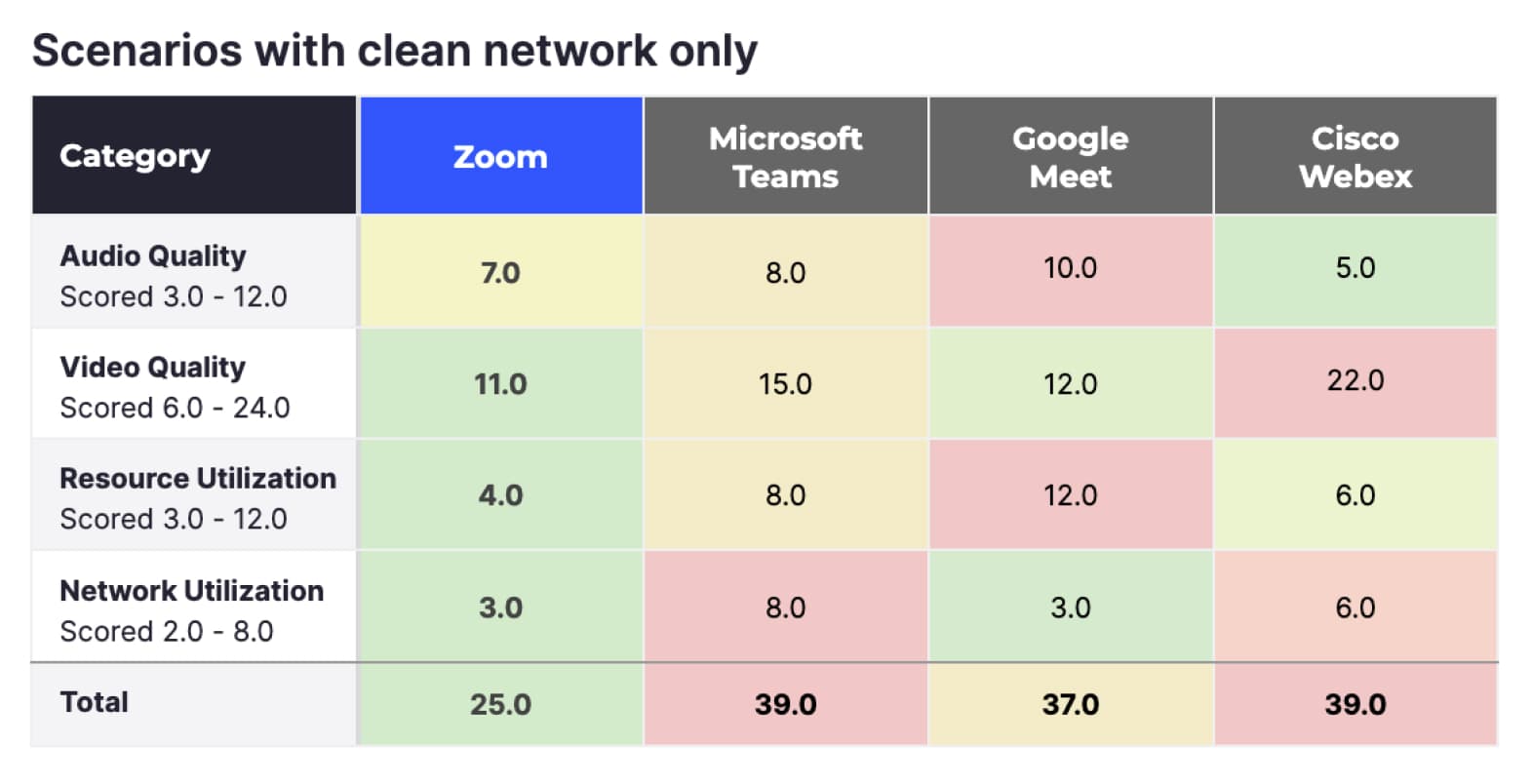

Scénarios avec réseau propre uniquement

Le score global ci-dessus représente l’ensemble des tests TDL, mais en réalité, la plupart des utilisateurs habituels ne rencontreront pas la plupart des limitations réseau simulées par TDL. Les résultats ci-dessous filtrent tous les tests qui présentaient des limitations réseau, ne conservant que les tests réseau sans limitation.

En ce qui concerne les réunions sur un réseau propre, Zoom (25) obtient un score encore meilleur, Google Meet (37) arrive en deuxième position, tandis que Microsoft Teams (39) et Cisco Webex (39) occupent les dernières places.

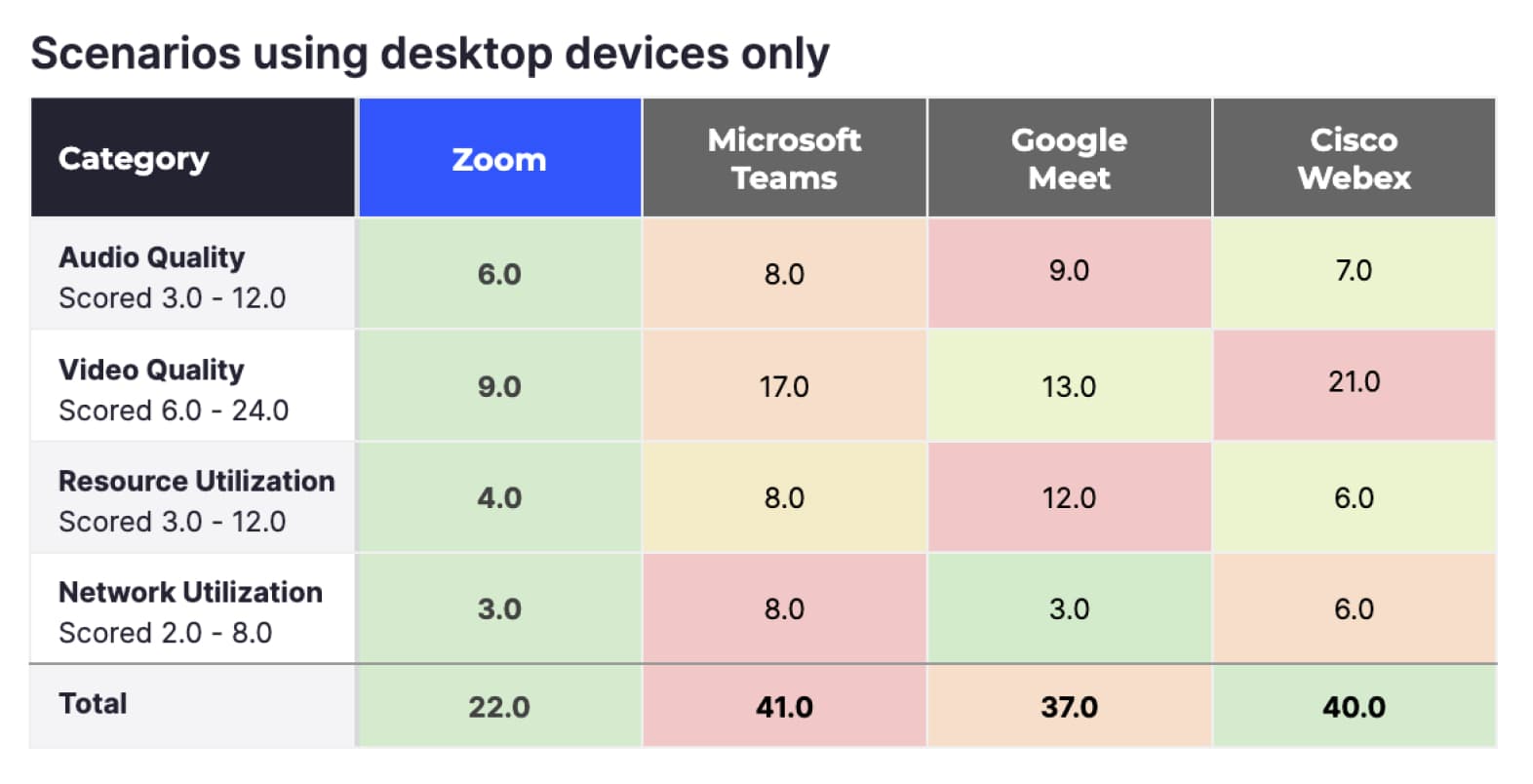

Scénarios utilisant uniquement des appareils de bureau

Bien que de nombreuses personnes utilisent des appareils mobiles pour se connecter aux réunions, environ 66 % des participants Zoom se connectent en moyenne à partir d’ordinateurs de bureau (selon les statistiques internes de Zoom). Lorsque l’on filtre les données pour ne conserver que les ordinateurs de bureau et les réunions sans problèmes de réseau, l’avance de Zoom augmente encore davantage, et l’entreprise arrive en tête pour les quatre indicateurs.

Synthèse

Zoom surpasse les autres services de réunion testés dans toutes les catégories évaluées par TDL dans des conditions idéales et avec les appareils les plus couramment utilisés. Comme les conditions ne sont pas toujours idéales, il est important d’évaluer les situations dans lesquelles les utilisateurs peuvent rencontrer des problèmes de réseau.

Les fournisseurs peuvent s’adapter automatiquement aux conditions changeantes du réseau afin de maintenir une qualité audio et vidéo optimale. Le protocole de chaque fournisseur s’adapte différemment, ce qui peut modifier la résolution vidéo, la qualité de compression, le nombre d’images par seconde et d’autres facteurs. L’expérience utilisateur globale lors d’un appel vidéo dépend de la capacité du fournisseur à optimiser ces paramètres en fonction des fluctuations des conditions du réseau.

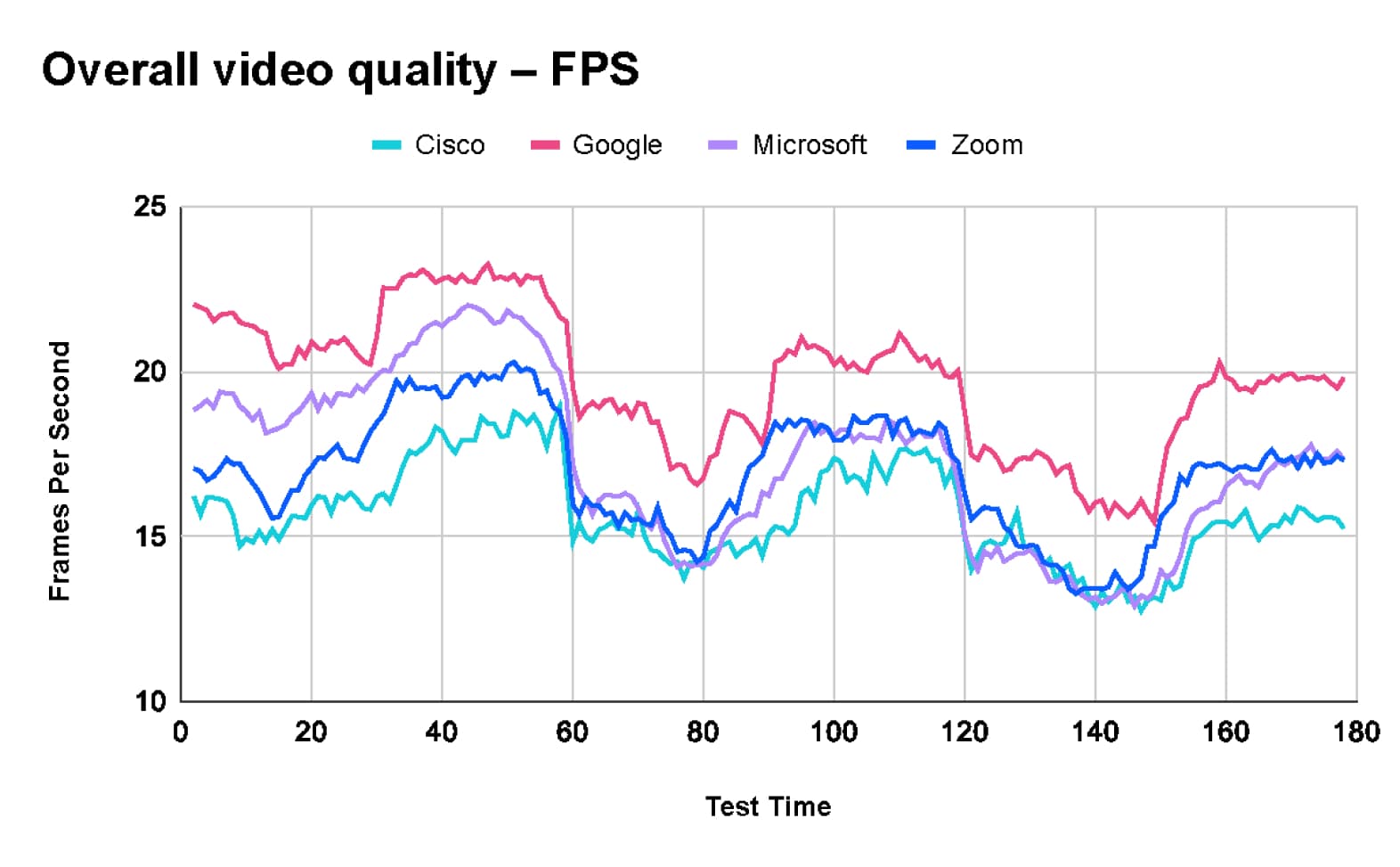

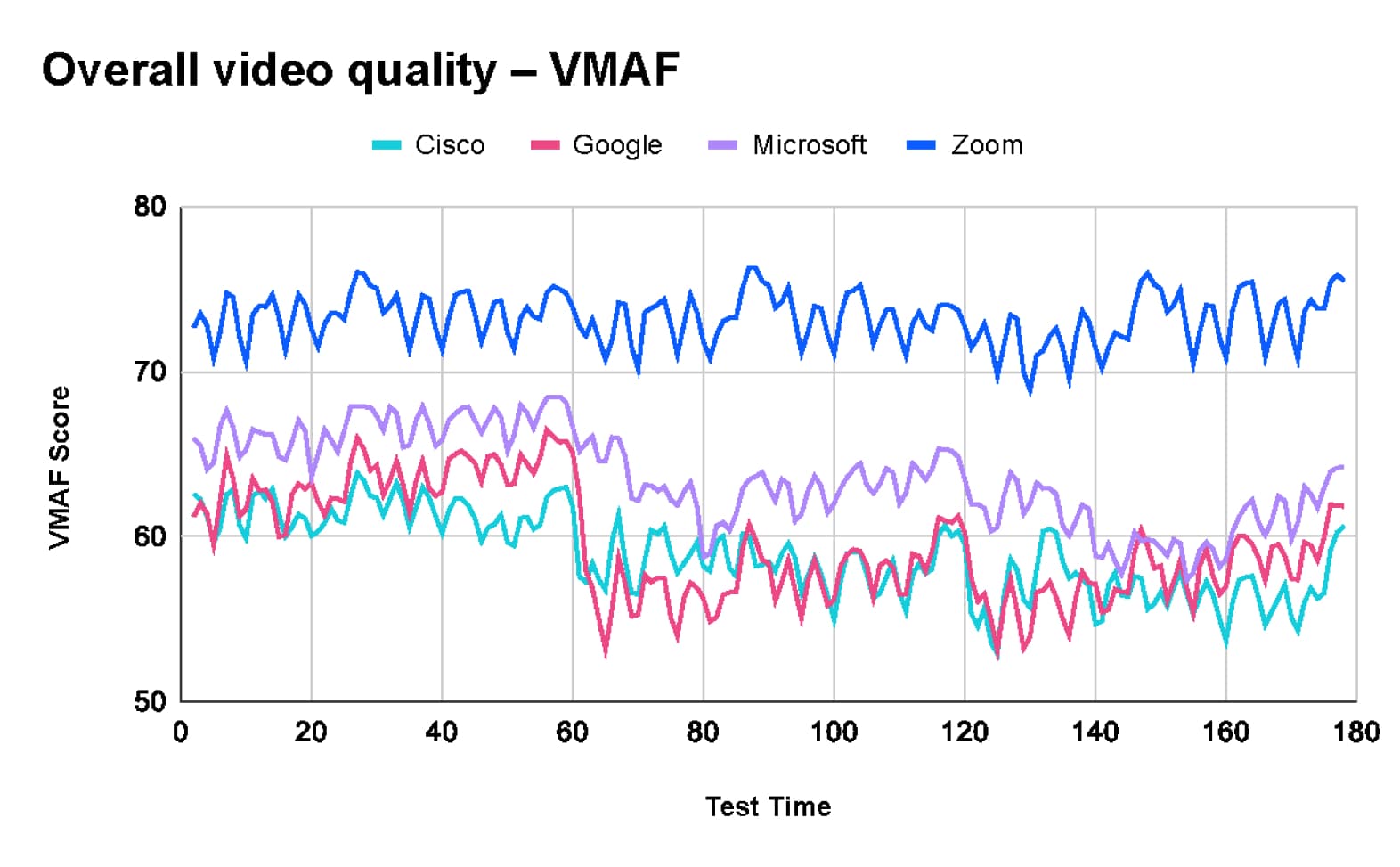

TestDevLab a recueilli plusieurs indicateurs afin de mesurer l’expérience utilisateur globale lors d’un appel. Les deux indicateurs les plus significatifs sont le VMAF, qui mesure la qualité perçue de l’image, et le nombre d’images par seconde (FPS), qui indique la fluidité de la vidéo.

Qualité vidéo globale pour tous les tests

Après avoir analysé les résultats combinés de 660 tests, TDL a constaté que Google Meet offre la fréquence d’images moyenne la plus élevée, avec 20 images par seconde (fps). En comparaison, Microsoft Teams et Zoom affichent tous deux une moyenne de 17 fps, tandis que Webex affiche une moyenne de 16 fps.

Cependant, la fréquence d’images plus élevée de Google Meet s’accompagne d’une perte de qualité vidéo. Selon le classement VMAF (Video Multimethod Assessment Fusion), Zoom arrive en tête en termes de qualité avec une note moyenne de 73,2. Microsoft Teams suit avec une note de 63,5, Google Meet obtient 59,5 et Webex affiche une note moyenne de 58,9.

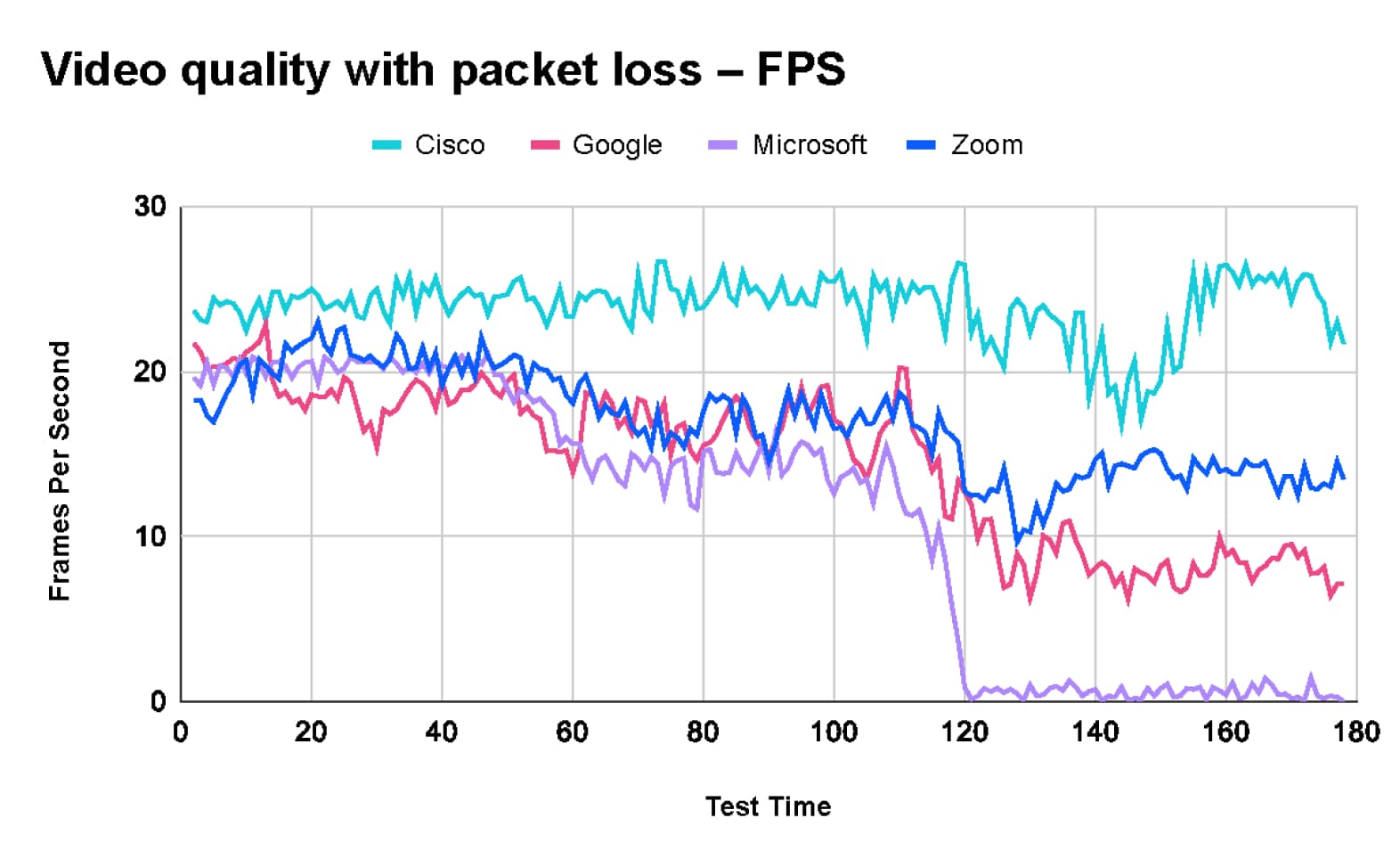

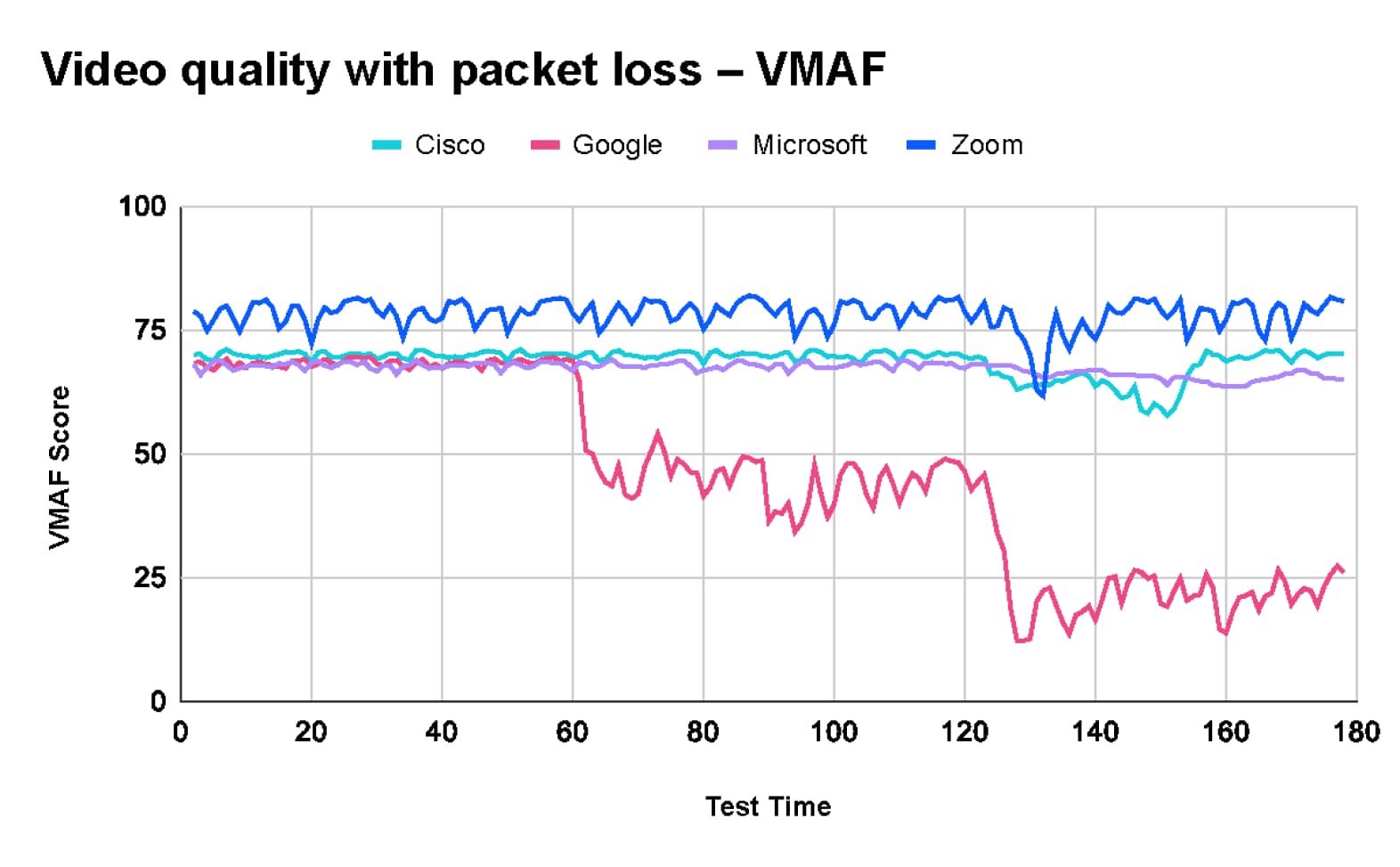

Qualité vidéo en cas de perte de paquets

Le test de perte de paquets réalisé par TestDevLab comprenait trois étapes.

- L’appel a commencé avec une perte de paquets de 10 %.

- Après 60 secondes, la perte de paquets a été augmentée à 20 %.

- Au bout de 60 secondes supplémentaires, la perte de paquets a encore augmenté pour atteindre 40 %.

Comme le montrent les graphiques ci-dessous :

- Zoom maintient une qualité vidéo optimale avec un score VMAF d’environ 80, mais la fréquence d’images passe d’environ 20 fps à 13 fps.

- Webex maintient une qualité vidéo et une fréquence d’images relativement stables tout au long du test.

- Google Meet subit une baisse significative de son score VMAF, qui passe de 70 à 20 avec une perte de paquets de 40 %, et le taux de rafraîchissement diminue d’environ 15 fps à 8 fps à la fin du test.

- Microsoft Teams maintient la qualité d’image avec un score VMAF de 70. Cependant, la fréquence d’images chute considérablement, passant d’environ 20 fps au début du test à 2 fps lorsque 40 % de perte de paquets est introduite, ce qui entraîne un gel de la vidéo.

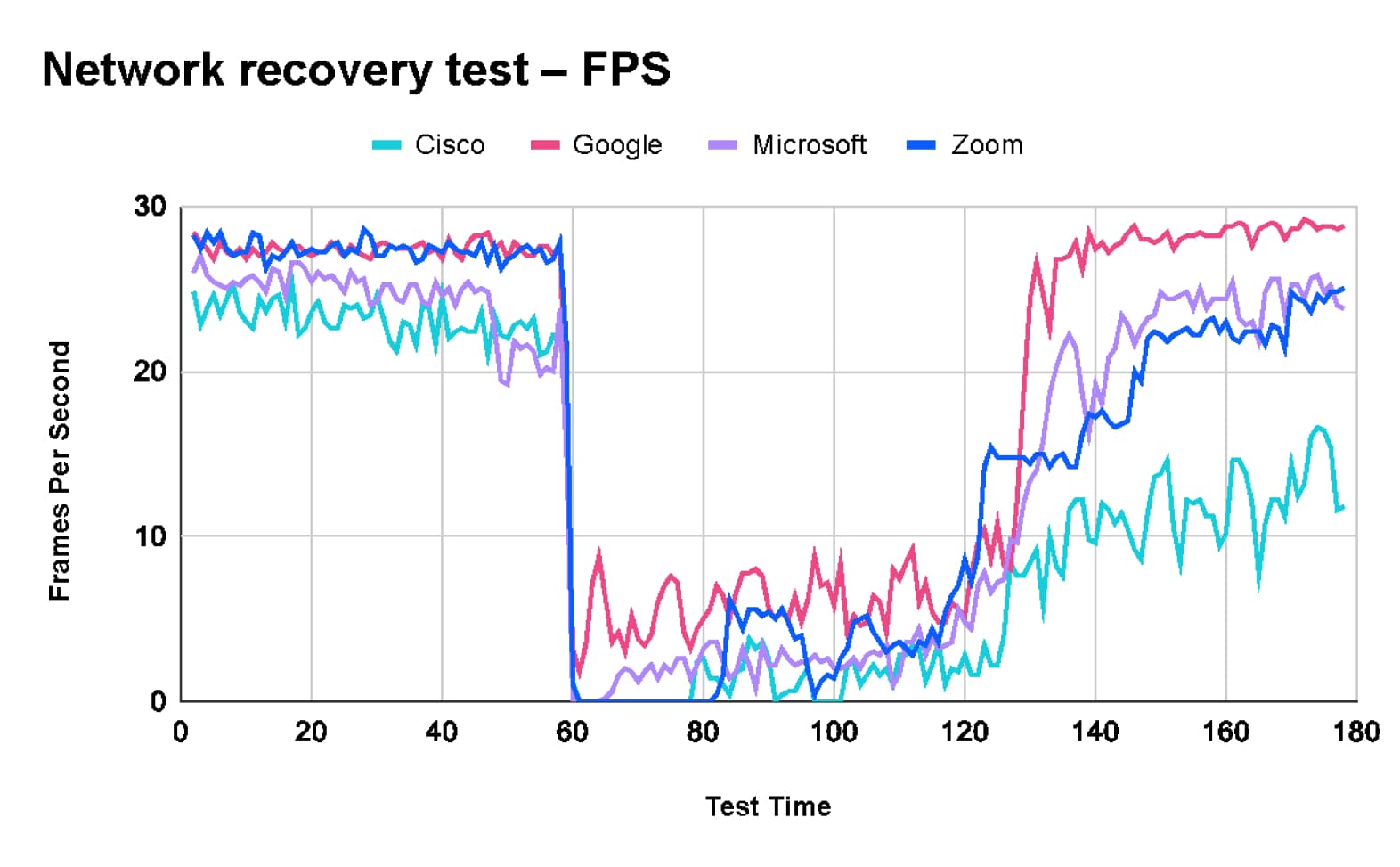

Test de récupération du réseau

Dans le test de récupération du réseau, TDL a commencé le test avec un réseau propre.

- À la 60e seconde, une série de problèmes réseau ont été introduits, notamment une limite de 1 Mbps, une perte de paquets de 10 %, un délai de 100 ms et une gigue de 30 ms.

- Après 60 secondes de « mauvaise connexion », les restrictions ont été levées et le réseau est revenu à son état initial.

Ce test a été conçu pour évaluer le comportement des plateformes testées lorsqu’un problème temporaire survient sur le réseau et la capacité de chaque plateforme à se rétablir lorsque le problème n’existe plus.

Les résultats des tests montrent que, bien que Zoom maintienne une vidéo de haute qualité, il lui faut environ 10 secondes pour réajuster ses paramètres de codec aux nouvelles conditions du réseau, ce qui se traduit par un taux de rafraîchissement très faible pendant plusieurs secondes. En termes de temps de récupération, Zoom se situe dans la moyenne, entre Webex, qui affiche un temps de récupération très faible, et Teams et Google, qui offrent une récupération rapide.

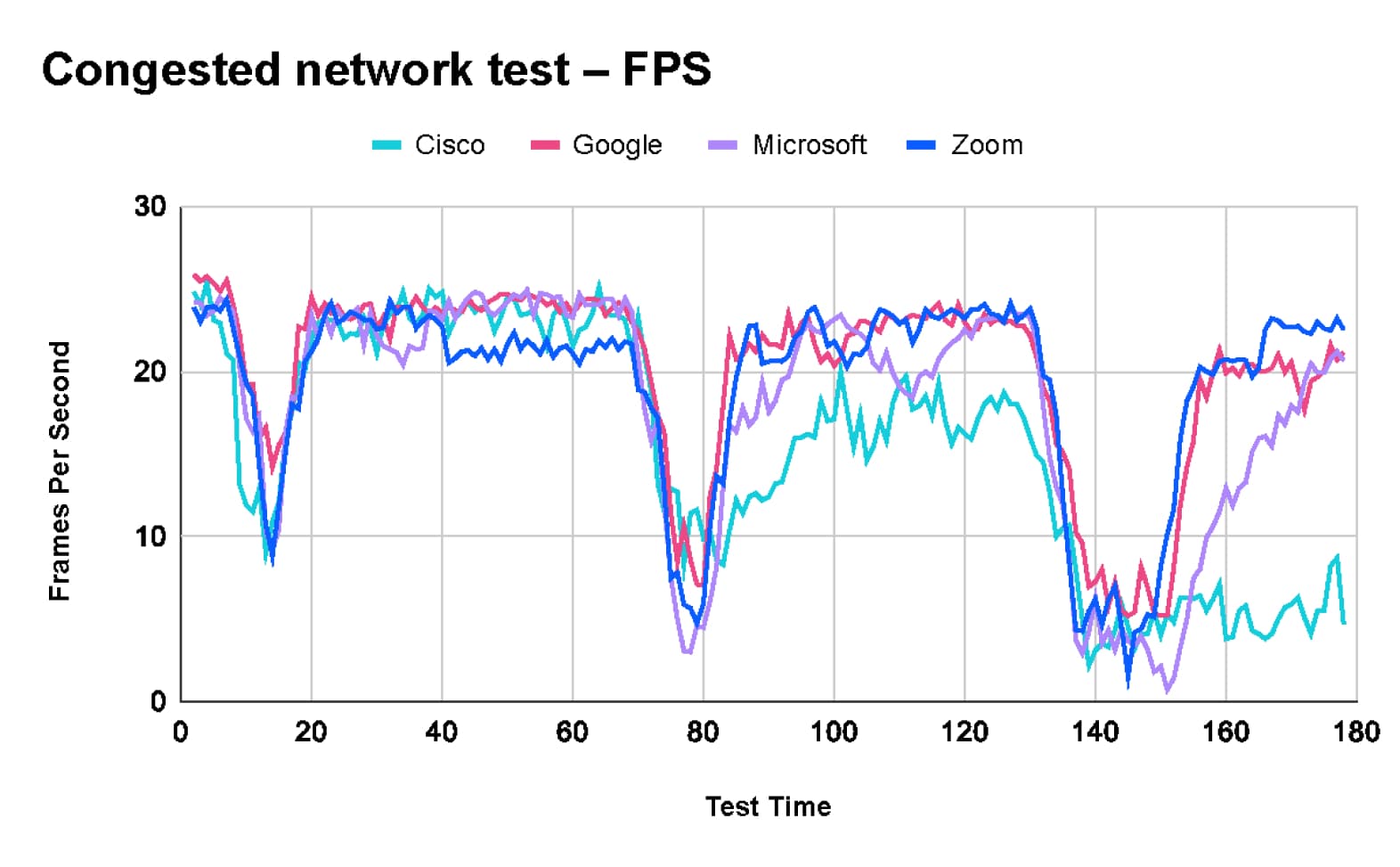

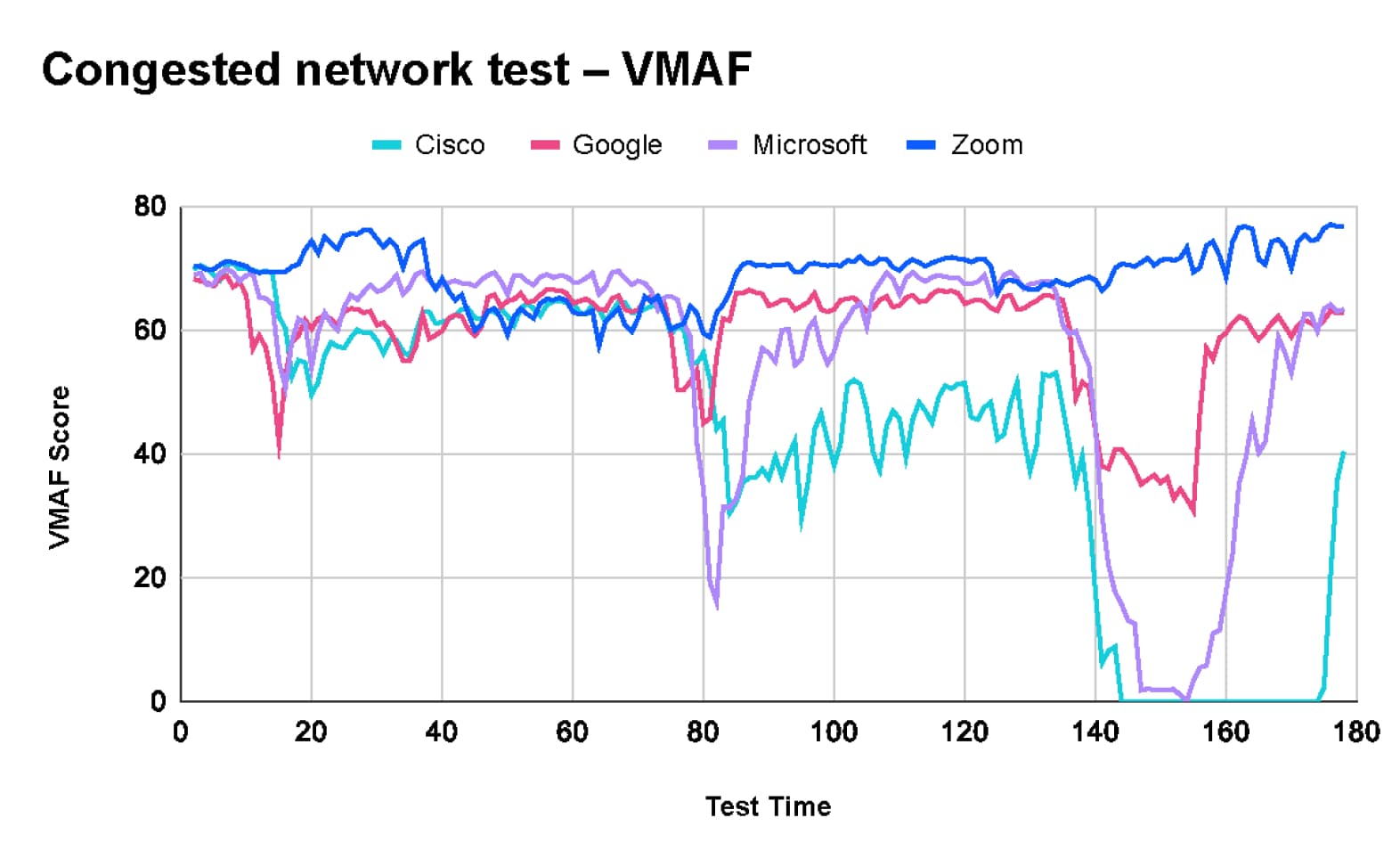

Test de réseau encombré

L’objectif du test de réseau encombré était d’évaluer le comportement des plateformes testées sous différentes durées de congestion du réseau et leur capacité à maintenir leurs performances sur des réseaux présentant des pics de trafic intermittents.

- Le script de test alternait entre des périodes d’inactivité et des pics de trafic à 10 Mbps (sur une ligne à 10 Mbps), avec des durées de congestion croissantes et des pauses de durée variable entre les deux.

Les résultats du test montrent que Zoom maintient la qualité d’image tout au long du test, tout en sacrifiant la fréquence d’images et le décalage vidéo pour s’adapter aux conditions changeantes du réseau. Il est à noter que Webex a complètement abandonné la vidéo à la fin du test.

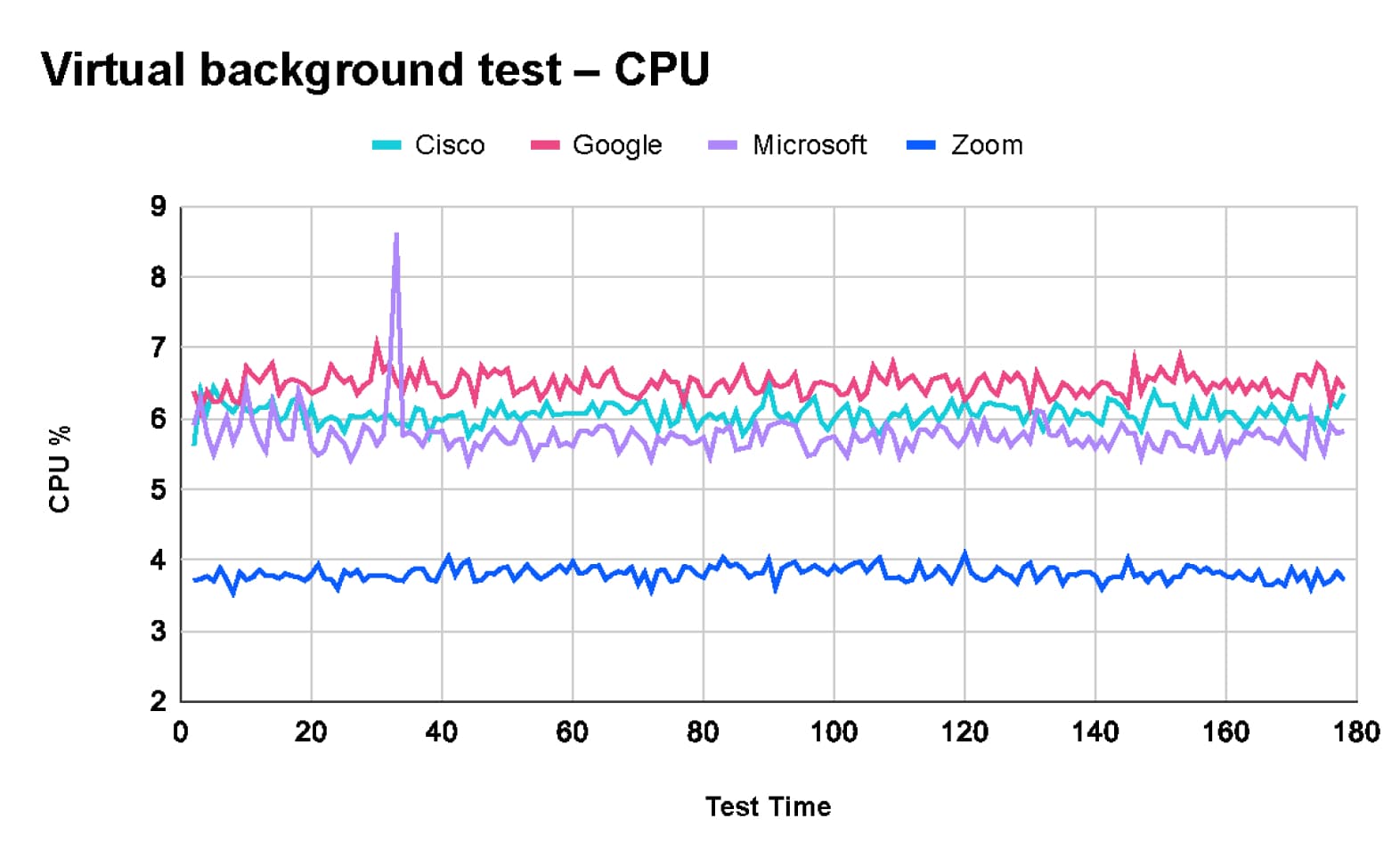

Test de qualité avec arrière-plan virtuel

Dans nos scénarios de test, nous avons chargé TDL d’évaluer l’expérience utilisateur de la fonctionnalité d’arrière-plan virtuel. Cette fonctionnalité remplace l’arrière-plan réel de l’utilisateur par une image ou une vidéo, ce qui nécessite un traitement important pour générer une image composite de haute qualité.

Selon les résultats de TDL, Zoom offre la meilleure qualité d’image. Certains logiciels de réunion privilégient la qualité vidéo, d’autres la fréquence d’images. Selon le classement VMAF :

- Zoom (73) avec une fréquence d’images stable de 18 fps

- Microsoft Teams (60) avec une fréquence d’images stable de 18 fps

- Google Meet (58) avec une fréquence d’images élevée de 24 fps

- Cisco Webex (52) avec une faible fréquence d’images de 13 fps

Ces résultats concordent avec les tests de qualité des arrière-plans virtuels internes réalisés par Zoom l’année dernière, qui sont présentés dans cette vidéo.

En outre, les tests effectués par TDL ont révélé que Zoom utilise le moins de ressources CPU et mémoire lorsqu’il utilise la fonctionnalité d’arrière-plan virtuel.

Les tests approfondis réalisés par TDL mettent en évidence des différences significatives en termes de performances entre Zoom, Microsoft Teams, Google Meet et Cisco Webex dans diverses conditions réseau et différents scénarios de réunion.

- Zoom offre systématiquement la meilleure expérience globale et excelle sur le plan de la qualité vidéo, de la consommation de ressources et de la gestion des performances, même lorsque le réseau a du mal à suivre.

- Google Meet se distingue par ses performances réseau, tandis que Cisco Webex offre une bonne qualité audio.

- Les performances exceptionnelles de Zoom, notamment en matière de vidéo haute qualité et d’utilisation efficace des ressources, en font le choix idéal pour des réunions virtuelles robustes et fiables.