Découvrez Zoom AI Companion, votre nouvel assistant IA,

Dopez votre productivité et renforcez la collaboration au sein de votre équipe grâce à Zoom AI Companion, inclus sans frais supplémentaires dans les forfaits payants Zoom éligibles.

Xuedong Huang, CTO de Zoom, explique comment les petits modèles de langage (SLM) véhiculent notre vision : celle d’agents d’IA qui travaillent ensemble dans le cadre d’une approche fédérée afin d’améliorer vos tâches quotidiennes.

Mis à jour le February 25, 2025

Publié le February 19, 2025

Xuedong Huang est le directeur informatique. Avant de rejoindre Zoom, il a occupé chez Microsoft le poste de directeur informatique et de Technical Fellow d’Azure AI. Son parcours dans le monde de l’IA est brillant : il a créé le groupe de technologie vocale de Microsoft en 1993 et organisé la mise en place, au sein de l’équipe d’IA de Microsoft, des premières mesures en faveur de la parité dans les domaines de la reconnaissance vocale, de la traduction automatique, de la compréhension du langage naturel et de la vision par ordinateur. Membre de l’IEEE et de l’ACM, il est également membre élu de la National Academy of Engineering et de l’American Academy of Arts and Sciences.

Xuedong Huang a obtenu un doctorat en génie électrique à l’université d’Édimbourg en 1989 (financé par l’ORS britannique et une bourse de l’université d’Édimbourg), une maîtrise en informatique à l’université Tsinghua en 1984 et une licence en informatique à l’université du Hunan en 1982.

Chez Zoom, nous restons concentrés sur l’innovation, qui nous pousse à explorer sans relâche la transformation axée sur l’IA grâce à Zoom AI Companion. L’année dernière, j’ai expliqué comment notre approche fédérée permettait d’obtenir des résultats d’une grande qualité et comment l’attention particulière que nous portons à la qualité de la reconnaissance vocale créait une meilleure base pour nos autres fonctionnalités d’IA. Alors que l’intelligence artificielle continue de s’améliorer, nous accélérons l’adoption de l’IA agentique.

Jusqu’à présent, l’intelligence artificielle s’est appuyée sur de grands modèles de langage (LLM) pour répondre aux demandes des utilisateurs et donner des réponses générées. Les possibilités sont toutefois bien plus nombreuses si l’on considère la manière dont les SLM peuvent permettre de personnaliser les agents d’intelligence artificielle. Nous développons AI Companion pour permettre à l’IA agentique de gérer à votre place une série d’actions en plusieurs étapes.

Si l’on envisage l’IA comme un groupe d’agents plutôt que comme des compétences et des réponses autonomes, cela signifie qu’elle ne se contente pas de saisir des invites pour obtenir des résultats simples, mais qu’elle doit être un prolongement de nous-mêmes et de nos objectifs. Pour ce faire, nos agents d’IA sont dotés des caractéristiques suivantes :

Nous sommes ravis d’annoncer une étape importante dans ce voyage visant à faire de ces agents d’IA une réalité : le petit modèle de langage (SLM) que nous venons de développer a atteint des performances de pointe dans la catégorie des 2 milliards de paramètres au classement des benchmarks publics. Grâce à une personnalisation via le futur AI Studio de Zoom, nous concevons nos SLM de façon à ce qu’ils se rapprochent de la qualité du LLM leader du secteur dans des charges de travail spécialisées. Cela ouvrira la voie à AI Companion, qui pourra réaliser des tâches complexes d’IA agentique grâce à plusieurs agents d’IA travaillant ensemble avec une rentabilité inégalée.

Dans l’approche fédérée de l’IA proposée par Zoom, au lieu de dépendre d’un seul grand modèle complet, nous préconisons l’orchestration de plusieurs modèles personnalisés. Les SLM de Zoom sont conçus pour améliorer cette approche en l’optimisant pour des tâches spécifiques. En répartissant les charges de travail sur des SLM personnalisés avec les agents correspondants, tout en exploitant les LLM de premier plan, nous visons à en tirer plusieurs avantages importants :

Voyons ce que signifie cette avancée et comment elle se situe exactement par rapport aux principaux modèles.

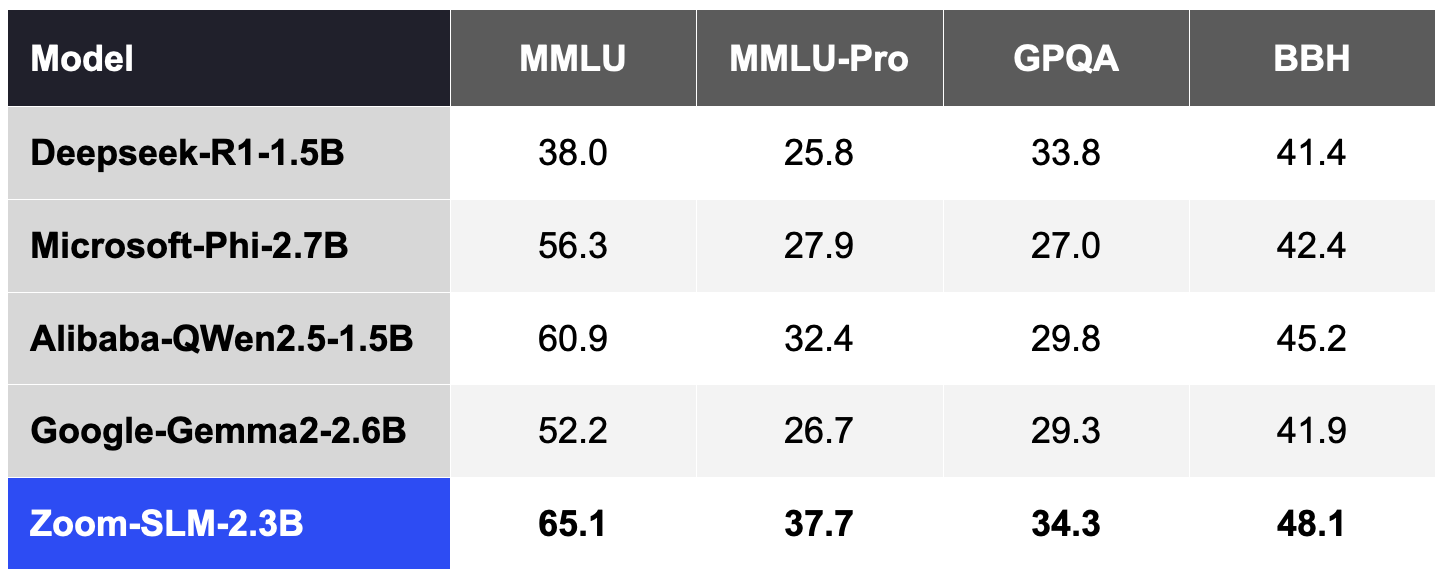

Pour créer le SLM de Zoom, nous avons utilisé 6 000 milliards de jetons de données multilingues et 256 processeurs graphiques Nvidia H100. L’ensemble du cycle de formation a duré de bout en bout environ 30 jours. Les tableaux suivants décrivent comment la capacité SLM de Zoom se situe par rapport à d’autres modèles pour plusieurs benchmarks publics selon nos tests internes :

Suivant une pratique répandue dans la communauté, nous avons évalué la précision de ces benchmarks à l’aide de l’outil Lighteval, qui a fourni 5 exemples sur MMLU et MMLU-Pro, 2 exemples sur GPQA et 3 exemples sur BBH.

Tableau 1. SLM Zoom comparé aux autres SLM de la catégorie 2B (les scores les plus élevés sont les meilleurs).

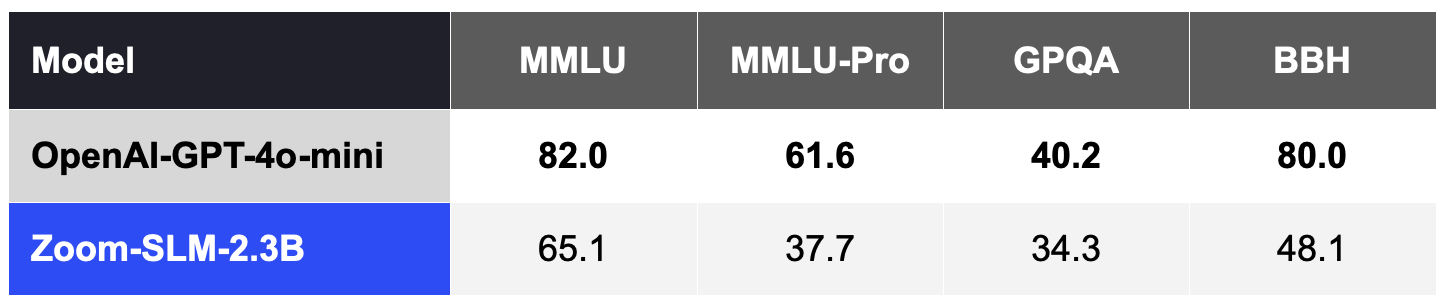

En général, les SLM sont moins compétitifs dans ces mesures de qualité que les principaux LLM, tels que le GPT-4o-mini d’OpenAI, sans adaptation à un domaine ou une tâche spécifique, comme le montre le tableau 2.

Tableau 2. Le SLM Zoom, sans personnalisation, est moins compétitif que les LLM au-delà de la catégorie 2B, tels que le GPT-4o-mini d’OpenAI.

Cependant, le résultat le plus intéressant est que ces SLM peuvent offrir des capacités exceptionnelles lorsqu’ils sont adaptés à une tâche spécialisée. Grâce à la personnalisation avec l’AI Studio de Zoom, nous espérons réduire efficacement l’écart de qualité par rapport aux LLM plus coûteux. Les SLM personnalisés peuvent agir en tant qu’agents spécialisés pour accomplir des tâches clés dans l’orchestration avec les LLM, en privilégiant l’amélioration de la précision, de la rapidité et de la rentabilité pour chaque agent d’IA.

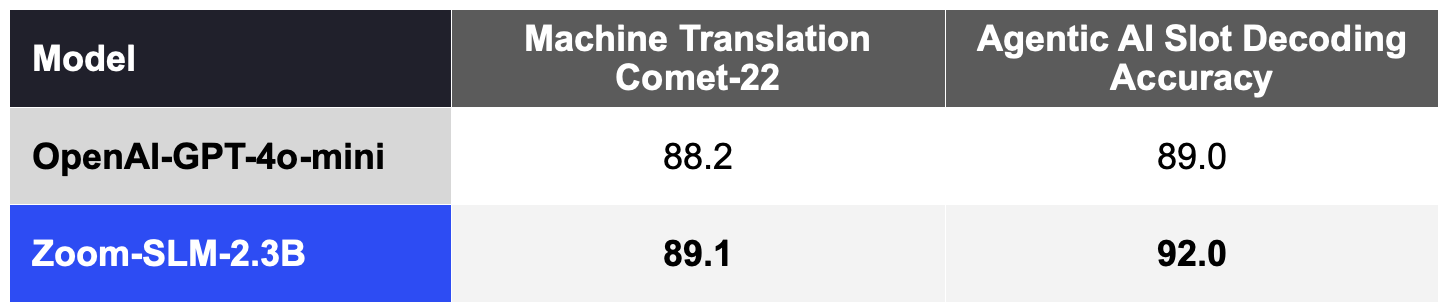

Les SLM personnalisés peuvent exceller dans des tâches telles que la traduction automatique. En adaptant le SLM avec 11,5 milliards de jetons (dont des données synthétiques) conçus pour la traduction automatique, nous avons considérablement amélioré les mesures de qualité COMET-22 largement adoptées pour 14 paires de langues, parmi lesquelles des langues majeures telles que le chinois, l’anglais, le français, le japonais, le portugais et l’espagnol, comme le montre le tableau 3.

Nos SLM peuvent également être personnalisés pour prendre en charge le benchmark d’IA agentique d’AI Companion pour le décodage des créneaux, qui mesure la manière dont le modèle interprète les commandes de l’utilisateur lors de l’exécution d’une action. Avec 2 milliards de jetons synthétiques pour les données du domaine de l’IA agentique, le SLM personnalisé surpasse également le GPT-4o-mini, comme le montre le tableau 3.

Cette combinaison d’efficacité et d’adaptabilité est conçue pour permettre à Zoom de proposer sa traduction automatique nettement améliorée à ses clients du monde entier et pour aider Zoom AI Studio à personnaliser des charges de travail spécifiques à l’IA agentique.

Tableau 3. SLM Zoom personnalisé comparé à GPT-4o-mini d’OpenAI dans les charges de travail spécialisées (les scores les plus élevés sont les meilleurs).

Ces SLM personnalisés constitueront la colonne vertébrale de nos agents d’IA, fonctionnant de manière plus efficace et offrant des résultats comparables à ceux des LLM plus coûteux que les gens utilisent actuellement. Grâce à notre IA fédérée, ces agents d’IA et ces compétences contribueront à une efficacité, un coût et une précision inégalés.

Nous sommes fiers de nos progrès, et ce n’est que le début. Notre vision ? Équiper chaque organisation d’agents d’IA offrant des solutions rentables et hautement performantes. Grâce aux capacités supplémentaires des agents d’IA et des SLM, AI Companion vous accompagne dans la création d’un environnement de travail où vous pouvez accomplir davantage et donner le meilleur de vous-même.