Bericht zur Video- und Audio-Performance von Zoom 2024

Audio- und Videoqualität sind entscheidend für ein gelungenes virtuelles Meeting. Wenn eines von beiden mangelhaft ist oder gar nicht funktioniert, leidet die Nutzererfahrung und führt zu Frustration. Wir bei Zoom möchten daher stets wissen, wie Zoom Meetings im Vergleich zu anderen Meeting-Lösungen abschneidet. Aus diesem Grund haben wir TestDevLab beauftragt, die Video- und Audioqualität unter verschiedenen Bedingungen und Anruftypen für die folgenden Anbieter zu vergleichen:

- Zoom

- Microsoft Teams

- Google Meet

- Cisco Webex

Die Ergebnisse in diesem Bericht spiegeln die TestDevLab-Testergebnisse im April 2024 wider.

Über TestDevLab

TestDevLab (TDL) bietet Softwaretest- und Qualitätssicherungsdienste für mobile, Web- und Desktop-Anwendungen sowie die Entwicklung kundenspezifischer Testwerkzeuge an. Das Unternehmen ist auf Softwaretests und Qualitätssicherung spezialisiert und entwickelt fortschrittliche maßgeschneiderte Lösungen für Sicherheits-, Batterie- und Datennutzungstests von mobilen Apps. Es bietet auch die Bewertung der Video- und Audioqualität für VoIP- oder Kommunikations-Apps und Produkte für die automatische Backend-API sowie Weblast- und Leistungstests an.

Das TestDevLab-Team besteht aus über 500 erfahrenen Technikfachkräften, die sich auf Softwaretests und -entwicklung konzentrieren. Die Mehrheit dieser Testfachkräfte besitzt Zertifizierungen des International Software Testing Qualifications Board (ISTQB) und verfügt damit über ein hohes Maß an Fachkompetenz im Bereich Softwaretests gemäß den Branchenstandards und der Servicequalität.

Um einen fairen Test für alle Anbieter zu gewährleisten, wurden alle Tests mit Geräten und Konten von TestDevLab durchgeführt. Zusätzlich wurden die einzelnen Anbieterkonten in einer Standardkonfiguration gehalten, mit Ausnahme der Ermöglichung einer maximalen Auflösung von HD (1080p) für Anbieter, die standardmäßig die Videoauflösung begrenzen.

Die Testszenarien umfassten ein „Empfänger“-Gerät, ein „Sender“-Gerät und zusätzliche Geräte, die als weitere Teilnehmer fungierten. Alle Geräte waren mit demselben Videoanruf verbunden. Je nach Testszenario wurden das Anruflayout und das Netzwerk so konfiguriert, dass die erforderlichen Testparameter reproduziert werden konnten.

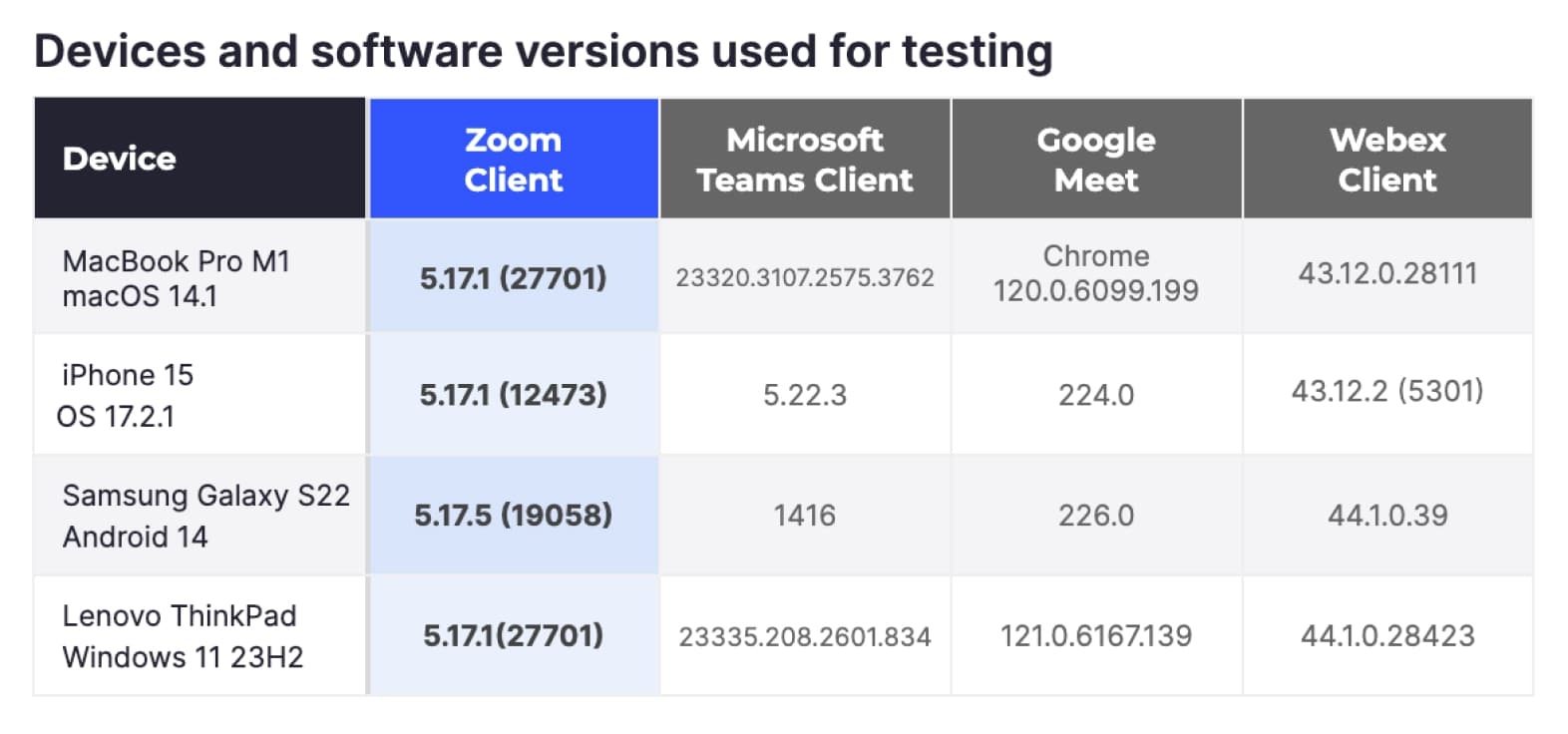

Für die Tests verwendete Geräte und Softwareversionen

Testszenarien

Um einen Gesamtüberblick über die Video- und Audioqualität in Zoom Meetings zu erhalten, haben wir TDL gebeten, die gängigsten Meetingszenarien zu testen und dabei gängige Hardware zu verwenden.

Szenarien mit variablen Netzwerken

Für diese Szenarien wollten wir mithilfe einiger gängiger Datenverarbeitungsplattformen testen, wie die unterschiedlichen Plattformen unter variablen Netzwerkbedingungen reagieren. Um dieses Ziel zu erreichen, nutzte TDL vier gängige Hardwareplattformen: MacBook-Pro-Computer, Windows-Computer, iPhones und Android-Geräte. Wir haben den gängigsten Meeting-Typ mit drei Teilnehmern, ohne freigegebene Inhalte und einer Einstellung für die Sprecheransicht konfiguriert, um die Videoauflösung zu maximieren.

Die getesteten Netzwerkszenarien umfassten:

- Fehlerfreies Netzwerk: Keine Netzwerkbeschränkungen, dient als Ausgangswert.

- Netzwerk begrenzt auf 1 Mbit/s: Die Netzwerkbandbreite ist auf 1 Mbit/s begrenzt.

- Netzwerk begrenzt auf 500 Kbit/s: Die Netzwerkbandbreite ist auf 500 Kbit/s begrenzt.

- Variabler Paketverlust: Die Meetings begannen mit einem Paketverlust von 10 %, der nach einer Minute auf 20 % und nach einer weiteren Minute auf 40 % anstieg.

- Variable Latenz: Meetings beginnen ohne Einschränkungen. Nach einer Minute werden eine Minute lang 100 ms Latenz und 30 ms Jitter eingeführt. Dann wird die Latenz auf 500 ms erhöht und der Jitter auf 90 ms.

- Netzwerkwiederherstellung: Die Meetings begannen ohne Einschränkungen. Nach einer Minute wurde ein Netzwerkproblem simuliert, das die Bandbreite auf 1 Mbit/s begrenzte, 10 % Paketverluste hinzufügte und eine Minute lang eine Latenz von 100 ms und einen Jitter von 30 ms verursachte. Danach kehrte das Netzwerk in den Normalzustand zurück.

- 3G-Mobilfunknetz: Es wurde ein Videoanruf ausschließlich über mobile Geräte im 3G-Mobilfunknetz durchgeführt.

- Test mit überlastetem Netzwerk: Der Anruf beginnt mit einem fehlerfreien Netzwerk, dann wird in verschiedenen Intervallen ein kurzer Datenstrom mit hohem Volumen über das Netzwerk gesendet, um ein ausgelastetes Netzwerk zu simulieren.

Jeder Anruf dauerte drei Minuten und wurde fünfmal wiederholt. Über alle Anbieter, Hardware-Variationen und Netzwerkbedingungen hinweg führte TDL 420 Meetings durch.

Wenn Beschränkungen für einen Anruf festgelegt wurden, waren diese auf das getestete Gerät beschränkt, das als „Empfänger“ fungierte.

Szenarien mit variablem Anruftyp

Für diese Szenarien wollten wir die verschiedenen Anruftypen und Technologien testen, die von den meisten Benutzern verwendet werden. Die verwendete Hardware beschränkte sich auf MacBook Pro M1- und Windows-Computer. Die Szenarien beinhalteten Meetings mit fünf und acht Personen, die im Galeriemodus arrangiert wurden. TDL testete Meetings, die nur Teilnehmer hatten, Meetings, bei denen Inhalte geteilt wurden, und Meetings, bei denen die Teilnehmer virtuelle Hintergründe aktivierten.

In allen Fällen blieb das Netzwerk fehlerfrei und uneingeschränkt. Wie zuvor dauerte jedes Meeting drei Minuten und wurde fünfmal wiederholt. Insgesamt hat TDL in dieser Kategorie 240 zusätzliche Meetings durchgeführt.

Erfasste Kennzahlen

Um ein vollständiges Bild der Meetingqualität zu erhalten, haben wir TDL gebeten, Kennzahlen in vier Hauptkategorien zu erfassen: Audioqualität, Videoqualität, Netzwerknutzung und Ressourcennutzung. Die Kennzahlen wurden während des gesamten Meetings sekündlich erfasst und in einer zentralen Datenbank gespeichert.

Audioqualität

- MOS-Wert: Der Mean Opinion Score (MOS) quantifiziert die Anrufqualität anhand von Bewertungen menschlicher Benutzer, typischerweise auf einer Skala von 1 (schlecht) bis 5 (ausgezeichnet), und spiegelt die wahrgenommene Audioklarheit und das Gesamterlebnis wider.

- ViSQOL: ViSQOL (Virtual Speech Quality Objective Listener) ist eine objektive Metrik, die die Anrufqualität bewertet, indem sie die Ähnlichkeit zwischen dem ursprünglichen und dem übertragenen Audiosignal mithilfe eines Wahrnehmungsmodells vergleicht.

- Audioverzögerung: Die Audioverzögerung misst die Latenz zwischen dem gesprochenen Wort und dessen Empfang durch den Zuhörer. Niedrigere Werte deuten auf eine geringe Verzögerung und eine höhere Qualität des Anrufs hin.

Videoqualität

- FPS: Bilder pro Sekunde (Frames per Second, FPS) misst die Anzahl einzelner Bilder pro Sekunde in einem Video, wobei höhere FPS für flüssigere Bewegungen und verbesserte Videoqualität sorgen.

- VMAF: Video Multi-method Assessment Fusion (VMAF) ist eine von Netflix entwickelte Wahrnehmungs-Videoqualitätsmetrik, die mehrere Qualitätskennzahlen kombiniert, um Zuschauerzufriedenheit und Videoqualität vorherzusagen.

- VQTDL: Video Quality Temporal Dynamics Layer (VQTDL), entwickelt von TDL, bewertet die Videoqualität, indem es zeitliche Schwankungen und Dynamiken analysiert und erfasst, wie Veränderungen im Laufe der Zeit das gesamte Videoerlebnis beeinflussen.

- PSNR: Die Peak Signal-to-Noise Ratio (PSNR) ist eine mathematische Metrik zur Messung der Videoqualität durch Vergleich der Original- und komprimierten Videobilder. Höhere Werte deuten auf geringere Verzerrungen und eine bessere Qualität hin.

- Videoverzögerung: Videoverzögerung bezeichnet die Zeitverzögerung zwischen der tatsächlichen Live-Videoaufnahme und der Anzeige auf dem entfernten Bildschirm. Geringere Verzögerungen sorgen für ein realistischeres Meeting-Erlebnis.

- Video-Freeze: Video-Freeze misst die Häufigkeit und Dauer von Pausen oder Aussetzern im Videostream. Weniger und kürzere Freezes deuten auf eine bessere Videoqualität hin.

Ressourcennutzung

- Die CPU-Auslastung misst den Prozentsatz der Kapazität des Hauptprozessors (CPU), der vom Meeting-Client genutzt wird.

- Die Speicherauslastung bezieht sich auf die Menge an Arbeitsspeicher (RAM), die von einem Meeting-Client verbraucht wird.

- Die GPU-Auslastung misst den Prozentsatz der Kapazität der Grafikprozessoreinheit (GPU), der vom Meeting-Client genutzt wird.

Netzwerknutzung

- Sender-Bitrate: Die Menge an Netzwerkdaten, die von jedem Rechner im Meeting gesendet wird.

- Empfänger-Bitrate: Die Menge an Netzwerkdaten, die von jedem Rechner im Meeting empfangen wird.

Nicht alle Kennzahlen können auf allen Plattformen erfasst werden. Zum Beispiel können nicht alle Kennzahlen zur Ressourcennutzung auf Mobilgeräten erfasst werden. TDL maximierte die Erfassung von Kennzahlen in jedem Anrufszenario.

Um die Darstellung der riesigen Datenmenge, die von TDL gesammelt wurde, zu vereinfachen, haben wir jede der oben genannten Kennzahlen auf einer Skala von 1 bis 4 bewertet, wobei 1 die beste und 4 die schlechteste Punktzahl ist. Anschließend haben wir die Punktzahlen aus den Kennzahlen in die vier Kategorien eingeteilt. Die niedrigsten Gesamtsummen stellen die besten Qualitätswerte in jeder Kategorie dar.

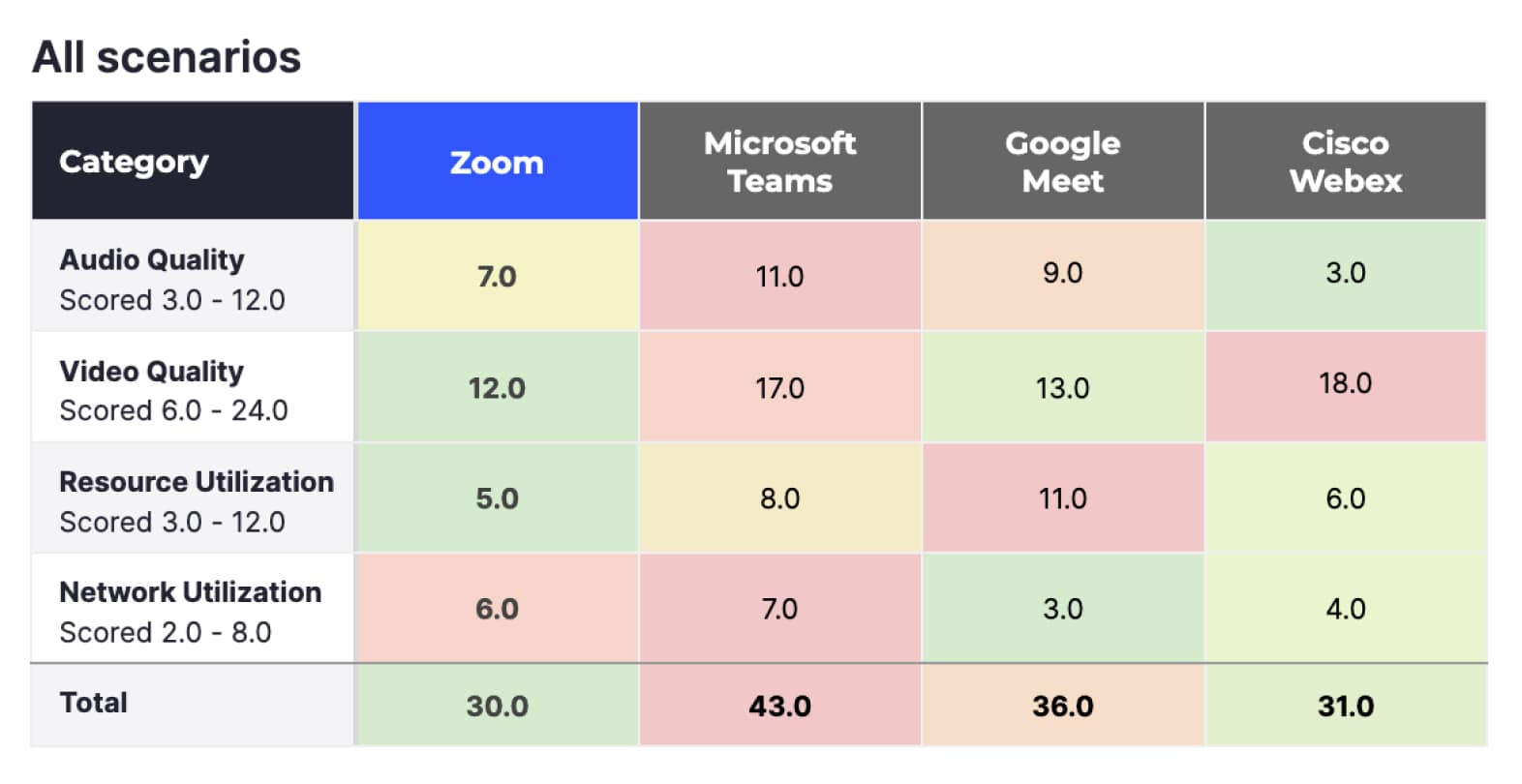

In diesem Abschnitt werden die Ergebnisse auf einer allgemeinen Ebene untersucht, wobei verschiedene Filter angewendet werden, um den Fokus auf unterschiedliche Anrufkategorien zu legen. Später werden wir uns auf einzelne Anrufszenarien konzentrieren und detailliertere Informationen zum Verhalten der verschiedenen Plattformen in diesen Szenarien liefern. Weitere Informationen finden Sie unter „Detaillierte Ergebnisse“.

Die obigen Ergebnisse umfassen die Bewertungen aller 660 Meetings, einschließlich aller Geräte und Netzwerkszenarien:

- Unter Berücksichtigung aller Kennzahlen erzielte Zoom das beste Ergebnis (30), dicht gefolgt von Cisco Webex (31). Google Meet (36) und Microsoft Teams (43) schnitten im Vergleich schlechter ab.

- Zoom erzielte die besten Werte für Videoqualität und Ressourcennutzung (12 bzw. 5). Zoom schnitt in diesem Test besser ab, da Zoom Meetings die meisten Videoverarbeitungsfunktionen von der CPU auf die GPU verlagert, sodass die CPU für die Ausführung anderer Anwendungen auf dem Gerät frei bleibt.

- Bei der Netzwerknutzung schnitt Google Meet (3) am besten ab.

- Bei der Audioqualität schnitt Cisco Webex am besten ab (3), gefolgt von Zoom (7). Google Meet (9) und Microsoft Teams (11) schnitten im Vergleich schlechter ab.

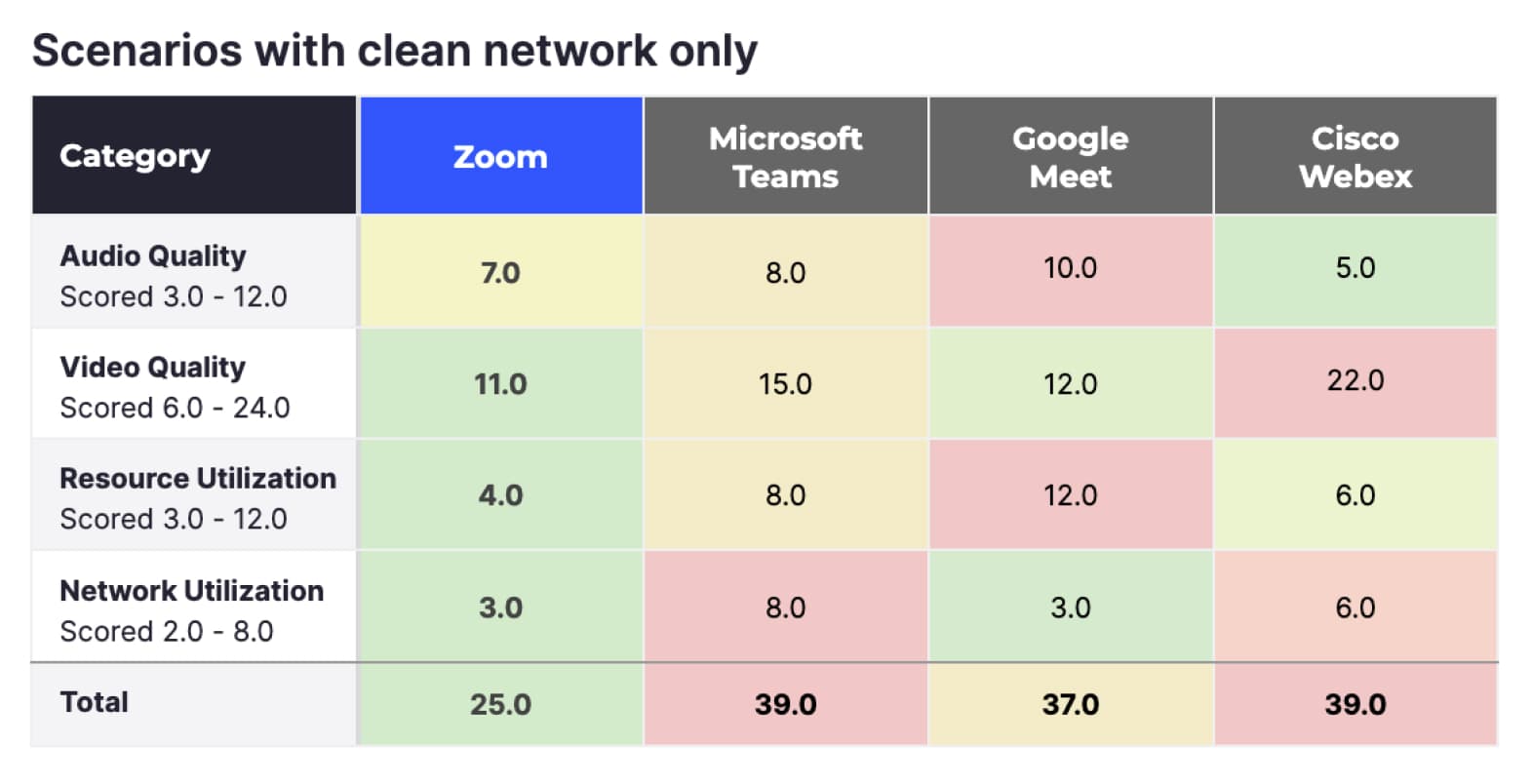

Szenarien nur mit fehlerfreiem Netzwerk

Die obige Gesamtpunktzahl stellt die Gesamtheit der TDL-Tests dar, aber in Wirklichkeit werden die meisten regulären Benutzer viele der von TDL simulierten Netzwerkeinschränkungen nicht erleben. Die Ergebnisse unten filtern alle Tests heraus, die Netzwerkeinschränkungen hatten, sodass nur die Tests für fehlerfreie Netzwerke beibehalten werden.

Bei der Betrachtung von Meetings in einem fehlerfreien Netzwerk schneidet Zoom (25) noch besser ab, Google Meet (37) belegt den zweiten Platz, während Microsoft Teams (39) und Cisco Webex (39) die letzten Plätze belegen.

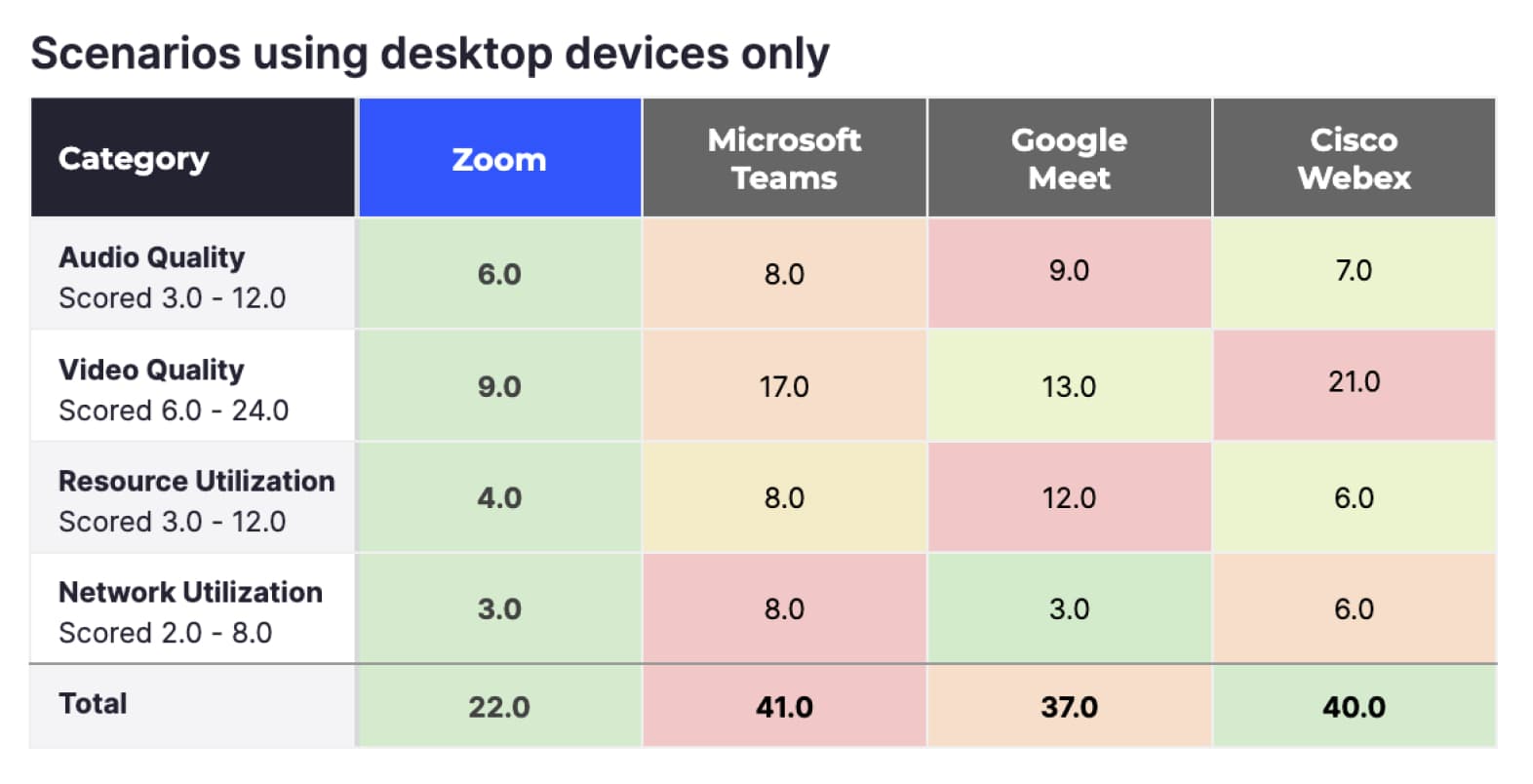

Szenarien mit ausschließlich Desktop-Geräten

Obwohl viele Menschen Mobilgeräte verwenden, um sich mit Meetings zu verbinden, verbinden sich durchschnittlich ~ 66 % aller Zoom-Teilnehmer über Desktop-Geräte (laut internen Zoom-Statistiken). Wenn die Daten nur auf Desktop und Meetings ohne Netzwerkprobleme gefiltert werden, steigt der Vorsprung von Zoom noch weiter an und führt auch bei allen vier Kennzahlen.

Zusammenfassung

Zoom übertrifft die getesteten alternativen Meeting-Dienste in jeder Kategorie, die TDL unter idealen Bedingungen und mit den am häufigsten verwendeten Geräten gemessen hat. Da die Bedingungen nicht immer ideal sind, ist es wichtig, Umstände zu messen, unter denen Benutzer möglicherweise Netzwerkprobleme erleben.

Anbieter können sich automatisch an veränderte Netzwerkbedingungen anpassen, um eine hohe Video- und Audioqualität aufrechtzuerhalten. Die Protokolle der einzelnen Anbieter passen sich unterschiedlich an, wodurch sich unter Umständen die Videoauflösung, die Komprimierungsqualität, die Bildrate (FPS) und andere Faktoren ändern. Das Gesamterlebnis des Benutzers während eines Videoanrufs hängt davon ab, wie gut der Anbieter diese Parameter bei schwankenden Netzbedingungen optimieren kann.

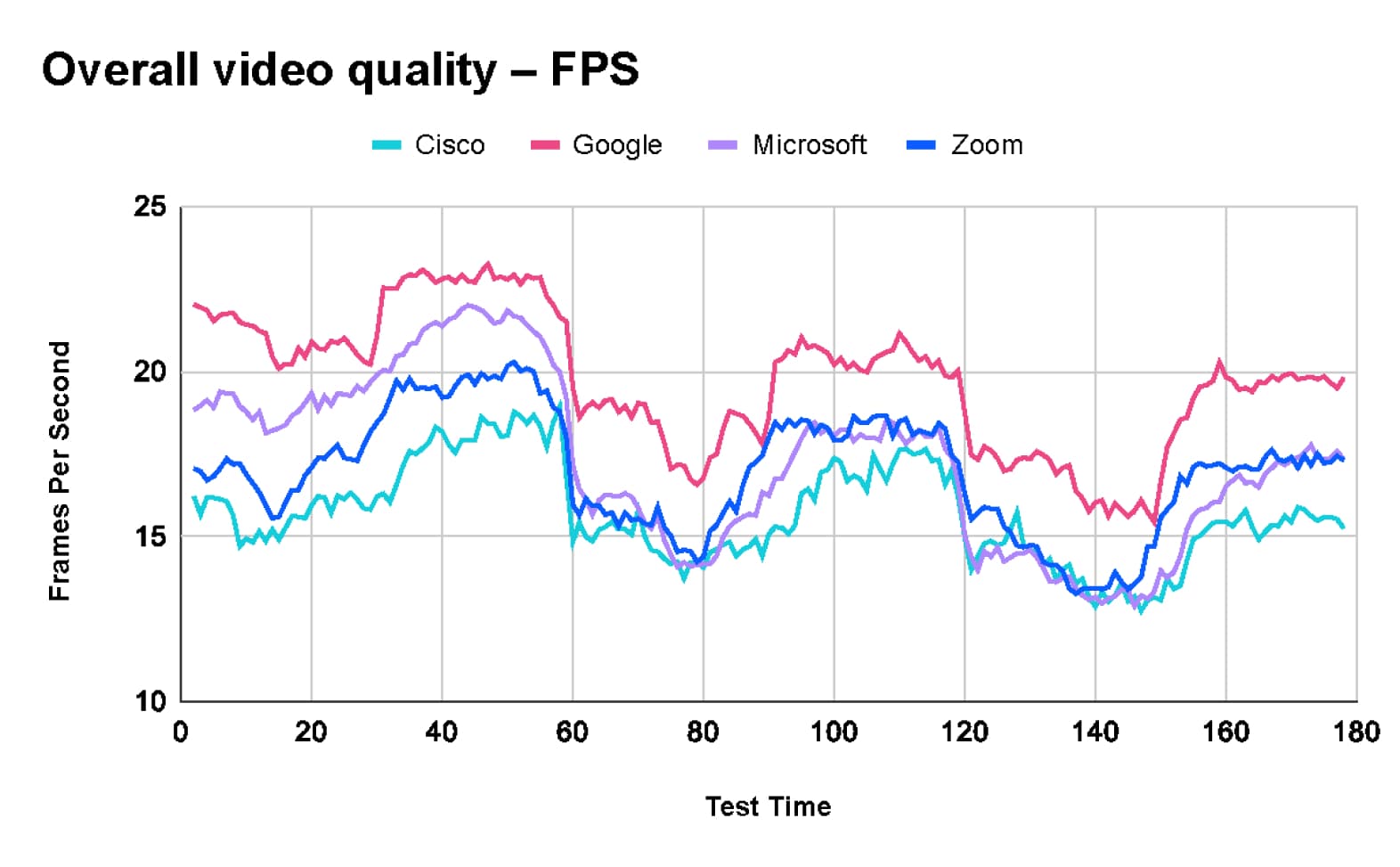

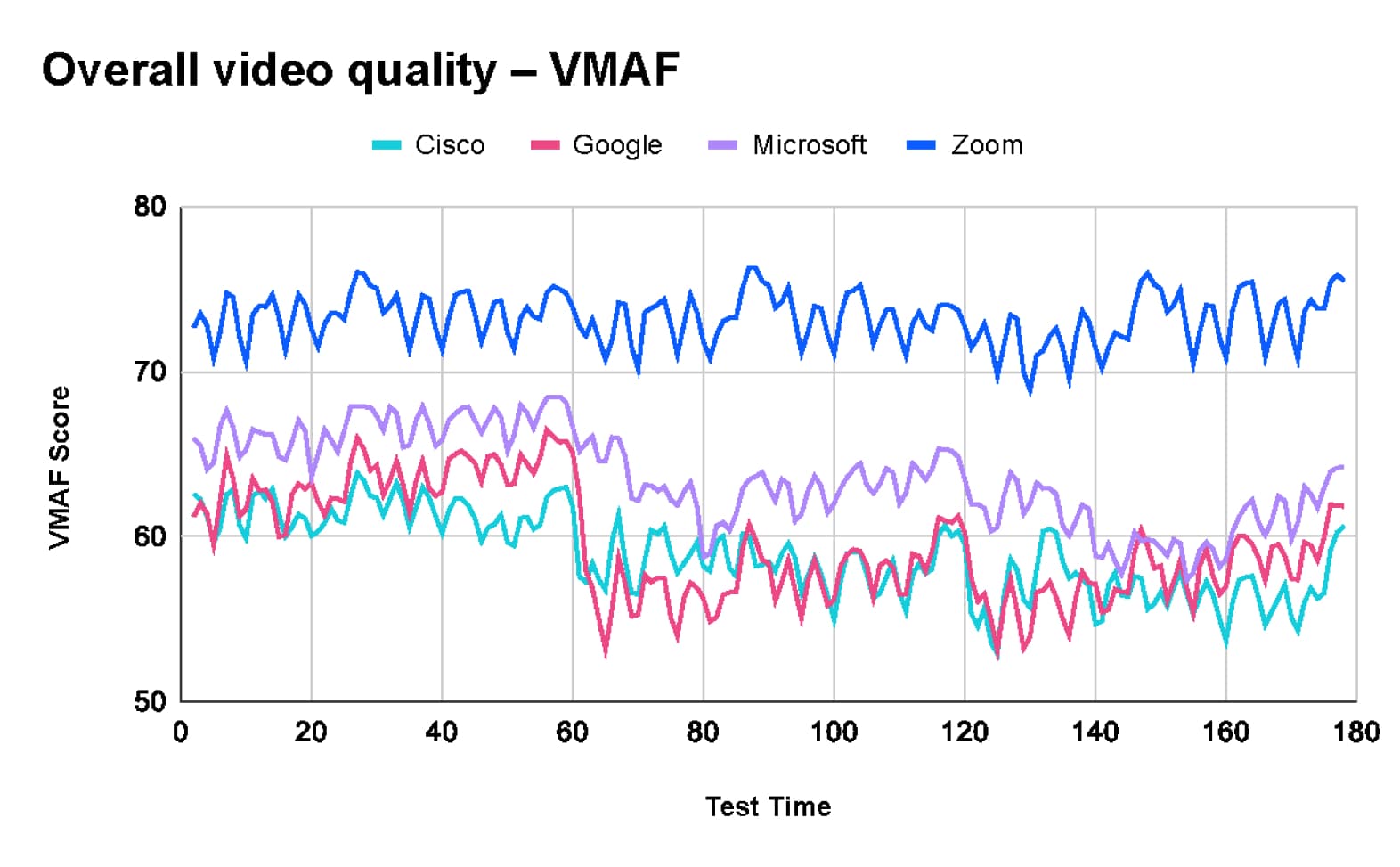

TestDevLab erfasste mehrere Kennzahlen, um die allgemeine Benutzererfahrung während eines Anrufs zu messen. Die beiden wichtigsten gesammelten Kennzahlen sind VMAF, das die wahrgenommene Bildqualität misst, und Bilder pro Sekunde (FPS), das die Flüssigkeit des Videos anzeigt.

Gesamtvideoqualität bei allen Tests

Nach der Analyse der kombinierten Testergebnisse von 660 Tests stellte TDL fest, dass Google Meet mit 20 Bildern pro Sekunde (FPS) die höchste durchschnittliche Bildrate liefert. Im Vergleich dazu erreichen Microsoft Teams und Zoom im Durchschnitt jeweils 17 FPS, während Webex im Durchschnitt 16 FPS erreicht.

Die höhere Bildrate von Google Meet geht jedoch mit einer geringeren Videoqualität einher. Laut der VMAF-Tabelle (Video Multimethod Assessment Fusion) führt Zoom mit einem Durchschnittswert von 73,2 Punkten. Microsoft Teams folgt mit 63,5 Punkten, Google Meet erreicht 59,5 Punkte und Webex durchschnittlich 58,9 Punkte.

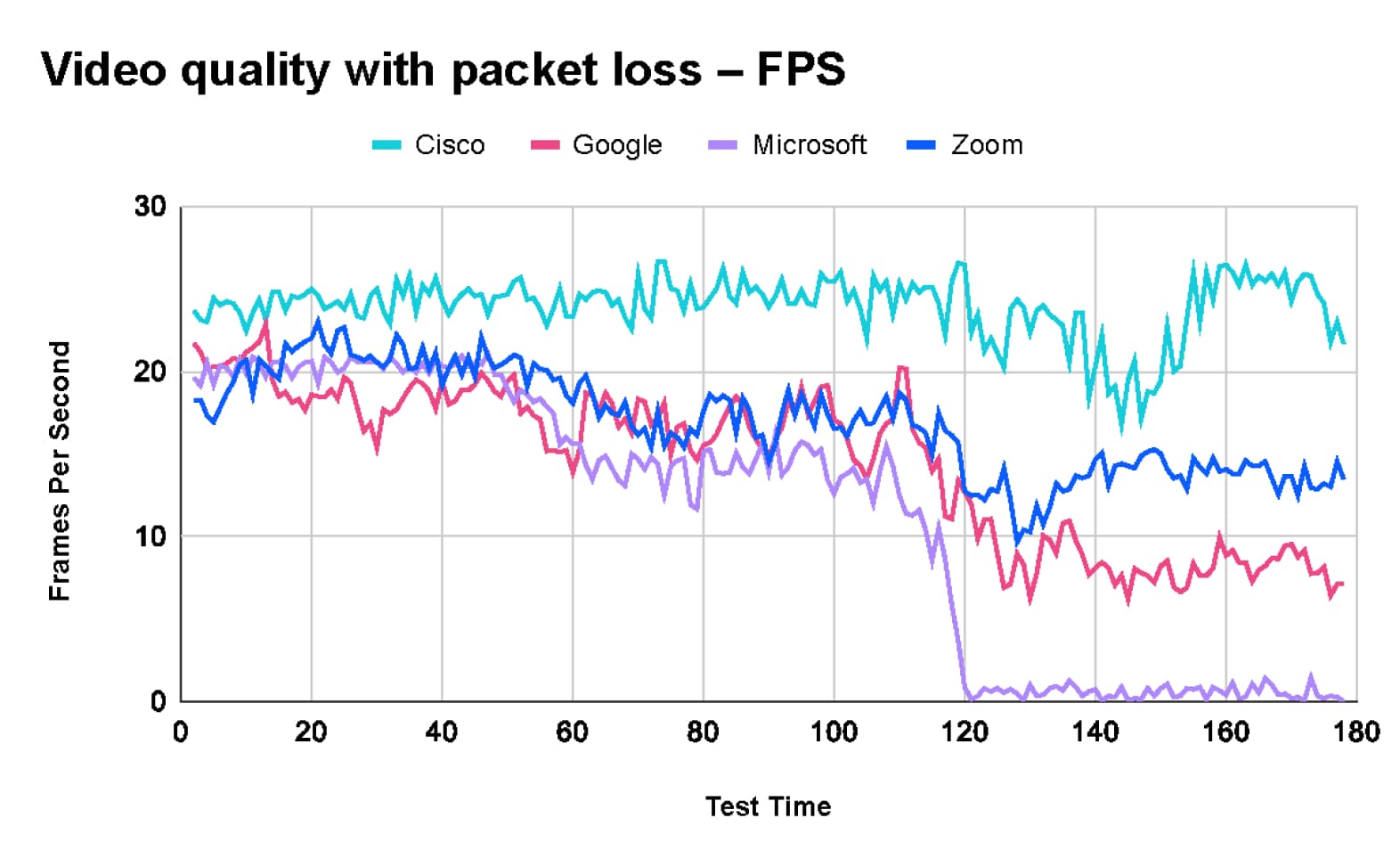

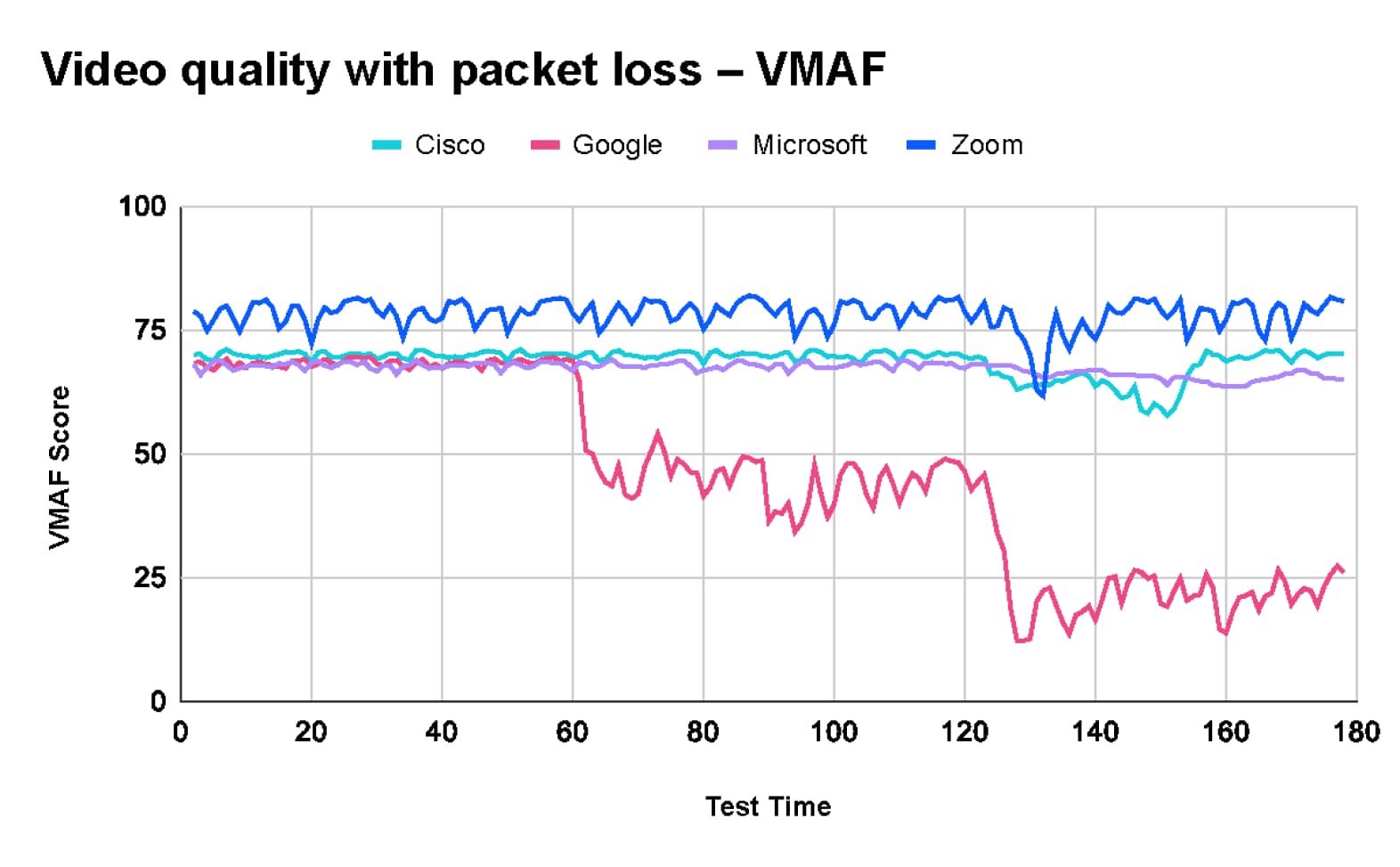

Videoqualität mit Paketverlust

Der von TestDevLab durchgeführte Paketverlusttest umfasste drei Phasen.

- Der Anruf begann mit einem Paketverlust von 10 %.

- Nach 60 Sekunden erhöhte sich der Paketverlust auf 20 %.

- Nach weiteren 60 Sekunden erhöhte sich der Paketverlust nochmals auf 40 %.

Die unten abgebildeten Diagramme zeigen Folgendes:

- Zoom behält eine hervorragende Videoqualität mit einem VMAF-Wert von rund 80 bei, allerdings sinkt die Bildrate von etwa 20 FPS auf 13 FPS.

- Webex gewährleistet während des gesamten Tests eine relativ stabile Videoqualität und Bildrate.

- Bei Google Meet kommt es zu einem signifikanten Rückgang des VMAF-Werts von 70 auf 20 bei einem Paketverlust von 40 % und die Bildrate sinkt bis zum Ende des Tests von etwa 15 FPS auf 8 FPS.

- Microsoft Teams behält die Bildqualität mit einem VMAF-Wert von 70 bei. Die Bildrate sinkt jedoch drastisch von etwa 20 FPS zu Beginn des Tests auf 2 FPS, wenn ein Paketverlust von 40 % auftritt, was zu einem ruckeligen Videoerlebnis führt.

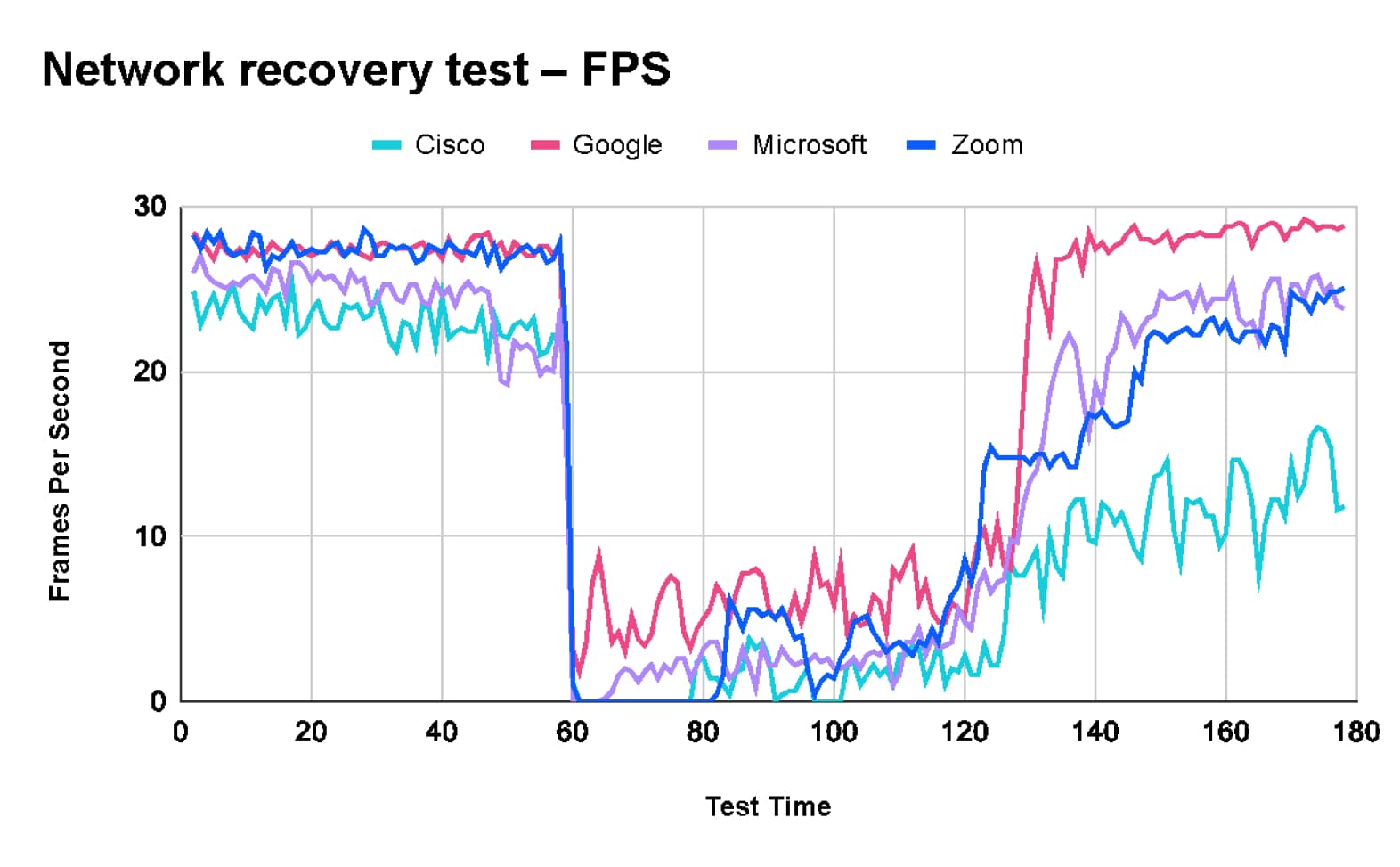

Test der Netzwerkwiederherstellung

Beim Test der Netzwerkwiederherstellung startete TDL den Test mit einem fehlerfreien Netzwerk.

- Nach 60 Sekunden traten eine Reihe von Netzwerkproblemen auf, darunter eine Begrenzung auf 1 Mbit/s, 10 % Paketverlust, 100 ms Verzögerung und 30 ms Jitter.

- Nach 60 Sekunden einer „schlechten Netzwerkverbindung“ wurden die Einschränkungen aufgehoben und das Netzwerk kehrte in seinen ursprünglichen Zustand zurück.

Dieser Test wurde entwickelt, um das Verhalten der getesteten Plattformen bei einem vorübergehenden Netzwerkproblem zu prüfen und die Fähigkeit jeder Plattform zur Wiederherstellung nach Behebung des Problems zu testen.

Die Testergebnisse zeigen, dass Zoom zwar eine hohe Videoqualität beibehält, es jedoch etwa 10 Sekunden dauert, bis die Codec-Parameter an die neuen Netzwerkbedingungen angepasst sind, was für einige Sekunden zu einer sehr niedrigen Bildrate führt. In Bezug auf die Wiederherstellungszeit liegt Zoom im Mittelfeld, zwischen Webex mit sehr niedriger Wiederherstellungszeit und Teams und Google mit schneller Wiederherstellung.

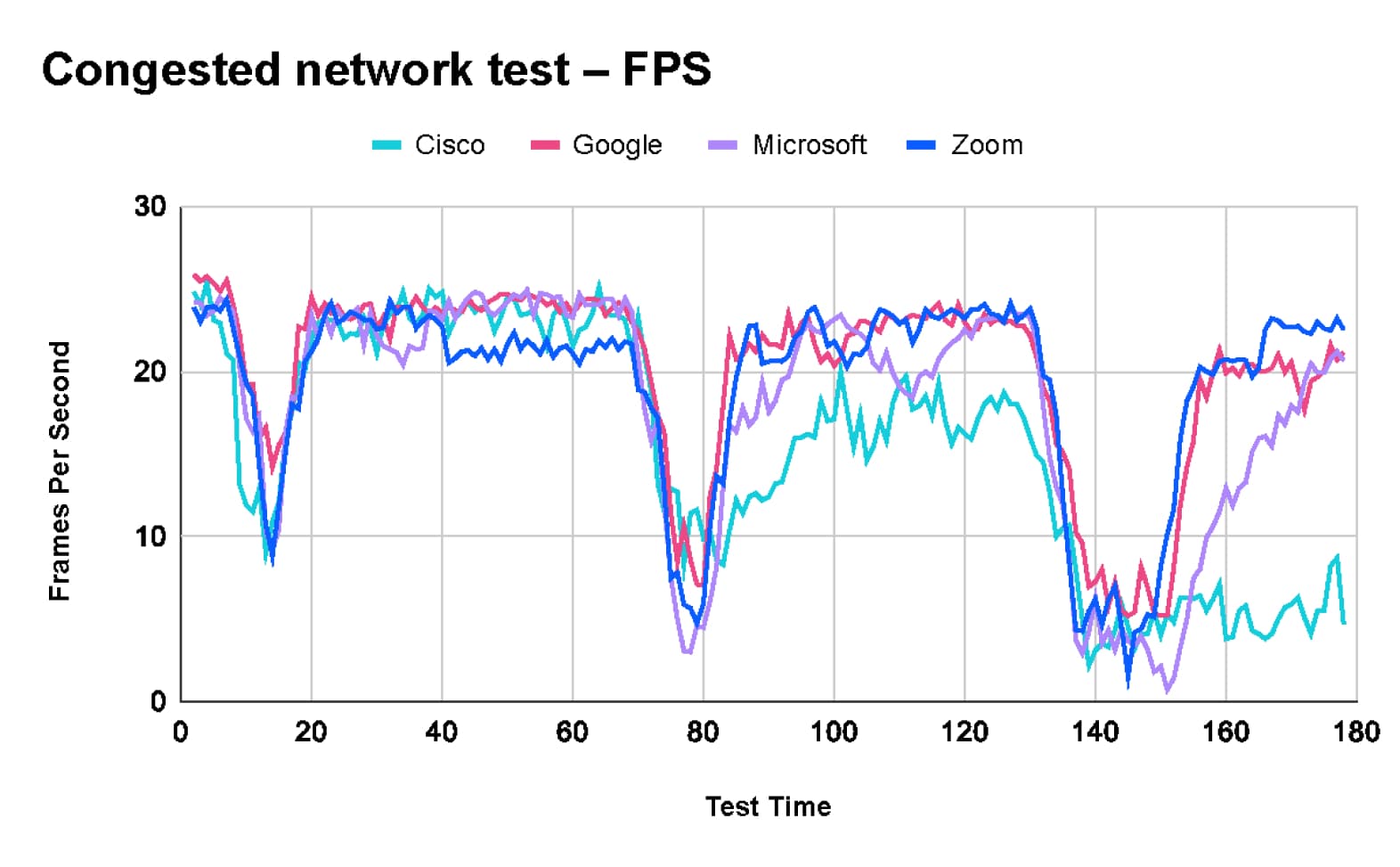

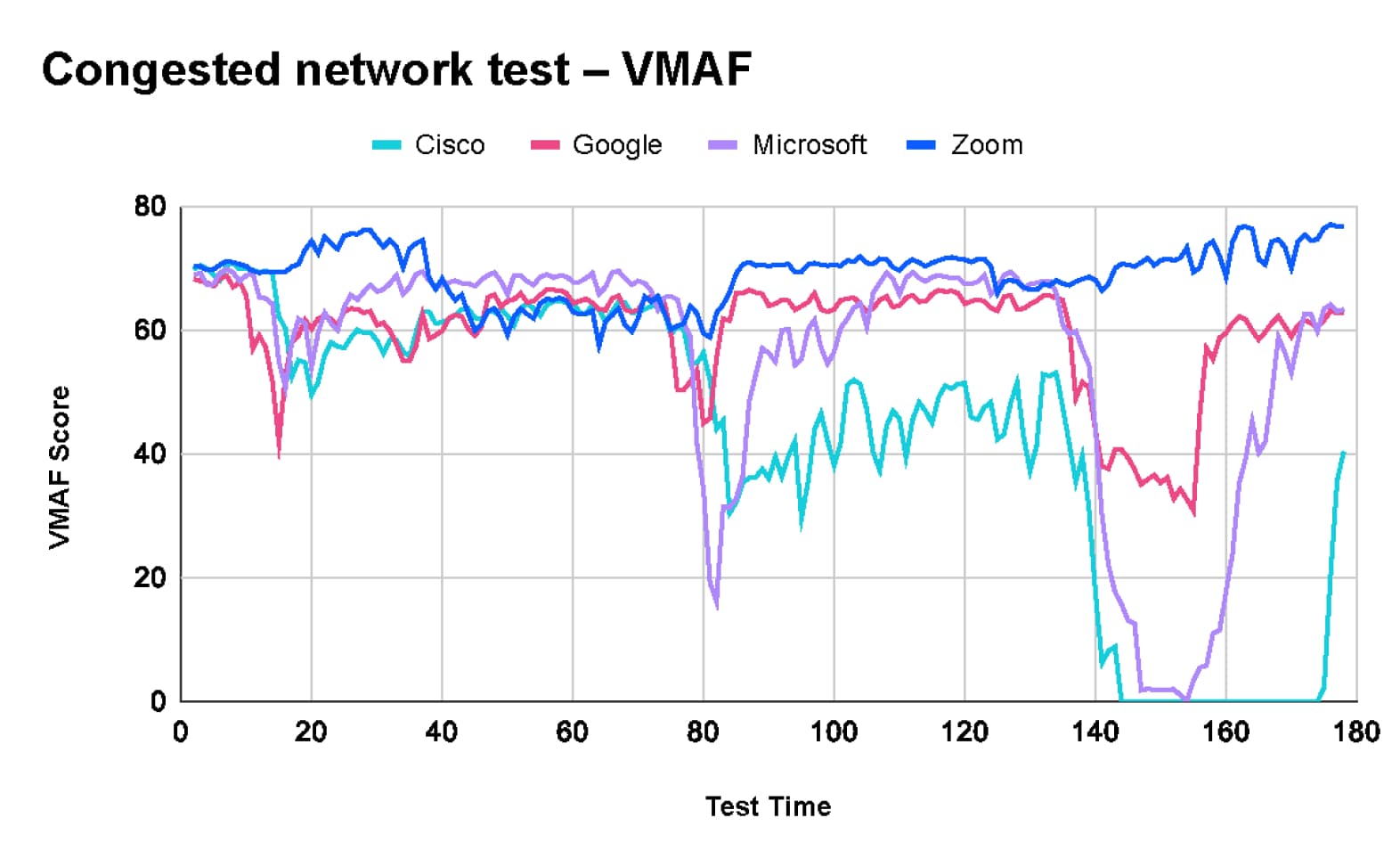

Test mit einem überlasteten Netzwerk

Ziel des Tests bei überlastetem Netzwerk war es, das Verhalten der getesteten Plattformen unter verschiedenen Dauern von Netzwerküberlastung und ihre Fähigkeit zur Aufrechterhaltung der Leistungsfähigkeit in Netzwerken mit zeitweiligen Verkehrsspitzen zu bewerten.

- Das Testskript wechselte zwischen Phasen der Inaktivität und Phasen mit einer Datenverkehrslast von 10 Mbit/s (auf einer 10-Mbit/s-Leitung), wobei die Dauer der Überlastung zunahm und die Pausen dazwischen unterschiedlich lang waren.

Die Testergebnisse zeigen, dass Zoom während des gesamten Tests die Bildqualität beibehält und dabei Bildrate und Videoverzögerung opfert, um den sich ändernden Netzwerkbedingungen gerecht zu werden. Bemerkenswert ist, dass Webex am Ende des Tests die Videoübertragung komplett abgebrochen hat.

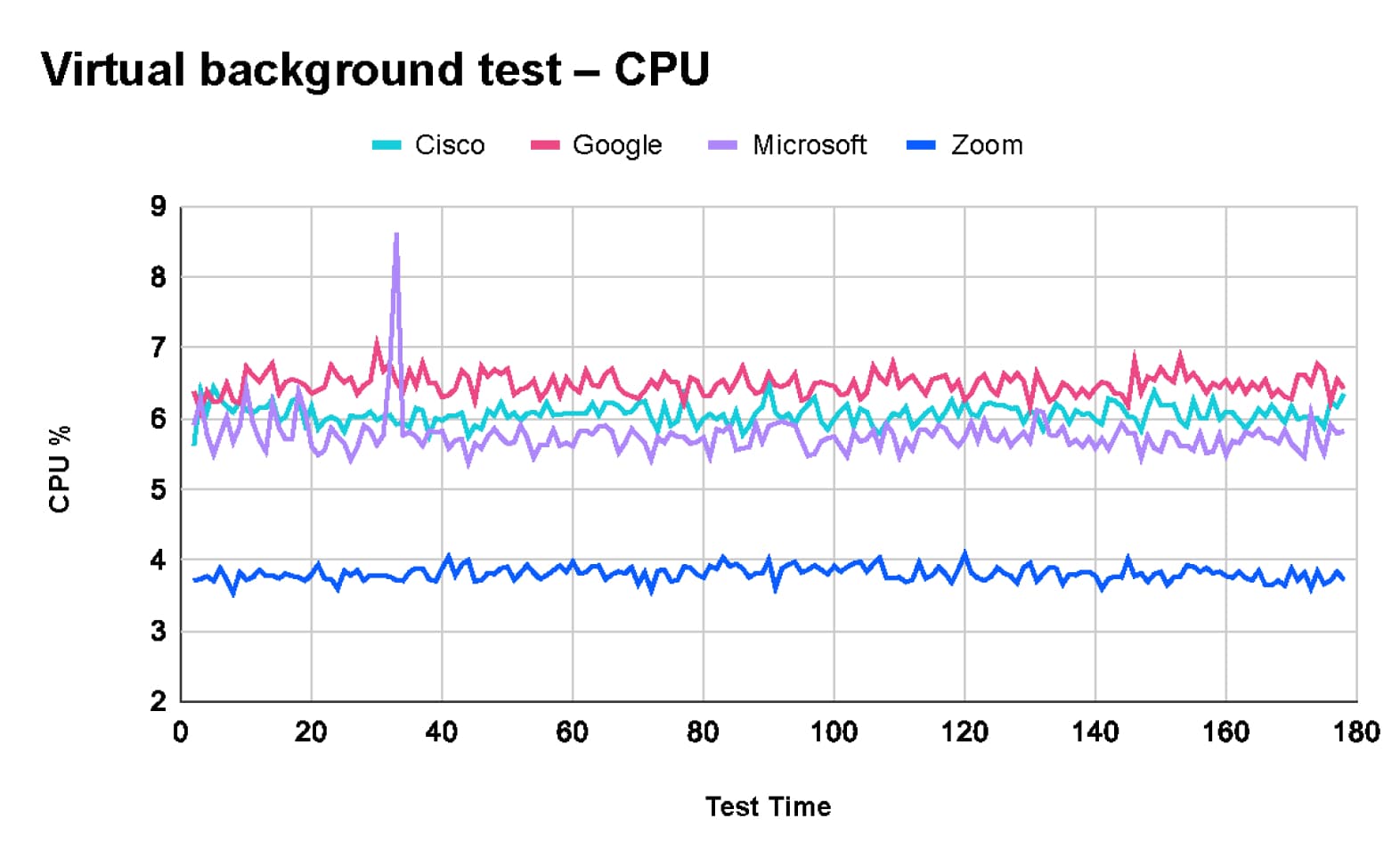

Qualitätstest mit virtuellen Hintergründen

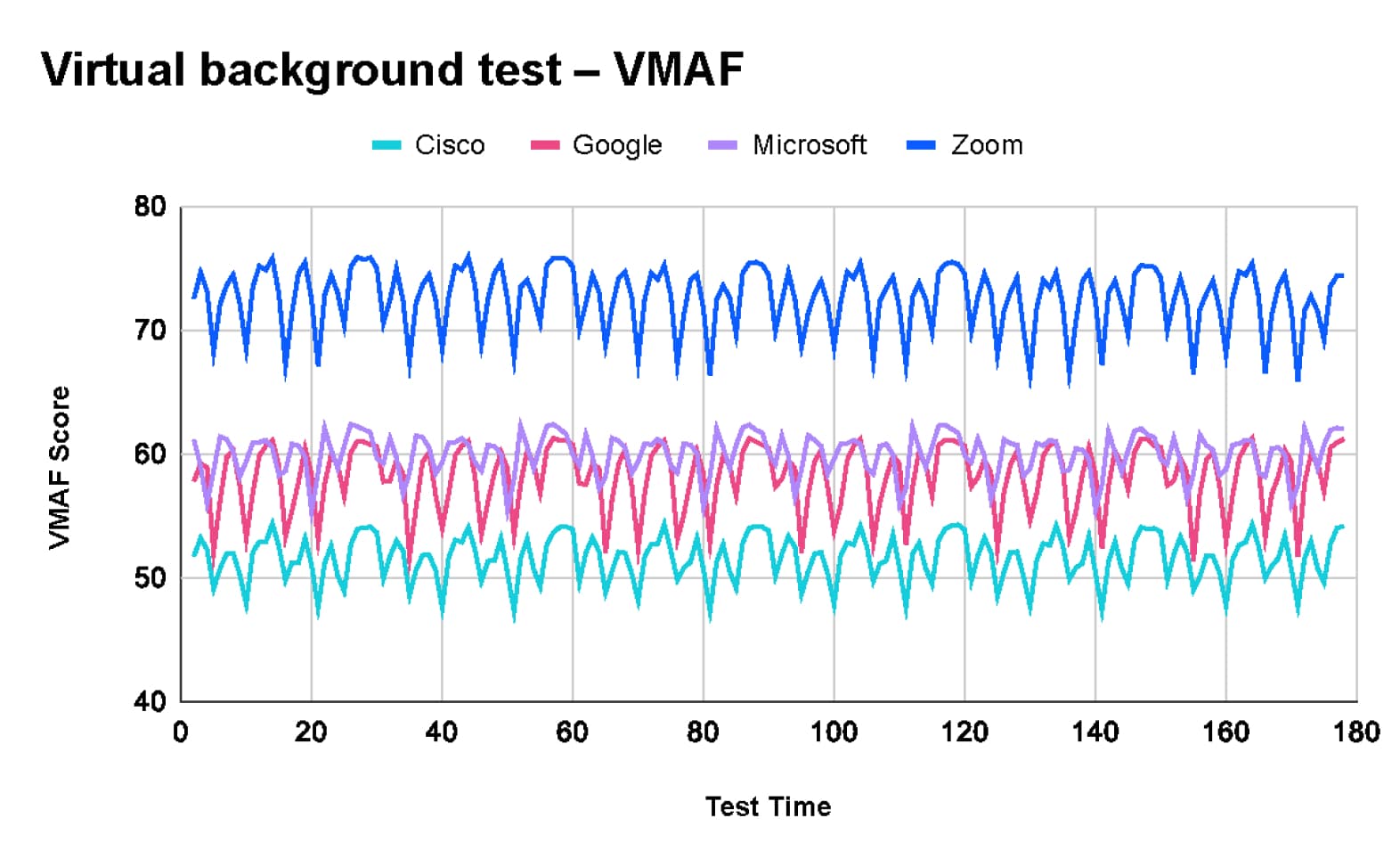

In unseren Testszenarien haben wir TDL beauftragt, die Benutzererfahrung der Funktion für virtuelle Hintergründe zu bewerten. Diese Funktion ersetzt den realen Hintergrund des Benutzers durch ein Bild oder Video, was eine erhebliche Verarbeitung erfordert, um ein qualitativ hochwertiges Gesamtbild zu erzeugen.

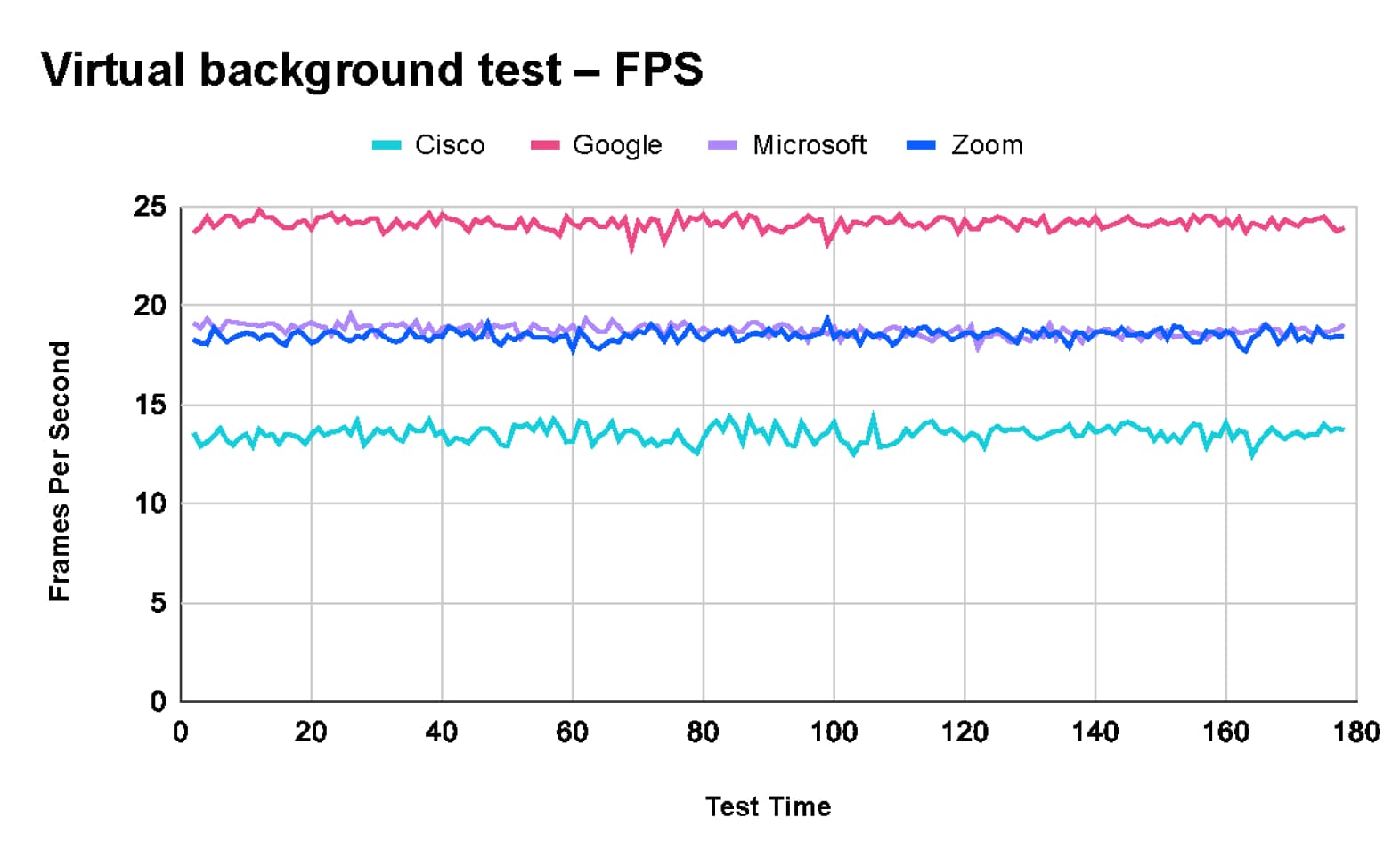

Laut den Ergebnissen von TDL lieferte Zoom die beste Bildqualität. Manche Meeting-Anbieter legen Wert auf Videoqualität, andere auf Bildrate, wenn nach VMAF bewertet wird:

- Zoom (73) hat eine konstante Bildrate von 18 FPS

- Microsoft Teams (60) hat eine konstante Bildrate von 18 FPS

- Google Meet (58) hat eine hohe Bildrate von 24 FPS

- Cisco Webex (52) hat eine niedrige Bildrate von 13 FPS

Diese Ergebnisse stimmen mit den internen Qualitätstests für virtuelle Hintergründe von Zoom überein, die im letzten Jahr durchgeführt wurden und in diesem Video gezeigt werden.

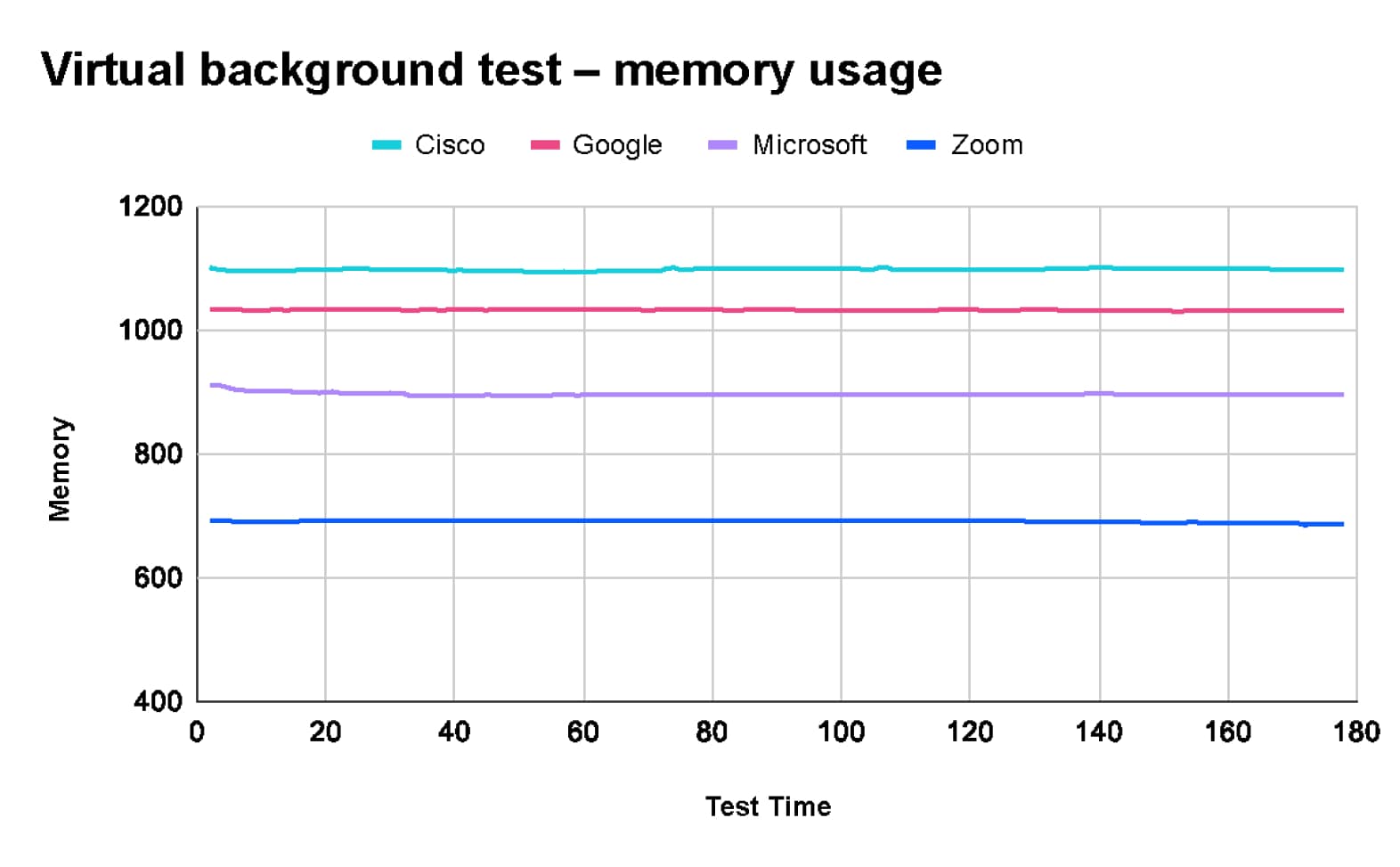

Außerdem haben die Tests von TDL ergeben, dass Zoom bei Verwendung der virtuellen Hintergrundfunktion die wenigsten CPU- und Speicherressourcen verbraucht.

Die umfangreichen Tests von TDL verdeutlichen signifikante Leistungsunterschiede zwischen Zoom, Microsoft Teams, Google Meet und Cisco Webex unter verschiedenen Netzwerkbedingungen und Meeting-Szenarien.

- Zoom lieferte durchweg das beste Gesamterlebnis und zeichnete sich durch hervorragende Videoqualität und Ressourcennutzung aus, wobei die Leistung auch bei Netzwerkbelastung erhalten blieb.

- Google Meet zeichnet sich durch seine Netzwerkeffizienz aus, während Cisco Webex eine gute Audioqualität bietet.

- Die herausragende Leistung von Zoom, insbesondere bei der Aufrechterhaltung einer hohen Videoqualität und der effizienten Ressourcennutzung, macht es zur ersten Wahl für stabile und zuverlässige virtuelle Meetings.