Conheça o Zoom AI Companion, seu novo assistente de IA!

Aumente a produtividade e a colaboração em equipe com o Zoom AI Companion, disponível sem custo adicional em planos Zoom qualificáveis.

O CTO da Zoom, Xuedong Huang, discute como os pequenos modelos de linguagem (SLMs) impulsionam nossa visão para que os agentes de IA colaborem em uma abordagem federada para melhorar suas tarefas diárias.

Atualizada em February 25, 2025

Publicado em February 19, 2025

Xuedong Huang é o diretor executivo de tecnologia (CTO). Antes de entrar no Zoom, ele trabalhava na Microsoft, onde era Diretor executivo de Tecnologia da Azure AI e Técnico especialista sênior. Sua carreira é bastante conhecida na área de IA: ele iniciou o grupo de tecnologia de fala da Microsoft em 1993, liderou as equipes de IA da Microsoft para alcançar vários dos primeiros marcos com paridade humana do setor em reconhecimento de fala, tradução automática, compreensão de linguagem natural e visão computacional, é membro do IEEE e da ACM e membro eleito da Academia Nacional de Engenharia e da Academia Americana de Artes e Ciências.

Xuedong conquistou o título de Ph.D. em EE pela Universidade de Edimburgo em 1989 (com bolsa de estudos acadêmica do British ORS e da Universidade de Edimburgo), o Mestrado em CS pela Universidade de Tsinghua em 1984 e a pós graduação em CS pela Universidade de Hunan em 1982.

Na Zoom, estamos sempre focados na inovação, que impulsiona nossa contínua exploração da transformação AI-first pelo Zoom AI Companion. No último ano, compartilhei como nossa abordagem federada entrega resultados de qualidade e como nosso foco na qualidade do reconhecimento de fala cria uma base melhor para nossos outros recursos de IA. À medida que a inteligência artificial continua a melhorar, estamos acelerando a adoção da agentic IA.

Até agora, a inteligência artificial tem se baseado em modelos de linguagem de grande escala (LLMs) para responder às solicitações dos usuários e dar respostas geradas. No entanto, há muito mais oportunidades quando consideramos como os SLMs podem viabilizar agentes de IA personalizados. Estamos criando o AI Companion para dar suporte à agentic IA para gerenciar uma série de ações multietapas em seu nome.

Quando consideramos a IA como agentes em vez de habilidades e respostas autônomas, elas vão além da inserção de instruções para dar resultados simples e, em vez disso, devem ser uma extensão de nós mesmos e de nossos objetivos. Para que isso ocorra, nossos agentes de IA têm as seguintes características:

Para que esses agentes de IA virem realidade, temos o prazer de anunciar um marco significativo nesta jornada: nosso recém-desenvolvido Modelo de Linguagem Pequena (SLM) alcançou um desempenho de ponta na categoria de 2 bilhões de parâmetros no ranking público de benchmarks. Com a personalização feita no AI Studio da Zoom (lançamento em breve), estamos desenvolvendo os SLMs da Zoom para alcançar a qualidade do LLM líder do setor em cargas de trabalho especializadas. Isso abrirá o caminho para o AI Companion realizar tarefas complexas de agentic IA com vários agentes de IA trabalhando juntos de forma incomparavelmente econômica.

Na abordagem de IA federada do Zoom, em vez de depender de um único modelo abrangente, defendemos a orquestração de vários modelos personalizados. Os SLMs da Zoom são projetados para melhorar essa abordagem, otimizando-a para tarefas específicas. Ao distribuir as cargas de trabalho em SLMs personalizados com agentes correspondentes — enquanto também aproveitamos os principais LLMs — pretendemos alcançar vários benefícios importantes:

Vamos ver o que significa esse avanço e como ele se compara exatamente aos modelos líderes.

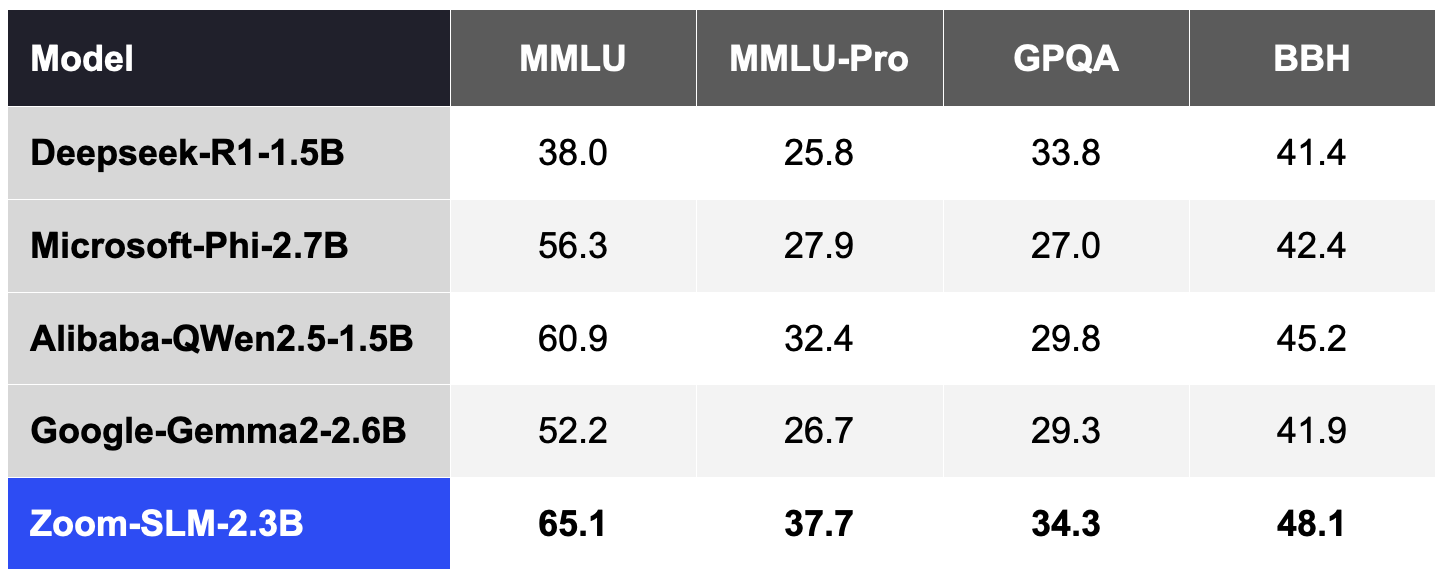

Para criar o SLM da Zoom, utilizamos 6 trilhões de tokens de dados multilíngues e 256 GPUs Nvidia H100. Do início ao fim, todo o ciclo de treinamento levou cerca de 30 dias. As tabelas a seguir descrevem como a capacidade SLM do Zoom se compara a outros modelos em vários benchmarks públicos com base nos nossos testes internos:

Seguindo a prática comum da comunidade, avaliamos a precisão desses benchmarks usando a ferramenta Lighteval, que nos deu 5 exemplos no MMLU e no MMLU-Pro, 2 exemplos no GPQA e 3 exemplos no BBH.

Tabela 1. Zoom SLM em comparação com outros SLMs na categoria 2B (quanto mais altas as pontuações, melhor).

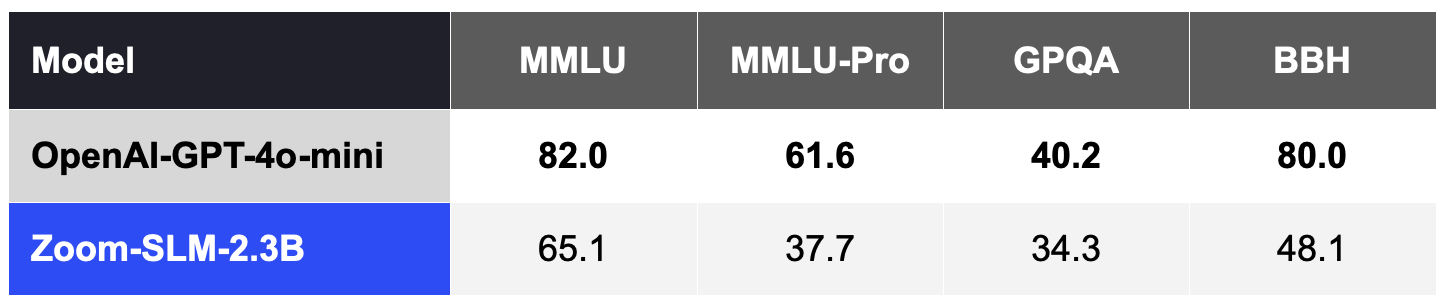

Em geral, os SLMs continuam menos competitivos nessas medidas de qualidade do que os principais LLMs, como o GPT-4o-mini da OpenAI, sem personalização para um domínio ou tarefa específica, conforme a Tabela 2.

Tabela 2. Zoom SLM, sem personalização, é menos competitivo em relação aos LLMs além da categoria 2B, como o OpenAI GPT 4o-mini.

No entanto, o resultado mais interessante é que esses SLMs podem oferecer capacidades excepcionais quando adaptados para uma tarefa especializada. Com a personalização pelo AI Studio da Zoom, esperamos diminuir efetivamente a deficiência na qualidade em relação aos LLMs mais caros. SLMs personalizados podem atuar como agentes especializados para realizar tarefas-chave em conjunto com LLMs, priorizando a melhoria da precisão, velocidade e custo-benefício de cada agente de IA.

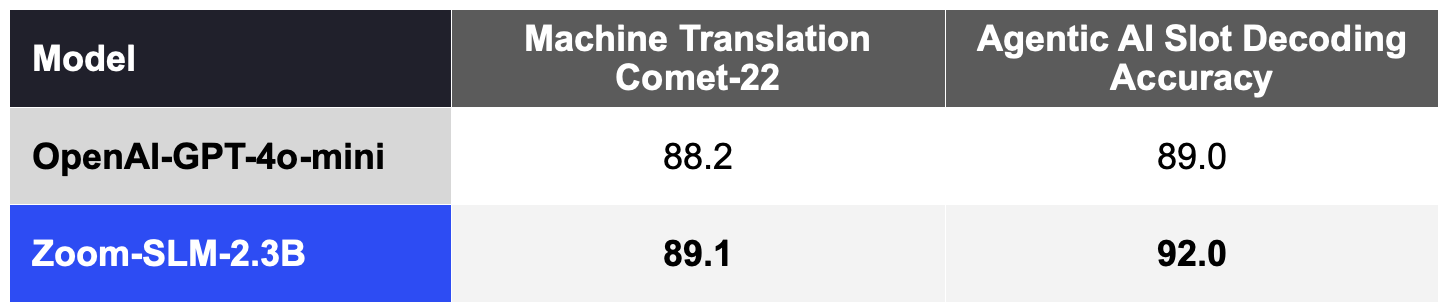

SLMs personalizados podem se destacar em tarefas como tradução automática. Ao adaptar o SLM com 11,5 bilhões de tokens (incluindo dados sintéticos) projetados para tradução automática, melhoramos significativamente as métricas de qualidade COMET-22 amplamente adotadas em 14 pares de idiomas, abrangendo idiomas principais como chinês, inglês, francês, japonês, português e espanhol , conforme a Tabela 3.

Nossos SLMs também podem ser personalizados para dar suporte ao benchmark de agentic IA do AI Companion para decodificação de slots, que mede como o modelo interpreta os comandos do usuário na execução de ações. Com 2 bilhões de tokens sintéticos para os dados do domínio de Agentic IA, o SLM personalizado também supera o GPT-4o-mini, conforme a Tabela 3.

Essa combinação de eficiência e adaptabilidade foi projetada para que a Zoom leve nossa aprimorada tradução automática para nossos clientes em todo o mundo, bem como para viabilizar o Zoom AI Studio para personalizar cargas de trabalho específicas de agentic IA.

Tabela 3. Zoom SLM Personalizado vs OpenAI GPT-4o-mini em cargas de trabalho especializadas; pontuações mais altas são melhores.

Esses SLMs personalizados serão o cerne dos nossos agentes de IA, operando de maneira mais eficiente e com resultados comparáveis aos LLMs mais caros que as pessoas usam atualmente. Usando nossa IA federada, esses agentes e habilidades de IA ajudarão a promover eficiência, redução de custos e precisão inigualáveis.

Temos orgulho de nosso progresso — e esse é apenas o começo. Nossa visão é que cada organização tenha agentes de IA que deem soluções econômicas e de alto desempenho. Com as capacidades extras dos agentes de IA e SLMs, o AI Companion cria um ambiente de trabalho onde você pode ser mais produtivo e dar o seu melhor.